Content from Introducción a la analítica de brotes

Última actualización: 2026-02-09 | Mejora esta página

Hoja de ruta

Preguntas

- ¿Cómo modelar y analizar un brote?

Objetivos

Al final de este taller usted podrá:

Identificar los parámetros necesarios en casos de transmisión de enfermedades infecciosas de persona a persona.

Estimar la probabilidad de muerte (CFR).

Calcular y graficar la incidencia.

Estimar e interpretar la tasa de crecimiento y el tiempo en que se duplica la epidemia.

Estimar e interpretar el número de reproducción instantáneo de la epidemia.

Tiempos de ejecución

Explicación del taller (10 minutos)

Realización del taller (100 minutos taller)

Parte 1: Estructura de datos y CFR (15 min)

Parte 2: Incidencia y tasa de crecimiento (45 min)

Parte 3: Rt (40 min)

Discusión 30 minutos

Introducción

Un nuevo brote de virus del Ébola (EVE) en un país ficticio de África occidental

Conceptos básicos a desarrollar

En esta práctica se desarrollarán los siguientes conceptos:

Transmisión de enfermedades infecciosas de persona a persona

Número de reproducción básico

Número de reproducción instantáneo

Probabilidad de muerte (IFR, CFR)

Intervalo serial

Tasa de crecimiento

Incidencia

Preparación previa

Antes de comenzar,

descargue la carpeta con los datos y el proyecto desde Carpetas de datos .

Ahí mismo encontrará un archivo

.Rpara instalar las dependencias necesarias para este taller.Recuerde abrir el archivo

RProjectdenominadoTaller-Brotes-Ebola.Rprojantes de empezar a trabajar.

Este paso no solo le ayudará a cumplir con las buenas prácticas de programación en R, sino también a mantener un directorio organizado, permitiendo un desarrollo exitoso del taller.

1. Estructura de datos

Cargue de librerías:

Cargue las librerías necesarias para el análisis epidemiológico. Los datos serán manipulados con tidyverse que es una colección de paquetes para la ciencia de datos.

R

library(tidyverse) # contiene ggplot2, dplyr, tidyr, readr, purrr, tibble

library(readxl) # para leer archivos Excel

library(binom) # para intervalos de confianza binomiales

library(knitr) # para crear tablas bonitas con kable()

library(incidence) # para calcular incidencia y ajustar modelos

library(EpiEstim) # para estimar R(t)

Cargue de bases de datos

Se le ha proporcionado la siguiente base de datos:

-

casos: una base de datos de casos que contiene información de casos hasta el 1 de julio de 2014.

Para leer en R este archivo, utilice la función read_rds

de tidyverse. Se creará una tabla de datos almacenada como

objeto de clase tibble.

R

casos <- read_rds("data/casos.rds")

Estructura de los datos

Explore la estructura de los datos. Para esto puede utilizar la

función glimpse de tidyverse, la cual nos

proporciona una visión rápida y legible de la estructura interna de

nuestro conjunto de datos.

R

glimpse(casos)

SALIDA

Rows: 166

Columns: 11

$ id_caso <chr> "d1fafd", "53371b", "f5c3d8", "6c286a", "0f58…

$ generacion <dbl> 0, 1, 1, 2, 2, 0, 3, 3, 2, 3, 4, 3, 4, 2, 4, …

$ fecha_de_infeccion <date> NA, 2014-04-09, 2014-04-18, NA, 2014-04-22, …

$ fecha_inicio_sintomas <date> 2014-04-07, 2014-04-15, 2014-04-21, 2014-04-…

$ fecha_de_hospitalizacion <date> 2014-04-17, 2014-04-20, 2014-04-25, 2014-04-…

$ fecha_desenlace <date> 2014-04-19, NA, 2014-04-30, 2014-05-07, 2014…

$ desenlace <chr> NA, NA, "Recuperacion", "Muerte", "Recuperaci…

$ genero <fct> f, m, f, f, f, f, f, f, m, m, f, f, f, f, f, …

$ hospital <fct> Military Hospital, Connaught Hospital, other,…

$ longitud <dbl> -13.21799, -13.21491, -13.22804, -13.23112, -…

$ latitud <dbl> 8.473514, 8.464927, 8.483356, 8.464776, 8.452…Como puede observar contactos tiene 11 columnas (variables) y 166

filas de datos. En un rápido vistazo puede observar el tipo de las

variables por ejemplo, la columna desenlace tiene formato

carácter (chr) y contiene entre sus valores

"Recuperación" o "Muerte".

Además, puede encontrar estas variables:

El identificador

id_casoLa generación de infectados (cuantas infecciones secundarias desde la fuente hasta el sujeto han ocurrido)

La fecha de infección

La fecha de inicio de síntomas

La fecha de hospitalización

La fecha del desenlace que, como se puede observar, en la siguiente variable puede tener entre sus opciones

NA(no hay información hasta ese momento o no hay registro), recuperación y muerteLa variable género que puede ser

fde femenino omde masculinoEl lugar de hospitalización, en la variable hospital

Y las variables longitud y latitud

Note que las fechas ya están en formato fecha

(date).

2. CFR

Probabilidad de muerte en los casos reportados (CFR,

por Case Fatality Risk)

R

table(casos$desenlace, useNA = "ifany")

SALIDA

Muerte Recuperacion <NA>

60 43 63 Desafío 1

Calcule la probabilidad de muerte en los casos reportados

(CFR) tomando el número de muertes y el número de casos con

desenlace final conocido del objeto casos. Esta vez se

calculará el CFR con el método Naive. Los cálculos

Naive (inocentes) tienen el problema de que pueden

presentar sesgos, por lo que no deberían ser utilizados para informar

decisiones de salud pública. Hablaremos de estos sesgos en profundidad

en el día 4.

Durante este taller se le presentarán algunos retos, para los cuales

obtendrá algunas pistas, por ejemplo en el presente reto se le presenta

una pista, la cual es un fragmento del código que usted debe completar

para alcanzar la solución. En los espacios donde dice

COMPLETE por favor diligencie el código faltante.

R

muertes <- COMPLETE

casos_desenlace_final_conocido <- sum(casos$desenlace %in% c("Muerte", "Recuperacion"))

CFR <- COMPLETE / COMPLETE

Ejemplo,

R

# Reto

muertes <- COMPLETE

#Solución

muertes <- sum(casos$desenlace %in% "Muerte")

SALIDA

[1] 0.5825243Para complementar el calculo del CFR se pueden calcular sus

intervalos de confianza por medio de la función

binom.confint. La función binom.confint se

utiliza para calcular intervalos de confianza para una proporción en una

distribución binomial, que corresponde, por ejemplo, a cuando tenemos el

total de infecciones con desenlace final conocido (recuperado o muerte).

Esta función pide tres argumentos: 1) el número de muertes y 2) el

número total de casos con desenlace final conocido, es decir sin

importar que hayan muerto o se hayan recuperado, pero sin cuenta los

datos con NA; 3) el método que se utilizará para calcular

los intervalos de confianza, en este caso “exact” (método

Clopper-Pearson).

Desafío 2

Determine el CFR con sus intervalos de confianza utilizando la

función binom.confint. Y obtenga este resultado:

| method | x | n | mean | lower | upper |

|---|---|---|---|---|---|

| exact | 60 | 103 | 0.5825243 | 0.4812264 | 0.6789504 |

Recuerde diligenciar los espacios donde dice COMPLETE. Y

obtenga este resultado

R

CFR_con_CI <- binom.confint(COMPLETE, COMPLETE, method = "COMPLETE") %>%

kable(caption = "**COMPLETE ¿QUE TITULO LE PONDRÍA?**")

CFR_con_CI

3. Incidencia

3.1. Curva de incidencia diaria

El paquete incidence es de gran utilidad para el

análisis epidemiológico de datos de incidencia de enfermedades

infecciosas, dado que permite calcular la incidencia a partir del

intervalo temporal suministrado (e.g. diario o semanal). Dentro de este

paquete esta la función incidence la cual cuenta con los

siguientes argumentos:

datescontiene una variable con fechas que representan cuándo ocurrieron eventos individuales, como por ejemplo la fecha de inicio de los síntomas de una enfermedad en un conjunto de pacientes.intervales un intervalo de tiempo fijo por el que se quiere calcular la incidencia. Por ejemplo,interval = 365para un año. Si no se especifica, el valor por defecto es diario.last_datefecha donde se establecerá un limite temporal para los datos. Por ejemplo, la última fecha de hospitalización. Para este tercer argumento, podemos incluir la opciónmaxy la opciónna.rm. La primera para obtener la última fecha de una variable y la segunda para ignorar losNAen caso de que existan.

Por ejemplo, se podría escribir

last_date = max(base_de_datos$vector_ultima_fecha, na.rm = TRUE)

Con esta información la función agrupa los casos según el intervalo de tiempo especificado y cuenta el número de eventos (como casos de enfermedad) que ocurrieron dentro de cada intervalo.

Desafío 3

Calcule la incidencia diaria usando únicamente el primer argumento de

la función incidence ¿Qué fecha sería la más adecuada?

Tenga en cuenta que se espera que esta sea la que pueda dar mejor

información, es decir la menor cantidad de NAs.

R

incidencia_diaria <- incidence(COMPLETE)

incidencia_diaria

El resultado es un objeto de clase incidencia

(incidence) que contiene el recuento de casos para cada

intervalo de tiempo, lo que facilita su visualización y análisis

posterior. Como puede observar la función produjo los siguientes

datos:

SALIDA

<incidence object>

[166 cases from days 2014-04-07 to 2014-06-29]

$counts: matrix with 84 rows and 1 columns

$n: 166 cases in total

$dates: 84 dates marking the left-side of bins

$interval: 1 day

$timespan: 84 days

$cumulative: FALSEComo resultado de la función se produjo un objeto tipo lista. Este

objeto arroja estos datos: 166 casos contemplados entre los

días 2014-04-07 al 2014-06-29 para un total de

84 días; se menciona que el intervalo es de

1 día, dado que no se utilizo específico explicitamente el

parámetro por lo cual quedó su valor por defecto. Finalmente se menciona

“cumulative : FALSE” lo que quiere decir que no se esta

haciendo el acumulado de la incidencia, es decir que los casos

corresponden a los del intervalo interval: 1 day, es decir

a los casos nuevos cada día en específico.

Ahora haga una gráfica de la incidencia diaria.

R

plot(incidencia_diaria, border = "black")

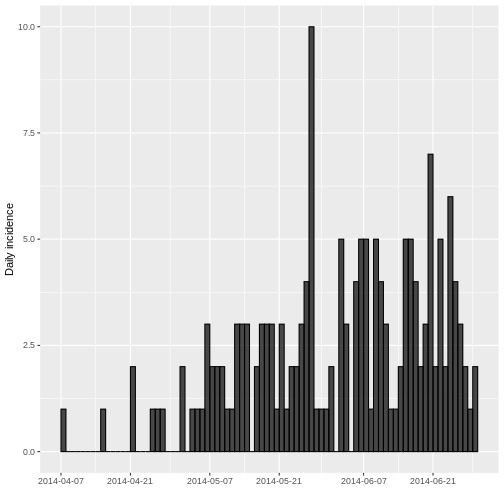

En el Eje X (Fechas): Se puede observar fechas van desde

el 7 de abril de 2014 hasta una fecha posterior al

21 de junio de 2014. Estas fechas representan el período de

observación del brote.

En el Eje Y (Incidencia Diaria): La altura de las barras

indica el número de nuevos casos reportados cada fecha según el tipo de

fecha escogido.

Dado que no se agregó el parámetro interval la

incidencia quedó por defecto diaria, produciéndose un histograma en el

que cada barra representa la incidencia de un día, es decir, los casos

nuevos. Los días sin barras sugieren que no hubo casos nuevos para esa

fecha o que los datos podrían no estar disponibles para esos días.

A pesar de que hay una curva creciente, hay periodos con pocos o ningún caso. ¿Porque cree que podrían darse estos periodos de pocos a pesar de la curva creciente?

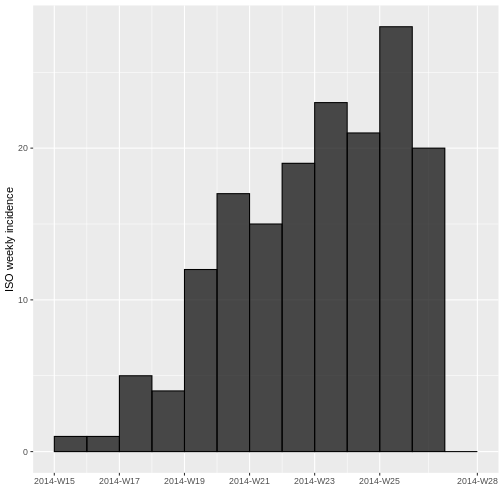

3.2. Cálculo de la incidencia semanal

Teniendo en cuenta lo aprendido con respecto a la incidencia diaria,

cree una variable para incidencia semanal. Luego, interprete el

resultado y haga una gráfica. Para escoger la fecha que utilizará como

última fecha debe asignarle un valor al argumento last_date

de la función incidence ¿Qué fecha sería la más adecuada?

Tenga en cuenta que la fecha debe ser posterior a la fecha que se haya

escogido como el primer argumento.

Desafío 4

R

incidencia_semanal <- incidence(PRIMER ARGUMENTO, #COMPLETE

SEGUNDO ARGUMENTO, #COMPLETE

TERCER ARGUMENTO) #COMPLETESALIDA

<incidence object>

[166 cases from days 2014-04-07 to 2014-06-30]

[166 cases from ISO weeks 2014-W15 to 2014-W27]

$counts: matrix with 13 rows and 1 columns

$n: 166 cases in total

$dates: 13 dates marking the left-side of bins

$interval: 7 days

$timespan: 85 days

$cumulative: FALSE

Compare la gráfica de incidencia diaria con la de incidencia semanal. ¿Qué observa? ¿Los datos se comportan diferente? ¿Es lo que esperaba? ¿Logra observar alguna tendencia?

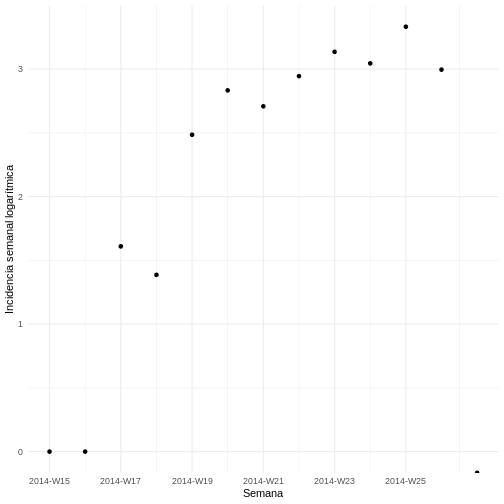

4. Tasa de crecimiento

4.1. Modelo log-lineal

Estimación de la tasa de crecimiento mediante un modelo log-lineal

Para observar mejor las tendencias de crecimiento en el número de casos se puede visualizar la incidencia semanal en una escala logarítmica. Esto es particularmente útil para identificar patrones exponenciales en los datos.

Grafique la incidencia transformada logarítmicamente:

R

ggplot(as.data.frame(incidencia_semanal)) +

geom_point(aes(x = dates, y = log(counts))) +

scale_x_incidence(incidencia_semanal) +

xlab("Semana") +

ylab("Incidencia semanal logarítmica") +

theme_minimal()

Ajuste un modelo log-lineal a los datos de incidencia semanal

R

ajuste_modelo <- incidence::fit(incidencia_semanal)

ajuste_modelo

SALIDA

<incidence_fit object>

$model: regression of log-incidence over time

$info: list containing the following items:

$r (daily growth rate):

[1] 0.04145251

$r.conf (confidence interval):

2.5 % 97.5 %

[1,] 0.02582225 0.05708276

$doubling (doubling time in days):

[1] 16.72148

$doubling.conf (confidence interval):

2.5 % 97.5 %

[1,] 12.14285 26.84302

$pred: data.frame of incidence predictions (12 rows, 5 columns)Desafío 5

¿Qué observa en este resultado?

$model: Indica que se ha realizado una regresión

logarítmica de la incidencia en función del tiempo. Esto implica que la

relación entre el tiempo y la incidencia de la enfermedad ha sido

modelada como una función lineal en escala logarítmica en la incidencia

con el fin de entender mejor las tendencias de crecimiento.

$info: Contiene varios componentes importantes del

análisis:

-

$r (daily growth rate)Tasa de crecimiento diaria:0.04145251

La tasa de crecimiento diaria estimada del brote es de

0.0415. Esto significa que cada día la cantidad de casos

está creciendo en un 4.15% con respecto al día anterior,

bajo la suposición de un crecimiento exponencial constante durante el

periodo modelado.

Si quisiera acceder a esta información sin ingresar al modelo podría hacerlo con el siguiente código:

R

tasa_crecimiento_diaria <- ajuste_modelo$info$r

cat("La tasa de crecimiento diaria es:", tasa_crecimiento_diaria, "\n")

SALIDA

La tasa de crecimiento diaria es: 0.04145251 -

$r.conf(confidence interval): 2.5 % 0.02582225 97.5 % 0.05708276

El intervalo de confianza del 95% para la tasa de

crecimiento diaria está entre 0.0258 (2.58%) y

0.0571 (5.71%).

$doubling (doubling time in days): 16.72148

- El tiempo de duplicación estimado del número de casos nuevos es de

aproximadamente

16.72 días. Esto significa que, bajo el modelo actual y con la tasa de crecimiento estimada, se espera que el número de casos de la curva epidémica actual se duplique cada16.72 días.

$doubling.conf (confidence interval): 2.5 % 12.14285

97.5 % 26.84302

- El intervalo de confianza del

95%para el tiempo de duplicación está entre aproximadamente12.14y26.84 días. Este amplio rango refleja la incertidumbre en la estimación y puede ser consecuencia de la variabilidad en los datos o de un tamaño de muestra pequeño.

$pred: Contiene las predicciones de incidencia

observada. Incluye las fechas, la escala de tiempo en días desde el

inicio del brote, los valores ajustados (predicciones) y los límites

inferior y superior del intervalo de confianza para las

predicciones.

Si quiere conocer un poco más de este componente puede explorarlo con

la función glimpse.

R

glimpse(ajuste_modelo$info$pred)

¿El modelo se ajusta bien a los datos? Verifique el \(R^2\)

R

AjusteR2modelo <- summary(ajuste_modelo$model)$adj.r.squared

cat("El R cuadrado ajustado es:", AjusteR2modelo, "\n")

SALIDA

El R cuadrado ajustado es: 0.7551113 Antes de continuar ¿Considera más adecuado usar una gráfica semanal para buscar un ajuste de los datos? ¿Por qué?

¿Es preferible calcular la tasa de crecimiento diaria con el ajuste semanal y no con el ajuste diario?

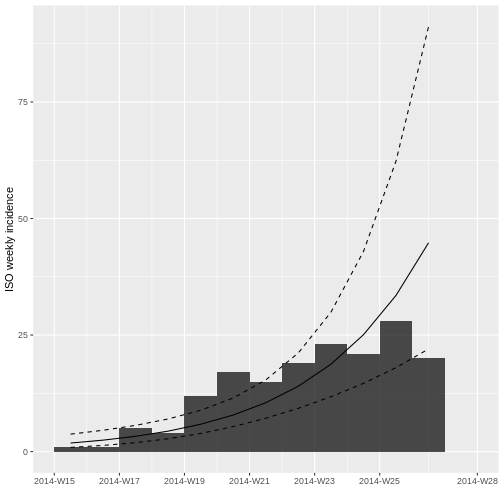

Grafique la incidencia incluyendo una línea que represente el modelo.

Con plot

R

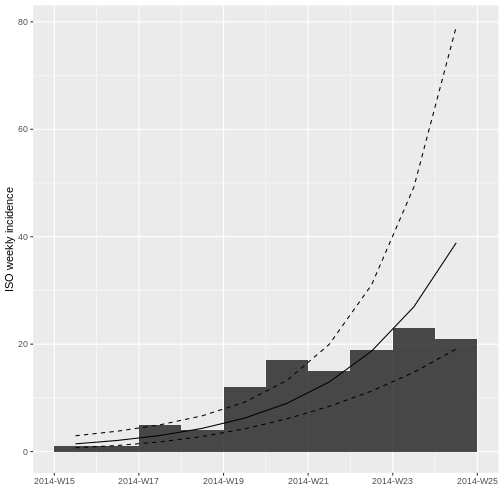

plot(incidencia_semanal, fit = ajuste_modelo)

Tras ajustar el modelo log-lineal a la incidencia semanal para estimar la tasa de crecimiento de la epidemia, el gráfico muestra la curva de ajuste superpuesta a la incidencia semanal observada.

Al final del gráfico se puede observar que la incidencia semanal disminuye.

¿Porqué cree que podría estar pasando esto? ¿Cómo lo solucionaría?

4.2. Modelo log-lineal con datos truncados

Encuentre una fecha límite adecuada para el modelo log-lineal, en función de los rezagos (biológicos y administrativos).

Dado que esta epidemia es de Ébola y la mayoría de los casos van a ser hospitalizados, es muy probable que la mayoría de las notificaciones ocurran en el momento de la hospitalización. De tal manera que podríamos examinar cuánto tiempo transcurre entre la fecha de inicio de síntomas y la fecha de hospitalización para hacernos una idea del rezago para esta epidemia.

R

summary(as.numeric(casos$fecha_de_hospitalizacion - casos$fecha_inicio_sintomas))

SALIDA

Min. 1st Qu. Median Mean 3rd Qu. Max.

0.00 1.00 2.00 3.53 5.00 22.00 Al restar la fecha de hospitalización a la fecha de inicio de síntomas podría haber valores negativos. ¿Cuál cree que sea su significado? ¿Ocurre en este caso?

Para evitar el sesgo debido a rezagos en la notificación, se pueden truncar los datos de incidencia. Pruebe descartar las últimas dos semanas. Este procedimiento permite concentrarse en el periodo en que los datos son más completos para un análisis más fiable.

Semanas a descartar al final de la epicurva

R

semanas_a_descartar <- 2

fecha_minima <- min(incidencia_diaria$dates)

fecha_maxima <- max(incidencia_diaria$dates) - semanas_a_descartar * 7

# Para truncar la incidencia semanal

incidencia_semanal_truncada <- subset(incidencia_semanal,

from = fecha_minima,

to = fecha_maxima) # descarte las últimas semanas de datos

# Incidencia diaria truncada. No la usamos para la regresión lineal pero se puede usar más adelante

incidencia_diaria_truncada <- subset(incidencia_diaria,

from = fecha_minima,

to = fecha_maxima) # eliminamos las últimas dos semanas de datos

Desafío 6

Ahora utilizando los datos truncados

incidencia_semanal_truncada vuelva a ajustar el modelo

logarítmico lineal.

SALIDA

<incidence_fit object>

$model: regression of log-incidence over time

$info: list containing the following items:

$r (daily growth rate):

[1] 0.05224047

$r.conf (confidence interval):

2.5 % 97.5 %

[1,] 0.03323024 0.0712507

$doubling (doubling time in days):

[1] 13.2684

$doubling.conf (confidence interval):

2.5 % 97.5 %

[1,] 9.728286 20.85893

$pred: data.frame of incidence predictions (10 rows, 5 columns)¿Cámo interpreta estos resultados? ¿Compare los \(R^2\)?

Desafío 7

Ahora utilizando los datos truncados

incidencia_semanal_truncada vuelva a graficar el modelo

logarítmico lineal.

¿Qué cambios observa?

Observe las estadísticas resumidas del ajuste:

R

summary(ajuste_modelo_truncado$model)

SALIDA

Call:

stats::lm(formula = log(counts) ~ dates.x, data = df)

Residuals:

Min 1Q Median 3Q Max

-0.73474 -0.31655 -0.03211 0.41798 0.65311

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) 0.186219 0.332752 0.560 0.591049

dates.x 0.052240 0.008244 6.337 0.000224 ***

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

Residual standard error: 0.5241 on 8 degrees of freedom

Multiple R-squared: 0.8339, Adjusted R-squared: 0.8131

F-statistic: 40.16 on 1 and 8 DF, p-value: 0.0002237El modelo muestra que hay una relación significativa

(R-squared: 0.8131) entre el tiempo (dates.x)

y la incidencia de la enfermedad, por lo que concluimos que la

enfermedad muestra un crecimiento exponencial a lo largo del tiempo.

4.3. Tasa de crecimiento y tasa de duplicación: extracción de datos

Estimacion de la tasa de crecimiento

Para estimar la tasa de crecimiento de una epidemia utilizando un modelo log-lineal es necesario realizar un ajuste de regresión a los datos de incidencia. Dado que ya tiene un objeto de incidencia truncado y un modelo log-lineal ajustado, puede proceder a calcular la tasa de crecimiento diaria y el tiempo de duplicación de la epidemia.

El modelo log-lineal proporcionará los coeficientes necesarios para estos cálculos. Note que el coeficiente asociado con el tiempo (la pendiente de la regresión) se puede interpretar como la tasa de crecimiento diaria cuando el tiempo se expresa en días.

Con el modelo ajustado truncado, es hora de realizar la estimación de

la tasa de crecimiento. Estos datos los puede encontrar en el objeto

ajuste modelo semana, que tiene los datos ajustados de

incidencia semanal truncada.

Desafío 8

Por favor escriba el código para obtener los siguientes valores:

SALIDA

La tasa de crecimiento diaria es: 0.05224047 SALIDA

Intervalo de confianza de la tasa de crecimiento diaria (95%): 0.03323024 0.0712507 Si no lo recuerda, vuelva por pistas a la sección Ajuste un modelo log-lineal a los datos de incidencia semanal

Ahora que ya ha obtenido la tasa de crecimiento diaria y sus intervalos de confianza, puede pasar a estimar el tiempo de duplicación.

Estimación del tiempo de duplicación

Esta información también la encontrará calculada y lista para

utilizar en el objeto ajuste_modelo_truncado, que tiene los

datos ajustados de incidencia semanal truncada.

Desafío 9

Por favor escriba el código para obtener los siguientes valores:

SALIDA

El tiempo de duplicación de la epidemia es 13.2684 díasSALIDA

Intervalo de confianza del tiempo de duplicación (95%): 9.728286 20.85893 Si no lo recuerda vuelva por pistas a la sección Ajuste un modelo log-lineal a los datos de incidencia semanal

5. Estimación de número de reproducción

Evaluar la velocidad a la que se propaga una infección en una población es una tarea importante a la hora de informar la respuesta de salud pública a una epidemia.

Los números de reproducción son métricas típicas para monitorear el desarrollo de epidemias y son informativos sobre su velocidad de propagación. El Número de reproducción básico \(R_0\), por ejemplo, mide el número promedio de casos secundarios producidos por un individuo infeccioso dada una población completamente susceptible. Esta hipótesis suele ser válida solo al inicio de una epidemia.

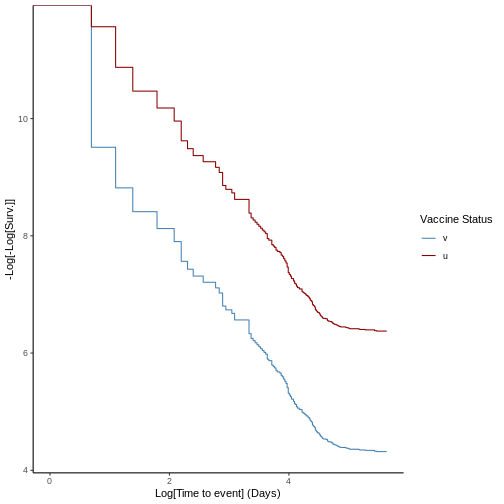

Para caracterizar el la propagación en tiempo real es más común utilizar el Número de reproducción instantáneo \(R_t\), el cual describe el número promedio de casos secundarios generados por un individuo infeccioso en el tiempo \(t\) dado que no han habido cambios en las condiciones actuales.

En esta sección exploraremos los conceptos necesarios para calcular el Número de reproducción instantáneo, así como los pasos a seguir para estimarlo por medio del paquete de R EpiEstim.

5.1. Intervalo serial (SI)

¿Qué es el intervalo serial?

El intervalo serial en epidemiología se refiere al tiempo que transcurre entre el momento en que una persona infectada (el caso primario) comienza a mostrar síntomas y el momento en que la persona que fue infectada por ella (el caso secundario) comienza a mostrar síntomas.

Este intervalo es importante porque ayuda a entender qué tan rápido se está propagando una enfermedad y a diseñar estrategias de control como el rastreo de contactos y la cuarentena. Si el intervalo serial es corto, puede significar que la enfermedad se propaga rápidamente y que es necesario actuar con urgencia para contenerla. Si es largo, puede haber más tiempo para intervenir antes de que la enfermedad se disemine ampliamente.

Para este brote de Ébola asumiremos que el intervalo serial está

descrito por una distribución Gamma de media (mean_si) de

8.7 días y con una desviación estándar

(std_si) de 6.1 días. En la práctica del día 4

estudiaremos cómo estimar el intervalo serial.

R

# Parametros de la distribución gamma para el invertavlo serial

mean_si <- 8.7

std_si <- 6.1

config <- make_config(list(mean_si = mean_si, std_si = std_si))

# t_start y t_end se configuran automáticamente para estimar R en ventanas deslizantes para 1 semana de forma predeterminada.

5.2. Estimación de la transmisibilidad variable en el tiempo, R(t)

Cuando la suposición de que (\(R\))

es constante en el tiempo se vuelve insostenible, una alternativa es

estimar la transmisibilidad variable en el tiempo utilizando el Número

de reproducción instantáneo (\(R_t\)).

Este enfoque, introducido por Cori et al. (2013), se implementa en el

paquete EpiEstim, el cual estima el \(R_t\) para ventanas de tiempo

personalizadas, utilizando una distribución de Poisson. A continuación,

estimamos la transmisibilidad para ventanas de tiempo deslizantes de 1

semana (el valor predeterminado de estimate_R):

R

config <- make_config(list(mean_si = mean_si, std_si = std_si))

# t_start y t_end se configuran automáticamente para estimar R en ventanas deslizantes para 1 semana de forma predeterminada.

R

# use estimate_R using method = "parametric_si"

estimacion_rt <- estimate_R(incidencia_diaria_truncada, method = "parametric_si",

si_data = si_data,

config = config)

# Observamos las primeras estimaciones de R(t)

head(estimacion_rt$R[, c("t_start", "t_end", "Median(R)",

"Quantile.0.025(R)", "Quantile.0.975(R)")])

SALIDA

t_start t_end Median(R) Quantile.0.025(R) Quantile.0.975(R)

1 2 8 NA NA NA

2 3 9 2.173592 0.3136801 7.215718

3 4 10 2.148673 0.3100840 7.132996

4 5 11 2.060726 0.2973920 6.841036

5 6 12 1.960940 0.2829915 6.509775

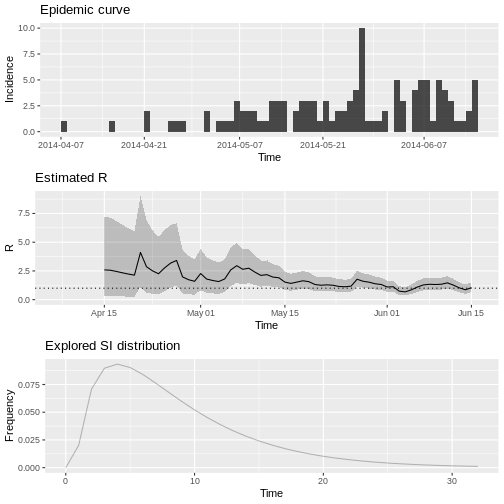

6 7 13 1.869417 0.2697834 6.205943Grafique la estimación de \(R\) como función del tiempo:

R

plot(estimacion_rt, legend = FALSE)

Sobre este documento

Este documento ha sido una adaptación de los materiales originales disponibles en RECON Learn

Contribuciones

Autores originales:

Anne Cori

Natsuko Imai

Finlay Campbell

Zhian N. Kamvar

Thibaut Jombart

Cambios menores y adaptación a español:

José M. Velasco-España

Cándida Díaz-Brochero

Nicolas Torres

Zulma M. Cucunubá

Puntos clave

Revise si al final de esta lección adquirió estas competencias:

Identificar los parámetros necesarios en casos de transmisión de enfermedades infecciosas de persona a persona.

Estimar la probabilidad de muerte (CFR).

Calcular y graficar la incidencia.

Estimar e interpretar la tasa de crecimiento y el tiempo en el que se duplica la epidemia.

Estimar e interpretar el número de reproducción instantáneo de la epidemia.

Content from Construyendo un modelo matemático simple para Zika

Última actualización: 2026-02-09 | Mejora esta página

Hoja de ruta

Preguntas

- ¿Cómo construir un modelo simplificado de zika?

Objetivos

Al final de este taller usted podrá:

- Aplicar conceptos como parámetros, \(R_0\) e inmunidad de rebaño, aprendidos en la sesión A del taller

- Traducir fórmulas matemáticas de las interacciones entre los parámetros del modelo a código de R

- Realizar un modelo simple en R para una enfermedad transmitida por vector

- Discutir cambios en las proyecciones del modelo cuando se instauran diferentes estrategias de control de la infección

1. Introducción

En este taller usted aplicará los conceptos básicos del modelamiento de Enfermedades Transmitidas por Vectores (ETV) mediante el uso del lenguaje R con énfasis en el funcionamiento de los métodos, utilizando como ejemplo un modelo básico de infección por un arbovirus: el virus del Zika.

2. Agenda

- Instrucciones (5 mins)

- Desarrollo taller Zika Parte B (45 mins con acompañamiento de monitores)

- Revisión grupal del código (10 mins)

- Revisión de resultados (20 mins)

- Descanso (25 mins)

- Discusión final (60 mins)

3. Conceptos básicos a desarrollar

En esta práctica se desarrollarán los siguientes conceptos:

- Modelo SIR para ETV Zika

- Parametrización de un modelo dinámico

- Evaluación de un modelo dinámico

- Parametrización de intervenciones de control (fumigación, mosquiteros y vacunación) para una ETV

4. Paquetes requeridos

Cargue los paquetes necesarios ingresando en R los siguientes comandos:

R

library(deSolve) # Paquete deSolve para resolver las ecuaciones diferenciales

library(tidyverse) # Paquetes ggplot2 y dplyr de tidyverse

library(cowplot) # Paquete gridExtra para unir gráficos.

- Si desea puede tomar notas en el script de R, para esto se recomienda usar el símbolo de comentario # después de cada línea de código (ver ejemplo arriba). O podría utilizar un archivo Rmd para tener un aspecto similar al del taller.

5. Compartimentos del modelo básico de Zika

- \(S_h\) : Humanos susceptibles

- \(I_h\) : Humanos infecciosos

- \(R_h\) : Humanos recuperados de la infección (inmunizados frente a nueva infección)

- \(S_v\) : Vectores susceptibles

- \(E_v\) : Vectores expuestos

- \(I_v\) : Vectores infecciosos

6. Parámetros del modelo

Ahora se usarán los parámetros que discutimos en la parte A del taller. Si aún no los tiene, estos se pueden encontrar en la guía de aprendizaje de la parte A del taller.

Desafío 1

Busque los valores de los parámetros del modelo y diligéncielos en el recuadro de abajo. Tenga en cuenta que todos los parámetros usados tienen la misma unidad de tiempo (días).

R

Lv <- # Esperanza de vida de los mosquitos (en días)

Lh <- # Esperanza de vida de los humanos (en días)

PIh <- # Periodo infeccioso en humanos (en días)

PIv <- # Periodo infeccioso en vectores (en días)

PEI <- # Período extrínseco de incubación en mosquitos adultos (en días)

muv <- # Tasa per capita de mortalidad del vector (1/Lv)

muh <- # Tasa per capita de mortalidad del hospedador (1/Lh)

alphav <- # Tasa per capita de natalidad del vector

alphah <- # Tasa per capita de natalidad del hospedador

gamma <- # Tasa de recuperación en humanos (1/PIh)

delta <- # Tasa extrínseca de incubación (1/PEI)

ph <- # Probabilidad de transmisión del vector al hospedador dada una picadura por un mosquito infeccioso a un humano susceptible

pv <- # Probabilidad de transmisión del hospedador al vector dada una picadura por un mosquito susceptible a un humano infeccioso

Nh <- # Número de humanos

m <- # Densidad de mosquitos hembra por humano

Nv <- # Número de vectores (m * Nh)

R0 <- # Número reproductivo básico

b <- sqrt((R0 * muv*(muv+delta) * (muh+gamma)) /

(m * ph * pv * delta)) # Tasa de picadura

betah <- # Coeficiente de transmisión del mosquito al humano

betav <- # Coeficiente de transmisión del humano al mosquito

TIME <- # Número de años que se va a simular 7. Ecuaciones del modelo

Para este modelo emplearemos las siguientes ecuaciones diferenciales:

8. Fórmula para calcular \(R_0\) (Número reproductivo básico)

Fórmula necesaria para estimar \(R_0\):

\[ R_0 = \frac{mb^2 p_h p_v \delta}{\mu_v (\mu_v+\delta)(\mu_h+\gamma)} \]

9. Modelo en R

Es hora de implementar el modelo en R. Para lograrlo, usaremos la

función ode del paquete desolve. Para el ejercicio

se emplearán 4 argumentos de la función esta función: el primero son las

condiciones iniciales del modelo (argumento y); el segundo

es la secuencia temporal donde se ejecutará el modelo (argumento

times); el tercero es una función que contiene las

ecuaciones diferenciales que entrarán al sistema (argumento

fun); por último un vector que contiene los parámetros con

los que se calculará el sistema (argumento parms).

R

# NO la copie a R sólo tiene fines ilustrativos.

ode(y = # Condiciones iniciales,

times = # Tiempo,

fun = # Modelo o función que lo contenga,

parms = # Parámetros

)Desafío 2

En esta sección se empezará por crear la función (argumento

fun), para ello es necesario traducir las ecuaciones del

modelo a R. Abajo encontrará la función ya construida, por favor

reemplace los parámetros faltantes (Cambie PAR por los

parámetro correspondientes) en las ecuaciones:

R

arbovmodel <- function(t, x, params) {

Sh <- x[1] # Humanos susceptibles

Ih <- x[2] # Humanos infecciosos

Rh <- x[3] # Humanos recuperados

Sv <- x[4] # Vectores susceptibles

Ev <- x[5] # Vectores expuestos

Iv <- x[6] # Vectores infecciosos

with(as.list(params), # entorno local para evaluar derivados

{

# Humanos

dSh <- PAR * Nh - PAR * (Iv/Nh) * Sh - PAR * Sh

dIh <- PAR * (Iv/Nh) * Sh - (PAR + PAR) * Ih

dRh <- PAR * Ih - PAR * Rh

# Vectores

dSv <- alphav * Nv - PAR * (Ih/Nh) * Sv - PAR * Sv

dEv <- PAR * (Ih/Nh) * Sv - (PAR + PAR)* Ev

dIv <- PAR * Ev - PAR * Iv

dx <- c(dSh, dIh, dRh, dSv, dEv, dIv)

list(dx)

}

)

}

10. Resuelva el Sistema

En esta sección se crearán los tres argumentos faltantes para usar la

función ode y se creará un objeto de clase

data.frame con los resultados de la función

ode. Por favor complete y comente el código para:

Los VALORES de las condiciones iniciales del sistema.

Los ARGUMENTOS de la función

odeen el paquete deSolve.

Desafío 3

R

# Secuencia temporal (times)

times <- seq(1, 365 * TIME , by = 1)

# Los parámetros (parms)

params <- c(

muv = muv,

muh = muh,

alphav = alphav,

alphah = alphah,

gamma = gamma,

delta = delta,

betav = betav,

betah = betah,

Nh = Nh,

Nv = Nv

)

# Condiciones iniciales del sistema (y)

xstart <- c(Sh = VALOR?, # COMPLETE Y COMENTE

Ih = VALOR?, # COMPLETE Y COMENTE

Rh = VALOR?, # COMPLETE Y COMENTE

Sv = VALOR?, # COMPLETE Y COMENTE

Ev = VALOR?, # COMPLETE Y COMENTE

Iv = VALOR?) # COMPLETE Y COMENTE

# Resuelva las ecuaciones

out <- as.data.frame(ode(y = ARGUMENTO?, # COMPLETE Y COMENTE

times = ARGUMENTO?, # COMPLETE Y COMENTE

fun = ARGUMENTO?, # COMPLETE Y COMENTE

parms = ARGUMENTO?)) # COMPLETE Y COMENTE11. Resultados

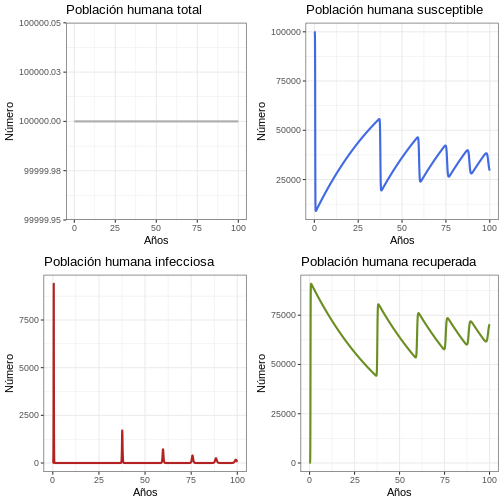

Observe el comportamiento del modelo en distintas escalas de tiempo (semanas y años):

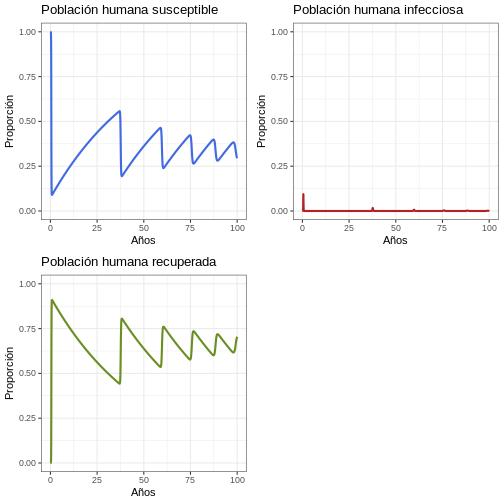

11.1 Comportamiento General (Población humana)

R

# Revise el comportamiento general del modelo para 100 años

p1h <- ggplot(data = out, aes(y = (Rh + Ih + Sh), x = years)) +

geom_line(color = 'grey68', size = 1) +

ggtitle('Población humana total') +

theme_bw() + ylab('Número') + xlab('Años')

p2h <- ggplot(data = out, aes(y = Sh, x = years)) +

geom_line(color = 'royalblue', size = 1) +

ggtitle('Población humana susceptible') +

theme_bw() + ylab('Número') + xlab('Años')

p3h <- ggplot(data = out, aes(y = Ih, x = years)) +

geom_line(color = 'firebrick', size = 1) +

ggtitle('Población humana infecciosa') +

theme_bw() + ylab('Número') + xlab('Años')

p4h <- ggplot(data = out, aes(y = Rh, x = years)) +

geom_line(color = 'olivedrab', size = 1) +

ggtitle('Población humana recuperada') +

theme_bw() + ylab('Número') + xlab('Años')

plot_grid(p1h, p2h, p3h, p4h, ncol = 2)

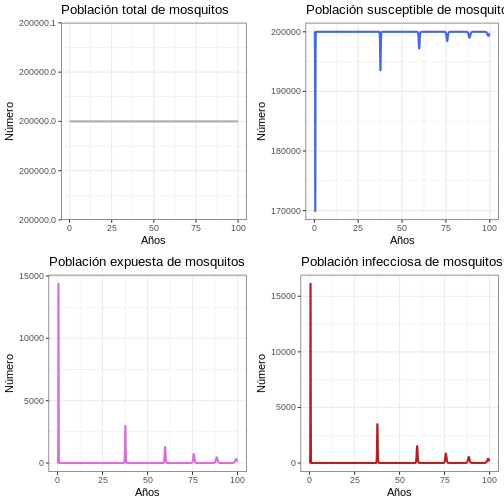

11.2 Comportamiento General (Población de vectores)

R

# Revise el comportamiento general del modelo

p1v <- ggplot(data = out, aes(y = (Sv + Ev + Iv), x = years)) +

geom_line(color = 'grey68', size = 1) +

ggtitle('Población total de mosquitos') +

theme_bw() + ylab('Número') + xlab('Años')

p2v <- ggplot(data = out, aes(y = Sv, x = years)) +

geom_line(color = 'royalblue', size = 1) +

ggtitle('Población susceptible de mosquitos') +

theme_bw() + ylab('Número') + xlab('Años')

p3v <- ggplot(data = out, aes(y = Ev, x = years)) +

geom_line(color = 'orchid', size = 1) +

ggtitle('Población expuesta de mosquitos') +

theme_bw() + ylab('Número') + xlab('Años')

p4v <- ggplot(data = out, aes(y = Iv, x = years)) +

geom_line(color = 'firebrick', size = 1) +

ggtitle('Población infecciosa de mosquitos') +

theme_bw() + ylab('Número') + xlab('Años')

plot_grid(p1v, p2v, p3v, p4v, ncol = 2)

11.3 Proporción

Por favor dé una mirada más cuidadosa a las proporciones y discútalas

R

p1 <- ggplot(data = out, aes(y = Sh/(Sh+Ih+Rh), x = years)) +

geom_line(color = 'royalblue', size = 1) +

ggtitle('Población humana susceptible') +

theme_bw() + ylab('Proporción') + xlab('Años') +

coord_cartesian(ylim = c(0,1))

p2 <- ggplot(data = out, aes(y = Ih/(Sh+Ih+Rh), x = years)) +

geom_line(color = 'firebrick', size = 1) +

ggtitle('Población humana infecciosa') +

theme_bw() + ylab('Proporción') + xlab('Años') +

coord_cartesian(ylim = c(0,1))

p3 <- ggplot(data = out, aes(y = Rh/(Sh+Ih+Rh), x = years)) +

geom_line(color = 'olivedrab', size = 1) +

ggtitle('Población humana recuperada') +

theme_bw() + ylab('Proporción') + xlab('Años') +

coord_cartesian(ylim = c(0,1))

plot_grid(p1, p2, p3, ncol = 2)

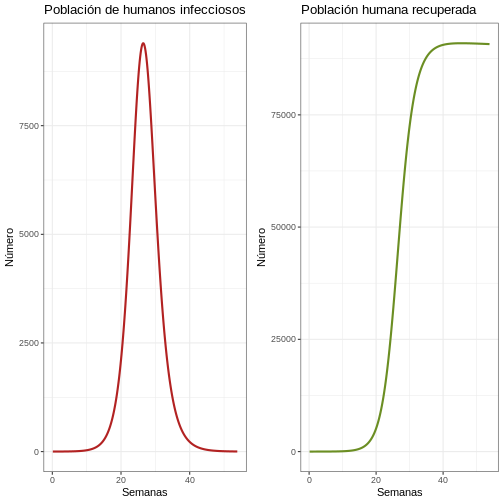

11.4 La primera epidemia

R

# Revise la primera epidemia

dat <- out %>% filter(weeks < 54)

p1e <- ggplot(dat, aes(y = Ih, x = weeks)) +

geom_line(color = 'firebrick', size = 1) +

ggtitle('Población de humanos infecciosos') +

theme_bw() + ylab('Número') + xlab('Semanas')

p2e <- ggplot(dat, aes(y = Rh, x = weeks)) +

geom_line(color = 'olivedrab', size = 1) +

ggtitle('Población humana recuperada') +

theme_bw() + ylab('Número') + xlab('Semanas')

plot_grid(p1e, p2e)

11.5 Algunos aspectos por discutir

- ¿Qué tan sensible es el modelo a cambios en el \(R_0\)?

- ¿Qué razones hay (según el modelo) para el intervalo de tiempo entre estas epidemias simuladas?

- ¿Cómo se puede calcular la tasa de ataque?

11.6 Modele una o más intervenciones de control

Ahora, utilizando este modelo básico, modelar por grupos el impacto de las siguientes intervenciones:

- Grupo 1. Fumigación contra mosquitos

- Grupo 2. Mosquiteros/angeos

- Grupo 3. Vacunación que previene frente a infecciones

Para cada intervención:

Indique en qué parte del modelo haría los cambios.

De acuerdo a la literatura que explique estas intervenciones y describa cómo parametrizará el modelo. ¿Todas estas intervenciones son viables en la actualidad?

Sobre este documento

Contribuciones

- Zulma Cucunuba & Pierre Nouvellet: Versión inicial

- Kelly Charinga & Zhian N. Kamvar: Edición

- José M. Velasco-España: Traducción de Inglés a Español y Edición

- Andree Valle-Campos: Ediciones menores

Contribuciones son bienvenidas vía pull requests. El archivo fuente del documento original puede ser encontrado aquí.

Asuntos legales

Licencia: CC-BY Copyright: Zulma Cucunuba & Pierre Nouvellet, 2017

Puntos clave

Revise si al final de esta lección adquirió estas competencias:

- Aplicar conceptos como parámetros, \(R_0\) e inmunidad de rebaño, aprendidos en la sesión A del taller

- Traducir fórmulas matemáticas de las interacciones entre los parámetros del modelo a código de R

- Realizar un modelo simple en R para una enfermedad transmitida por vector

- Discutir cambios en las proyecciones del modelo cuando se instauran diferentes estrategias de control de la infección

Content from Estimación de las distribuciones de rezagos epidemiológicos: Enfermedad X

Última actualización: 2026-02-09 | Mejora esta página

Hoja de ruta

Preguntas

- ¿Cómo responder ante un brote de una enfermedad desconocida?

Objetivos

Al final de este taller usted podrá:

Comprender los conceptos clave de las distribuciones de rezagos epidemiológicos para la Enfermedad X.

Comprender las estructuras de datos y las herramientas para el análisis de datos de rastreo de contactos.

Aprender a ajustar las estimaciones del intervalo serial y el período de incubación de la Enfermedad X teniendo en cuenta la censura por intervalo utilizando un marco de trabajo Bayesiano.

Aprender a utilizar estos parámetros para informar estrategias de control en un brote de un patógeno desconocido.

1. Introducción

La Enfermedad X representa un hipotético, pero plausible, brote de una enfermedad infecciosa en el futuro. Este término fue acuñado por la Organización Mundial de la Salud (OMS) y sirve como un término general para un patógeno desconocido que podría causar una epidemia grave a nivel internacional. Este concepto representa la naturaleza impredecible de la aparición de enfermedades infecciosas y resalta la necesidad de una preparación global y mecanismos de respuesta rápida. La Enfermedad X simboliza el potencial de una enfermedad inesperada y de rápida propagación, y resalta la necesidad de sistemas de salud flexibles y adaptables, así como capacidades de investigación para identificar, comprender y combatir patógenos desconocidos.

En esta práctica, va a aprender a estimar los rezagos epidemiológicos, el tiempo entre dos eventos epidemiológicos, utilizando un conjunto de datos simulado de la Enfermedad X.

La Enfermedad X es causada por un patógeno desconocido y se transmite directamente de persona a persona. Específicamente, la practica se centrará en estimar el período de incubación y el intervalo serial.

2. Agenda

Parte 1. Individual o en grupo.

Parte 2. En grupos de 6 personas. Construir estrategia de rastreo de contactos y aislamiento y preparar presentación de máximo 10 mins.

3. Conceptos claves

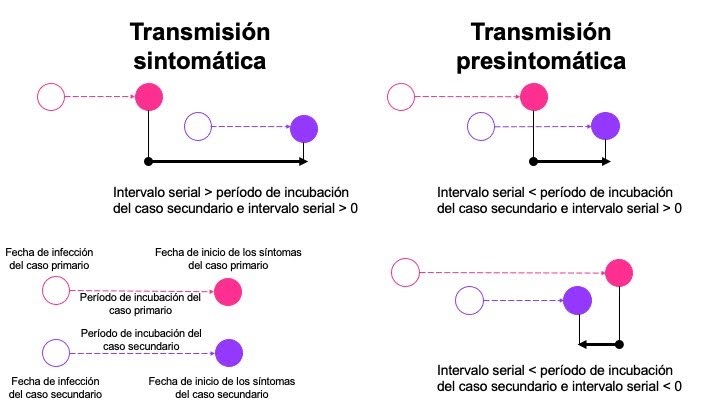

3.1. Rezagos epidemiológicos: Período de incubación e intervalo serial

En epidemiología, las distribuciones de rezagos se refieren a los retrasos temporales entre dos eventos clave durante un brote. Por ejemplo: el tiempo entre el inicio de los síntomas y el diagnóstico, el tiempo entre la aparición de síntomas y la muerte, entre muchos otros.

Este taller se enfocará en dos rezagos clave conocidos como el período de incubación y el intervalo serial. Ambos son cruciales para informar la respuesta de salud pública.

El período de incubación es el tiempo entre la infección y la aparición de síntomas.

El intervalo serial es el tiempo entre la aparición de síntomas entre el caso primario y secundario.

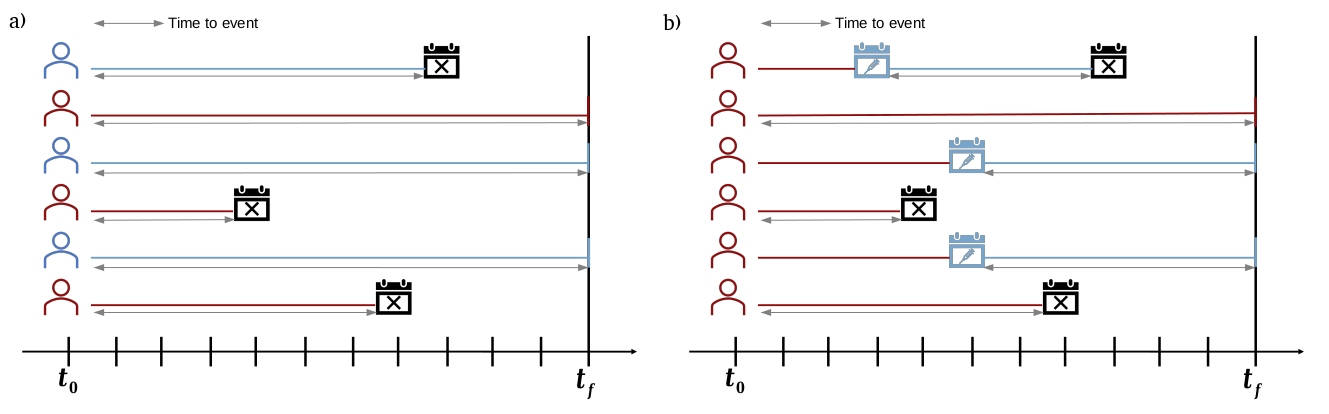

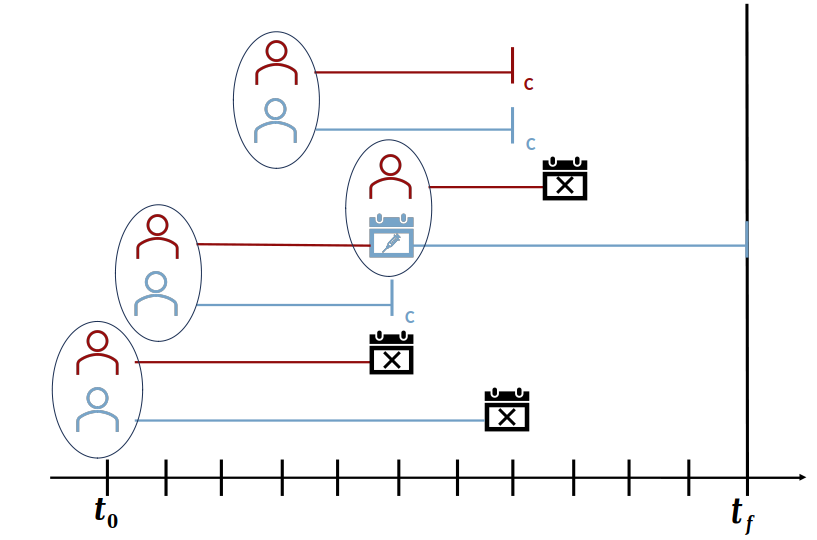

La relación entre estos parámetros tiene un impacto en si la enfermedad se transmite antes (transmisión pre-sintomática) o después de que los síntomas (transmisión sintomática) se hayan desarrollado en el caso primario (Figura 1).

Figura 1. Relación entre el período de incubación y el intervalo serial en el momento de la transmisión (Adaptado de Nishiura et al. 2020)

3.2. Distribuciones comunes de rezagos y posibles sesgos

3.2.1 Sesgos potenciales

Cuando se estiman rezagos epidemiológicos, es importante considerar posibles sesgos:

Censura significa que sabemos que un evento ocurrió, pero no sabemos exactamente cuándo sucedió. La mayoría de los datos epidemiológicos están “doblemente censurados” debido a la incertidumbre que rodea tanto los tiempos de eventos primarios como secundarios. No tener en cuenta la censura puede llevar a estimaciones sesgadas de la desviación estándar del resago (Park et al. en progreso).

Truncamiento a la derecha es un tipo de sesgo de muestreo relacionado con el proceso de recolección de datos. Surge porque solo se pueden observar los casos que han sido reportados. No tener en cuenta el truncamiento a la derecha durante la fase de crecimiento de una epidemia puede llevar a una subestimación del rezago medio (Park et al. en progreso).

El sesgo dinámico (o de fase epidémica) es otro tipo de sesgo de muestreo. Afecta a los datos retrospectivos y está relacionado con la fase de la epidemia: durante la fase de crecimiento exponencial, los casos que desarrollaron síntomas recientemente están sobrerrepresentados en los datos observados, mientras que durante la fase de declive, estos casos están subrepresentados, lo que lleva a la estimación de intervalos de retraso más cortos y más largos, respectivamente (Park et al. en progreso).

3.2.2 Distribuciones de rezagos

Tres distribuciones de probabilidad comunes utilizadas para caracterizar rezagos en epidemiología de enfermedades infecciosas (Tabla 1):

| Distribución | Parámetros |

|---|---|

| Weibull |

shape y scale (forma y

escala) |

| gamma |

shape y scale (forma y

escala) |

| log normal |

log mean y

log standard deviation (media y desviación estándar

logarítmica) |

4. Paquetes de R para la practica

En esta practica se usarán los siguientes paquetes de

R:

dplyrpara manejo de datosepicontactspara visualizar los datos de rastreo de contactosggplot2ypatchworkpara gráficarincidencepara visualizar curvas epidemicasrstanpara estimar el período de incubacióncoarseDataToolsviaEpiEstimpara estimar el intervalo serial

Instrucciones de instalación para los paquetes:

Para cargar los paquetes, escriba:

R

library(dplyr)

library(epicontacts)

library(incidence)

library(coarseDataTools)

library(EpiEstim)

library(ggplot2)

library(loo)

library(patchwork)

library(rstan)

Para este taller, las autoras han creado algunas funciones que serán necesarias para el buen funcionamiento del mismo. Por favor, copie el siguiente texto, selecciónelo y ejecútelo para tener estas funciones en su ambiente global y poderlas utilizar.

R

## Calcule la verosimilitud DIC mediante integración

diclik <- function(par1, par2, EL, ER, SL, SR, dist){

## Si la ventana de síntomas es mayor que la ventana de exposición

if(SR-SL>ER-EL){

dic1 <- integrate(fw1, lower=SL-ER, upper=SL-EL,

subdivisions=10,

par1=par1, par2=par2,

EL=EL, ER=ER, SL=SL, SR=SR,

dist=dist)$value

if (dist == "W"){

dic2 <- (ER-EL)*

(pweibull(SR-ER, shape=par1, scale=par2) - pweibull(SL-EL, shape=par1, scale=par2))

} else if (dist == "off1W"){

dic2 <- (ER-EL)*

(pweibullOff1(SR-ER, shape=par1, scale=par2) - pweibullOff1(SL-EL, shape=par1, scale=par2))

} else if (dist == "G"){

dic2 <- (ER-EL)*

(pgamma(SR-ER, shape=par1, scale=par2) - pgamma(SL-EL, shape=par1, scale=par2))

} else if (dist == "off1G"){

dic2 <- (ER-EL)*

(pgammaOff1(SR-ER, shape=par1, scale=par2) - pgammaOff1(SL-EL, shape=par1, scale=par2))

} else if (dist == "L") {

dic2 <- (ER-EL)*

(plnorm(SR-ER, par1, par2) - plnorm(SL-EL, par1, par2))

} else if (dist == "off1L") {

dic2 <- (ER-EL)*

(plnormOff1(SR-ER, par1, par2) - plnormOff1(SL-EL, par1, par2))

} else {

stop("distribution not supported")

}

dic3 <- integrate(fw3, lower=SR-ER, upper=SR-EL,

subdivisions=10,

par1=par1, par2=par2,

EL=EL, ER=ER, SL=SL, SR=SR,

dist=dist)$value

return(dic1 + dic2 + dic3)

}

## Si la ventana de exposición es mayor que la ventana de síntomas

else{

dic1 <- integrate(fw1, lower=SL-ER, upper=SR-ER, subdivisions=10,

par1=par1, par2=par2,

EL=EL, ER=ER, SL=SL, SR=SR,

dist=dist)$value

if (dist == "W"){

dic2 <- (SR-SL)*

(pweibull(SL-EL, shape=par1, scale=par2) - pweibull(SR-ER, shape=par1, scale=par2))

} else if (dist == "off1W"){

dic2 <- (SR-SL)*

(pweibullOff1(SL-EL, shape=par1, scale=par2) - pweibullOff1(SR-ER, shape=par1, scale=par2))

} else if (dist == "G"){

dic2 <- (SR-SL)*

(pgamma(SL-EL, shape=par1, scale=par2) - pgamma(SR-ER, shape=par1, scale=par2))

} else if (dist == "off1G"){

dic2 <- (SR-SL)*

(pgammaOff1(SL-EL, shape=par1, scale=par2) - pgammaOff1(SR-ER, shape=par1, scale=par2))

} else if (dist == "L"){

dic2 <- (SR-SL)*

(plnorm(SL-EL, par1, par2) - plnorm(SR-ER, par1, par2))

} else if (dist == "off1L"){

dic2 <- (SR-SL)*

(plnormOff1(SL-EL, par1, par2) - plnormOff1(SR-ER, par1, par2))

} else {

stop("distribution not supported")

}

dic3 <- integrate(fw3, lower=SL-EL, upper=SR-EL,

subdivisions=10,

par1=par1, par2=par2,

EL=EL, ER=ER, SL=SL, SR=SR,

dist=dist)$value

return(dic1 + dic2 + dic3)

}

}

## Esta verosimilitud DIC está diseñada para datos que tienen intervalos superpuestos

diclik2 <- function(par1, par2, EL, ER, SL, SR, dist){

if(SL>ER) {

return(diclik(par1, par2, EL, ER, SL, SR, dist))

} else {

lik1 <- integrate(diclik2.helper1, lower=EL, upper=SL,

SL=SL, SR=SR, par1=par1, par2=par2, dist=dist)$value

lik2 <- integrate(diclik2.helper2, lower=SL, upper=ER,

SR=SR, par1=par1, par2=par2, dist=dist)$value

return(lik1+lik2)

}

}

## Funciones de verosimilitud para diclik2

diclik2.helper1 <- function(x, SL, SR, par1, par2, dist){

if (dist =="W"){

pweibull(SR-x, shape=par1, scale=par2) - pweibull(SL-x, shape=par1, scale=par2)

} else if (dist =="off1W") {

pweibullOff1(SR-x, shape=par1, scale=par2) - pweibullOff1(SL-x, shape=par1, scale=par2)

} else if (dist =="G") {

pgamma(SR-x, shape=par1, scale=par2) - pgamma(SL-x, shape=par1, scale=par2)

} else if (dist=="off1G"){

pgammaOff1(SR-x, shape=par1, scale=par2) - pgammaOff1(SL-x, shape=par1, scale=par2)

} else if (dist == "L"){

plnorm(SR-x, par1, par2) - plnorm(SL-x, par1, par2)

} else if (dist == "off1L"){

plnormOff1(SR-x, par1, par2) - plnormOff1(SL-x, par1, par2)

} else {

stop("distribution not supported")

}

}

diclik2.helper2 <- function(x, SR, par1, par2, dist){

if (dist =="W"){

pweibull(SR-x, shape=par1, scale=par2)

} else if (dist =="off1W") {

pweibullOff1(SR-x, shape=par1, scale=par2)

} else if (dist =="G") {

pgamma(SR-x, shape=par1, scale=par2)

} else if (dist =="off1G") {

pgammaOff1(SR-x, shape=par1, scale=par2)

} else if (dist=="L"){

plnorm(SR-x, par1, par2)

} else if (dist=="off1L"){

plnormOff1(SR-x, par1, par2)

} else {

stop("distribution not supported")

}

}

## Funciones que manipulan/calculan la verosimilitud para los datos censurados

## Las funciones codificadas aquí se toman directamente de las

## notas de verosimilitud censurada por intervalos dobles.

fw1 <- function(t, EL, ER, SL, SR, par1, par2, dist){

## Función que calcula la primera función para la integral DIC

if (dist=="W"){

(ER-SL+t) * dweibull(x=t,shape=par1,scale=par2)

} else if (dist=="off1W") {

(ER-SL+t) * dweibullOff1(x=t,shape=par1,scale=par2)

} else if (dist=="G") {

(ER-SL+t) * dgamma(x=t, shape=par1, scale=par2)

} else if (dist=="off1G") {

(ER-SL+t) * dgammaOff1(x=t, shape=par1, scale=par2)

} else if (dist =="L"){

(ER-SL+t) * dlnorm(x=t, meanlog=par1, sdlog=par2)

} else if (dist =="off1L"){

(ER-SL+t) * dlnormOff1(x=t, meanlog=par1, sdlog=par2)

} else {

stop("distribution not supported")

}

}

fw3 <- function(t, EL, ER, SL, SR, par1, par2, dist){

## Función que calcula la tercera función para la integral DIC

if (dist == "W"){

(SR-EL-t) * dweibull(x=t, shape=par1, scale=par2)

} else if (dist == "off1W"){

(SR-EL-t) * dweibullOff1(x=t, shape=par1, scale=par2)

} else if (dist == "G"){

(SR-EL-t) * dgamma(x=t, shape=par1, scale=par2)

} else if (dist == "off1G"){

(SR-EL-t) * dgammaOff1(x=t, shape=par1, scale=par2)

} else if (dist == "L") {

(SR-EL-t) * dlnorm(x=t, meanlog=par1, sdlog=par2)

} else if (dist == "off1L"){

(SR-EL-t) * dlnormOff1(x=t, meanlog=par1, sdlog=par2)

} else {

stop("distribution not supported")

}

}

5. Datos

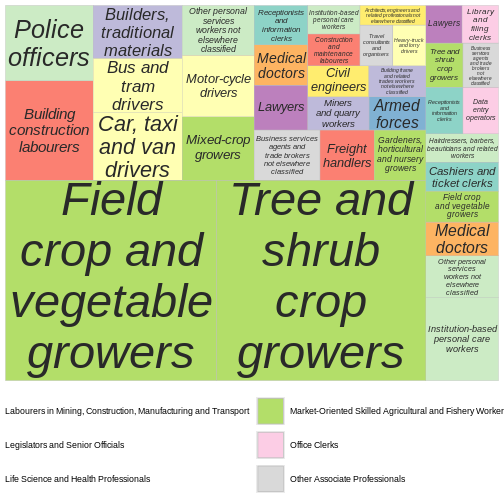

Esta práctica está partida en dos grupos para abordar dos enfermedades desconocidas con diferentes modos de transmisión.

Cargue los datos simulados que están guardados como un archivo .RDS, de acuerdo a su grupo asignado. Puede encontrar esta información en la carpeta Enfermedad X. Descargue la carpeta, extráigala en el computador y abra el proyecto de R.

Hay dos elementos de interés:

linelist, un archivo que contiene una lista de casos de la Enfermedad X, un caso por fila.contacts, un archivo con datos de rastreo de contactos que contiene información sobre pares de casos primarios y secundarios.

R

# Grupo 1

dat <- readRDS("data/practical_data_group1.RDS")

linelist <- dat$linelist

contacts <- dat$contacts

6. Exploración de los datos

6.1. Exploración de los datos en

linelist

Empiece con linelist. Estos datos fueron recolectados

como parte de la vigilancia epidemiológica rutinaria. Cada fila

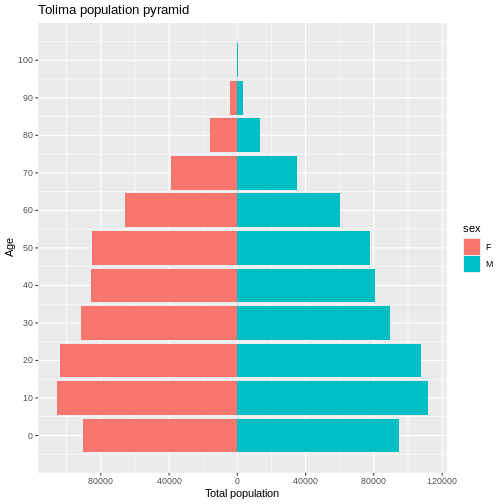

representa un caso de la Enfermedad X, y hay 7 variables:

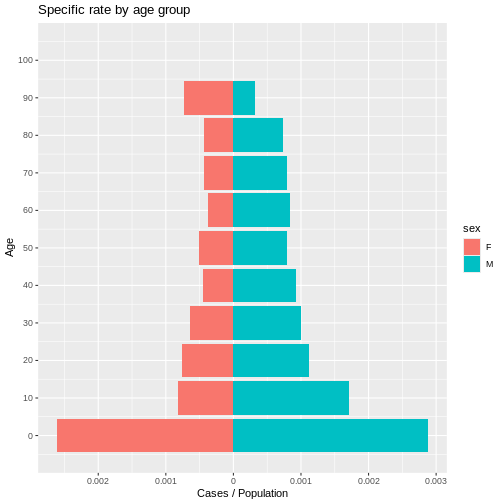

id: número único de identificación del casodate_onset: fecha de inicio de los síntomas del pacientesex: : M = masculino; F = femeninoage: edad del paciente en añosexposure: información sobre cómo el paciente podría haber estado expuestoexposure_start: primera fecha en que el paciente estuvo expuestoexposure_end: última fecha en que el paciente estuvo expuesto

💡 Preguntas (1)

¿Cuántos casos hay en los datos de

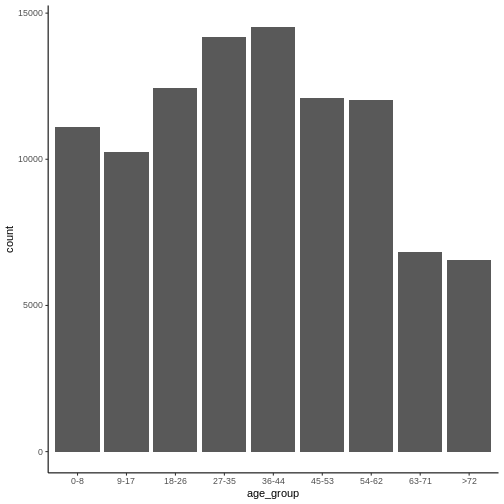

linelist?¿Qué proporción de los casos son femeninos?

¿Cuál es la distribución de edades de los casos?

¿Qué tipo de información sobre la exposición está disponible?

R

# Inspecionar los datos

head(linelist)

SALIDA

id date_onset sex age exposure exposure_start exposure_end

1 1 2023-10-01 M 34 Close, skin-to-skin contact <NA> <NA>

2 2 2023-10-03 F 38 Close, skin-to-skin contact 2023-09-29 2023-09-29

3 3 2023-10-06 F 38 Close, skin-to-skin contact 2023-09-28 2023-09-28

4 4 2023-10-10 F 37 <NA> 2023-09-25 2023-09-27

5 5 2023-10-11 F 33 <NA> 2023-10-05 2023-10-05

6 6 2023-10-12 F 34 Close, skin-to-skin contact 2023-10-10 2023-10-10R

# P1

nrow(linelist)

SALIDA

[1] 166R

# P2

table(linelist$sex)[2]/nrow(linelist)

SALIDA

M

0.6144578 R

# P3

summary(linelist$age)

SALIDA

Min. 1st Qu. Median Mean 3rd Qu. Max.

22.00 33.00 36.00 35.51 38.00 47.00 R

# P4

table(linelist$exposure, exclude = F)[1]/nrow(linelist)

SALIDA

Close, skin-to-skin contact

0.6626506 💡 Discusión

¿Por qué cree que falta la información de exposición en algunos casos?

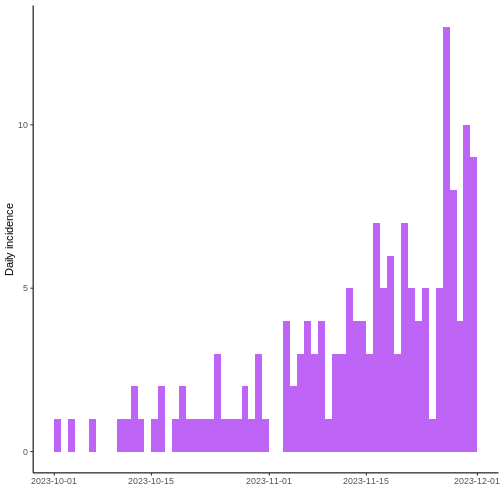

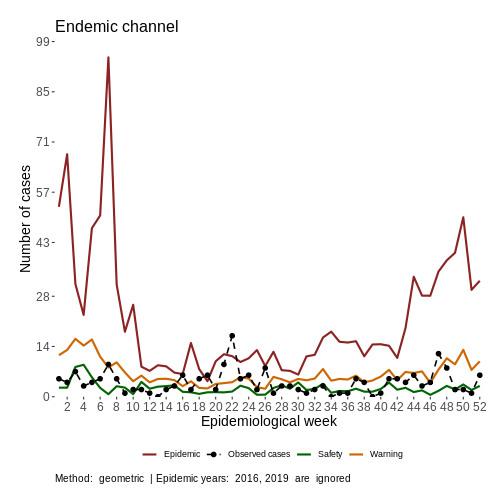

Ahora, grafique la curva epidémica. ¿En qué parte del brote cree que está (principio, medio, final)?

R

i <- incidence(linelist$date_onset)

plot(i) +

theme_classic() +

scale_fill_manual(values = "purple") +

theme(legend.position = "none")

Parece que la epidemia todavía podría esta creciendo.

6.2. Exploración de los datos de

rastreo de contactos

Ahora vea los datos de rastreo de contactos, que se obtuvieron a través de entrevistas a los pacientes. A los pacientes se les preguntó sobre actividades e interacciones recientes para identificar posibles fuentes de infección. Se emparejaron pares de casos primarios y secundarios si el caso secundario nombraba al caso primario como un contacto. Solo hay información de un subconjunto de los casos porque no todos los pacientes pudieron ser contactados para una entrevista.

Note que para este ejercicio, se asumirá que los casos secundarios solo tenían un posible infectante. En realidad, la posibilidad de que un caso tenga múltiples posibles infectantes necesita ser evaluada.

Los datos de rastreo de contactos tienen 4 variables:

primary_case_id: número de identificación único para el caso primario (infectante)secondary_case_id: número de identificación único para el caso secundario (infectado)primary_onset_date: fecha de inicio de síntomas del caso primariosecondary_onset_date: fecha de inicio de síntomas del caso secundario

R

x <- make_epicontacts(linelist = linelist,

contacts = contacts,

from = "primary_case_id",

to = "secondary_case_id",

directed = TRUE) # Esto indica que los contactos son directos (i.e., este gráfico traza una flecha desde los casos primarios a los secundarios)

plot(x)

💡 Preguntas (2)

- Describa los grupos (clusters).

- ¿Ve algún evento potencial de superpropagación (donde un caso propaga el patógeno a muchos otros casos)?

_______Pausa 1 _________

7. Estimación del período de incubación

Ahora, enfoquese en el período de incubación. Se utilizará los datos

del linelist para esta parte. Se necesitan ambos el tiempo

de inicio de sintomas y el timpo de la posible exposición. Note que en

los datos hay dos fechas de exposición, una de inicio y una de final.

Algunas veces la fecha exacta de exposición es desconocida y en su lugar

se obtiene la ventana de exposición durante la entrevista.

💡 Preguntas (3)

¿Para cuántos casos tiene datos tanto de la fecha de inicio de síntomas como de exposición?

Calcule las ventanas de exposición. ¿Cuántos casos tienen una única fecha de exposición?

R

ip <- filter(linelist, !is.na(exposure_start) &

!is.na(exposure_end))

nrow(ip)

SALIDA

[1] 50R

ip$exposure_window <- as.numeric(ip$exposure_end - ip$exposure_start)

table(ip$exposure_window)

SALIDA

0 1 2

34 11 5 7.1. Estimación naive del período de incubación

Empiece calculando una estimación naive del período de incubación.

R

# Máximo tiempo de período de incubación

ip$max_ip <- ip$date_onset - ip$exposure_start

summary(as.numeric(ip$max_ip))

SALIDA

Min. 1st Qu. Median Mean 3rd Qu. Max.

1.00 3.00 4.50 6.38 7.75 20.00 R

# Mínimo tiempo de período de incubación

ip$min_ip <- ip$date_onset - ip$exposure_end

summary(as.numeric(ip$min_ip))

SALIDA

Min. 1st Qu. Median Mean 3rd Qu. Max.

1.00 2.00 4.00 5.96 7.75 19.00 7.2. Censura estimada ajustada del período de incubación

Ahora, ajuste tres distribuciones de probabilidad a los datos del

período de incubación teniendo en cuenta la censura doble. Adapte un

código de stan que fue publicado por Miura et al. durante

el brote global de mpox de 2022. Este método no tiene en cuenta el

truncamiento a la derecha ni el sesgo dinámico.

Recuerde que el interés principal es considerar tres distribuciones de probabilidad: Weibull, gamma y log normal (Ver Tabla 1).

Stan es un programa de software que implementa el

algoritmo Monte Carlo Hamiltoniano (HMC por su siglas en inglés de

Hamiltonian Monte Carlo). HMC es un método de Monte Carlo de cadena de

Markov (MCMC) para ajustar modelos complejos a datos utilizando

estadísticas bayesianas.

7.1.1. Corra el modelo en Stan

Ajuste las tres distribuciones en este bloque de código.

R

# Prepare los datos

earliest_exposure <- as.Date(min(ip$exposure_start))

ip <- ip |>

mutate(date_onset = as.numeric(date_onset - earliest_exposure),

exposure_start = as.numeric(exposure_start - earliest_exposure),

exposure_end = as.numeric(exposure_end - earliest_exposure)) |>

select(id, date_onset, exposure_start, exposure_end)

# Configure algunas opciones para ejecutar las cadenas MCMC en paralelo

# Ejecución de las cadenas MCMC en paralelo significa que se ejecutaran varias cadenas al mismo tiempo usando varios núcleos de su computador

options(mc.cores=parallel::detectCores())

input_data <- list(N = length(ip$exposure_start), # NNúmero de observaciones

tStartExposure = ip$exposure_start,

tEndExposure = ip$exposure_end,

tSymptomOnset = ip$date_onset)

# tres distribuciones de probabilidad

distributions <- c("weibull", "gamma", "lognormal")

# Código de Stan

code <- sprintf("

data{

int<lower=1> N;

vector[N] tStartExposure;

vector[N] tEndExposure;

vector[N] tSymptomOnset;

}

parameters{

real<lower=0> par[2];

vector<lower=0, upper=1>[N] uE; // Uniform value for sampling between start and end exposure

}

transformed parameters{

vector[N] tE; // infection moment

tE = tStartExposure + uE .* (tEndExposure - tStartExposure);

}

model{

// Contribution to likelihood of incubation period

target += %s_lpdf(tSymptomOnset - tE | par[1], par[2]);

}

generated quantities {

// likelihood for calculation of looIC

vector[N] log_lik;

for (i in 1:N) {

log_lik[i] = %s_lpdf(tSymptomOnset[i] - tE[i] | par[1], par[2]);

}

}

", distributions, distributions)

names(code) <- distributions

# La siguiente línea puede tomar ~1.5 min

models <- mapply(stan_model, model_code = code)

# Toma ~40 sec.

fit <- mapply(sampling, models, list(input_data),

iter=3000, # Número de iteraciones (largo de la cadena MCMC)

warmup=1000, # Número de muestras a descartar al inicio de MCMC

chain=4) # Número de cadenas MCMC a ejecutar

R

pos <- mapply(function(z) rstan::extract(z)$par, fit, SIMPLIFY=FALSE) # muestreo posterior

7.1.2. Revisar si hay convergencia

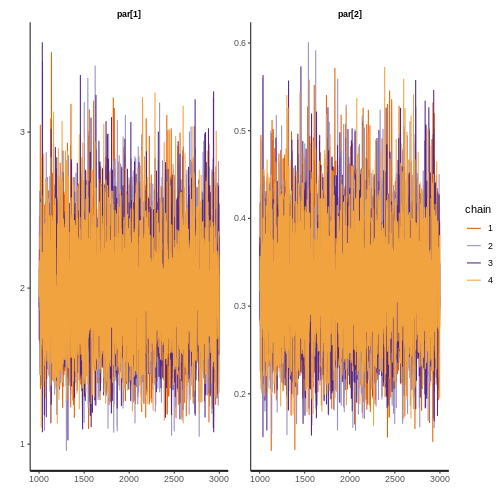

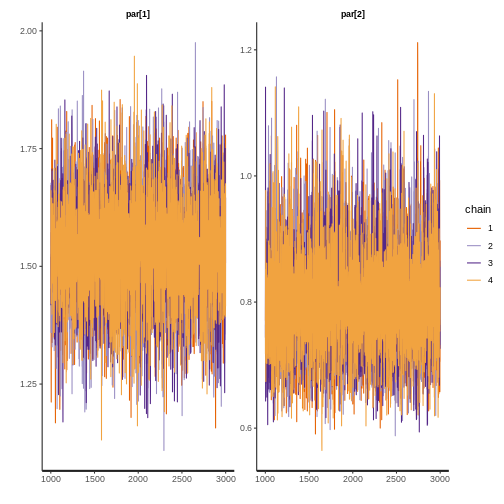

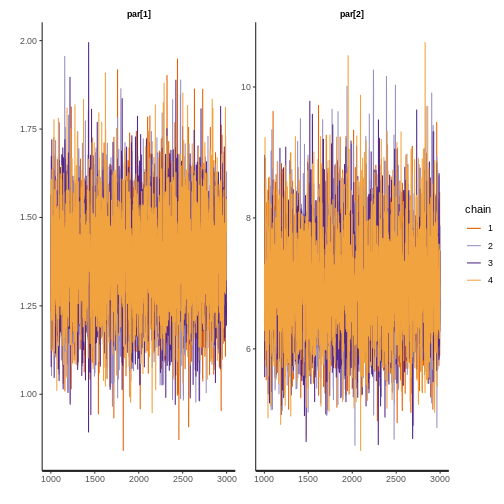

Ahora verifique la convergencia del modelo. Observe los valores de r-hat, los tamaños de muestra efectivos y las trazas MCMC. R-hat compara las estimaciones entre y dentro de cadenas para los parámetros del modelo; valores cercanos a 1 indican que las cadenas se han mezclado bien (Vehtari et al. 2021). El tamaño de muestra efectivo estima el número de muestras independientes después de tener en cuenta la dependencia en las cadenas MCMC (Lambert 2018). Para un modelo con 4 cadenas MCMC, se recomienda un tamaño total de muestra efectiva de al menos 400 (Vehtari et al. 2021).

Para cada modelo con distribución ajustada:

💡 Preguntas (4)

¿Los valores de r-hat son cercanos a 1?

¿Las 4 cadenas MCMC generalmente se superponen y permanecen alrededor de los mismos valores (se ven como orugas peludas)?

7.1.2.1. Convergencia para Gamma

R

print(fit$gamma, digits = 3, pars = c("par[1]","par[2]"))

SALIDA

Inference for Stan model: anon_model.

4 chains, each with iter=3000; warmup=1000; thin=1;

post-warmup draws per chain=2000, total post-warmup draws=8000.

mean se_mean sd 2.5% 25% 50% 75% 97.5% n_eff Rhat

par[1] 1.976 0.003 0.352 1.345 1.726 1.958 2.205 2.722 11841 1

par[2] 0.324 0.001 0.065 0.210 0.278 0.319 0.364 0.466 10930 1

Samples were drawn using NUTS(diag_e) at Mon Feb 9 10:50:08 2026.

For each parameter, n_eff is a crude measure of effective sample size,

and Rhat is the potential scale reduction factor on split chains (at

convergence, Rhat=1).R

rstan::traceplot(fit$gamma, pars = c("par[1]","par[2]"))

7.1.2.2. Convergencia para log normal

R

print(fit$lognormal, digits = 3, pars = c("par[1]","par[2]"))

SALIDA

Inference for Stan model: anon_model.

4 chains, each with iter=3000; warmup=1000; thin=1;

post-warmup draws per chain=2000, total post-warmup draws=8000.

mean se_mean sd 2.5% 25% 50% 75% 97.5% n_eff Rhat

par[1] 1.529 0.001 0.115 1.302 1.455 1.529 1.604 1.755 10940 1

par[2] 0.800 0.001 0.082 0.660 0.743 0.793 0.850 0.984 10310 1

Samples were drawn using NUTS(diag_e) at Mon Feb 9 10:50:15 2026.

For each parameter, n_eff is a crude measure of effective sample size,

and Rhat is the potential scale reduction factor on split chains (at

convergence, Rhat=1).R

rstan::traceplot(fit$lognormal, pars = c("par[1]","par[2]"))

7.1.2.3. Convergencia para Weibull

R

print(fit$weibull, digits = 3, pars = c("par[1]","par[2]"))

SALIDA

Inference for Stan model: anon_model.

4 chains, each with iter=3000; warmup=1000; thin=1;

post-warmup draws per chain=2000, total post-warmup draws=8000.

mean se_mean sd 2.5% 25% 50% 75% 97.5% n_eff Rhat

par[1] 1.373 0.001 0.145 1.099 1.274 1.368 1.470 1.668 10607 1

par[2] 6.952 0.008 0.768 5.551 6.419 6.921 7.442 8.545 10094 1

Samples were drawn using NUTS(diag_e) at Mon Feb 9 10:50:00 2026.

For each parameter, n_eff is a crude measure of effective sample size,

and Rhat is the potential scale reduction factor on split chains (at

convergence, Rhat=1).R

rstan::traceplot(fit$weibull, pars = c("par[1]","par[2]"))

7.1.3. Calcule los criterios de comparación de los modelos

Calcule el criterio de información ampliamente aplicable (WAIC) y el criterio de información de dejar-uno-fuera (LOOIC) para comparar los ajustes de los modelos. El modelo con mejor ajuste es aquel con el WAIC o LOOIC más bajo. En esta sección también se resumirá las distribuciones y se hará algunos gráficos.

💡 Preguntas (5)

- ¿Qué modelo tiene mejor ajuste?

R

# Calcule WAIC para los tres modelos

waic <- mapply(function(z) waic(extract_log_lik(z))$estimates[3,], fit)

waic

SALIDA

weibull gamma lognormal

Estimate 278.05599 275.87614 272.79644

SE 11.96422 13.38055 13.85682R

# Para looic, se necesita proveer los tamaños de muestra relativos

# al llamar a loo. Este paso lleva a mejores estimados de los tamaños de

# muestra PSIS efectivos y del error de Monte Carlo

# Extraer la verosimilitud puntual logarítmica para la distribución Weibull

loglik <- extract_log_lik(fit$weibull, merge_chains = FALSE)

# Obtener los tamaños de muestra relativos efectivos

r_eff <- relative_eff(exp(loglik), cores = 2)

# Calcula LOOIC

loo_w <- loo(loglik, r_eff = r_eff, cores = 2)$estimates[3,]

# Imprimir los resultados

loo_w[1]

SALIDA

Estimate

278.0684 R

# Extraer la verosimilitud puntual logarítmica para la distribución gamma

loglik <- extract_log_lik(fit$gamma, merge_chains = FALSE)

r_eff <- relative_eff(exp(loglik), cores = 2)

loo_g <- loo(loglik, r_eff = r_eff, cores = 2)$estimates[3,]

loo_g[1]

SALIDA

Estimate

275.8943 R

# Extraer la verosimilitud puntual logarítmica para la distribución log normal

loglik <- extract_log_lik(fit$lognormal, merge_chains = FALSE)

r_eff <- relative_eff(exp(loglik), cores = 2)

loo_l <- loo(loglik, r_eff = r_eff, cores = 2)$estimates[3,]

loo_l[1]

SALIDA

Estimate

272.8118 7.1.4. Reporte los resultados

La cola derecha de la distribución del período de incubación es importante para diseñar estrategias de control (por ejemplo, cuarentena), los percentiles del 25 al 75 informan sobre el momento más probable en que podría ocurrir la aparición de síntomas, y la distribución completa puede usarse como una entrada en modelos matemáticos o estadísticos, como para pronósticos (Lessler et al. 2009).

Obtenga las estadísticas resumidas.

R

# Necesitamos convertir los parámetros de las distribuciones a la media y desviación estándar del rezago

# En Stan, los parámetros de las distribuciones son:

# Weibull: forma y escala

# Gamma: forma e inversa de la escala (aka rate)

# Log Normal: mu y sigma

# Referencia: https://mc-stan.org/docs/2_21/functions-reference/positive-continuous-distributions.html

# Calcule las medias

means <- cbind(

pos$weibull[, 2] * gamma(1 + 1 / pos$weibull[, 1]), # media de Weibull

pos$gamma[, 1] / pos$gamma[, 2], # media de gamma

exp(pos$lognormal[, 1] + pos$lognormal[, 2]^2 / 2) # media de log normal

)

# Calcule las desviaciones estándar

standard_deviations <- cbind(

sqrt(pos$weibull[, 2]^2 * (gamma(1 + 2 / pos$weibull[, 1]) - (gamma(1 + 1 / pos$weibull[, 1]))^2)),

sqrt(pos$gamma[, 1] / (pos$gamma[, 2]^2)),

sqrt((exp(pos$lognormal[, 2]^2) - 1) * (exp(2 * pos$lognormal[, 1] + pos$lognormal[, 2]^2)))

)

# Imprimir los rezagos medios e intervalos creíbles del 95%

probs <- c(0.025, 0.5, 0.975)

res_means <- apply(means, 2, quantile, probs)

colnames(res_means) <- colnames(waic)

res_means

SALIDA

weibull gamma lognormal

2.5% 5.164347 5.078392 5.007976

50% 6.337619 6.112832 6.334840

97.5% 7.850407 7.496816 8.444604R

res_sds <- apply(standard_deviations, 2, quantile, probs)

colnames(res_sds) <- colnames(waic)

res_sds

SALIDA

weibull gamma lognormal

2.5% 3.691537 3.457163 4.008989

50% 4.653073 4.369482 5.907518

97.5% 6.321367 5.781967 10.047042R

# Informe la mediana e intervalos creíbles del 95% para los cuantiles de cada distribución

quantiles_to_report <- c(0.025, 0.05, 0.5, 0.95, 0.975, 0.99)

# Weibull

cens_w_percentiles <- sapply(quantiles_to_report, function(p) quantile(qweibull(p = p, shape = pos$weibull[,1], scale = pos$weibull[,2]), probs = probs))

colnames(cens_w_percentiles) <- quantiles_to_report

print(cens_w_percentiles)

SALIDA

0.025 0.05 0.5 0.95 0.975 0.99

2.5% 0.2185794 0.4150134 4.099327 12.55829 14.42785 16.72733

50% 0.4706396 0.7889995 5.294549 15.36799 17.88761 21.02426

97.5% 0.8397393 1.2861955 6.608721 20.01634 23.85980 28.77434R

# Gamma

cens_g_percentiles <- sapply(quantiles_to_report, function(p) quantile(qgamma(p = p, shape = pos$gamma[,1], rate = pos$gamma[,2]), probs = probs))

colnames(cens_g_percentiles) <- quantiles_to_report

print(cens_g_percentiles)

SALIDA

0.025 0.05 0.5 0.95 0.975 0.99

2.5% 0.3348797 0.5685104 4.112440 11.95506 13.93216 16.44182

50% 0.7211879 1.0629929 5.109289 14.60152 17.17792 20.50946

97.5% 1.1692585 1.5868347 6.245905 18.63239 22.23866 26.83433R

# Log normal

cens_ln_percentiles <- sapply(quantiles_to_report, function(p) quantile(qlnorm(p = p, meanlog = pos$lognormal[,1], sdlog= pos$lognormal[,2]), probs = probs))

colnames(cens_ln_percentiles) <- quantiles_to_report

print(cens_ln_percentiles)

SALIDA

0.025 0.05 0.5 0.95 0.975 0.99

2.5% 0.6267077 0.8429198 3.676783 12.61397 15.69763 20.19985

50% 0.9764945 1.2533841 4.614666 16.99725 21.81898 29.15079

97.5% 1.3681210 1.7016561 5.780718 25.05917 33.67253 47.96688Para cada modelo, encuentre estos elementos para el período de incubación estimado en la salida de arriba y escribalos abajo.

Media e intervalo de credibilidad del 95%

Desviación estándar e intervalo de credibilidad del 95%

Percentiles (e.g., 2.5, 5, 25, 50, 75, 95, 97.5, 99)

Los parámetros de las distribuciones ajustadas (e.g., shape y scale para distribución gamma)

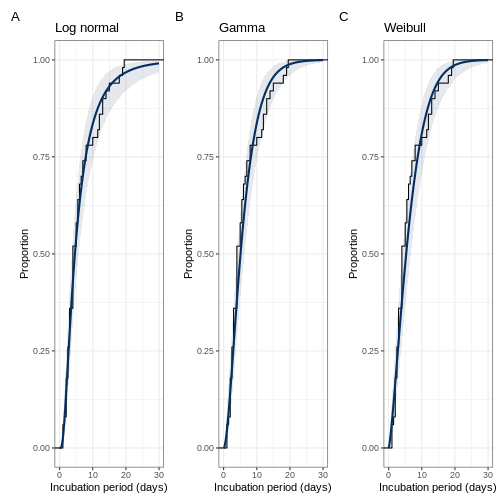

7.1.5. Grafique los resultados

R

# Prepare los resultados para graficarlos

df <- data.frame(

#Tome los valores de las medias para trazar la función de densidad acumulatica empirica

inc_day = ((input_data$tSymptomOnset-input_data$tEndExposure)+(input_data$tSymptomOnset-input_data$tStartExposure))/2

)

x_plot <- seq(0, 30, by=0.1) # Esto configura el rango del eje x (número de días)

Gam_plot <- as.data.frame(list(dose= x_plot,

pred= sapply(x_plot, function(q) quantile(pgamma(q = q, shape = pos$gamma[,1], rate = pos$gamma[,2]), probs = c(0.5))),

low = sapply(x_plot, function(q) quantile(pgamma(q = q, shape = pos$gamma[,1], rate = pos$gamma[,2]), probs = c(0.025))),

upp = sapply(x_plot, function(q) quantile(pgamma(q = q, shape = pos$gamma[,1], rate = pos$gamma[,2]), probs = c(0.975)))

))

Wei_plot <- as.data.frame(list(dose= x_plot,

pred= sapply(x_plot, function(q) quantile(pweibull(q = q, shape = pos$weibull[,1], scale = pos$weibull[,2]), probs = c(0.5))),

low = sapply(x_plot, function(q) quantile(pweibull(q = q, shape = pos$weibull[,1], scale = pos$weibull[,2]), probs = c(0.025))),

upp = sapply(x_plot, function(q) quantile(pweibull(q = q, shape = pos$weibull[,1], scale = pos$weibull[,2]), probs = c(0.975)))

))

ln_plot <- as.data.frame(list(dose= x_plot,

pred= sapply(x_plot, function(q) quantile(plnorm(q = q, meanlog = pos$lognormal[,1], sdlog= pos$lognormal[,2]), probs = c(0.5))),

low = sapply(x_plot, function(q) quantile(plnorm(q = q, meanlog = pos$lognormal[,1], sdlog= pos$lognormal[,2]), probs = c(0.025))),

upp = sapply(x_plot, function(q) quantile(plnorm(q = q, meanlog = pos$lognormal[,1], sdlog= pos$lognormal[,2]), probs = c(0.975)))

))

# Grafique las curvas de la distribución acumulada

gamma_ggplot <- ggplot(df, aes(x=inc_day)) +

stat_ecdf(geom = "step")+

xlim(c(0, 30))+

geom_line(data=Gam_plot, aes(x=x_plot, y=pred), color=RColorBrewer::brewer.pal(11, "RdBu")[11], linewidth=1) +

geom_ribbon(data=Gam_plot, aes(x=x_plot,ymin=low,ymax=upp), fill = RColorBrewer::brewer.pal(11, "RdBu")[11], alpha=0.1) +

theme_bw(base_size = 11)+

labs(x="Incubation period (days)", y = "Proportion")+

ggtitle("Gamma")

weibul_ggplot <- ggplot(df, aes(x=inc_day)) +

stat_ecdf(geom = "step")+

xlim(c(0, 30))+

geom_line(data=Wei_plot, aes(x=x_plot, y=pred), color=RColorBrewer::brewer.pal(11, "RdBu")[11], linewidth=1) +

geom_ribbon(data=Wei_plot, aes(x=x_plot,ymin=low,ymax=upp), fill = RColorBrewer::brewer.pal(11, "RdBu")[11], alpha=0.1) +

theme_bw(base_size = 11)+

labs(x="Incubation period (days)", y = "Proportion")+

ggtitle("Weibull")

lognorm_ggplot <- ggplot(df, aes(x=inc_day)) +

stat_ecdf(geom = "step")+

xlim(c(0, 30))+

geom_line(data=ln_plot, aes(x=x_plot, y=pred), color=RColorBrewer::brewer.pal(11, "RdBu")[11], linewidth=1) +

geom_ribbon(data=ln_plot, aes(x=x_plot,ymin=low,ymax=upp), fill = RColorBrewer::brewer.pal(11, "RdBu")[11], alpha=0.1) +

theme_bw(base_size = 11)+

labs(x="Incubation period (days)", y = "Proportion")+

ggtitle("Log normal")

(lognorm_ggplot|gamma_ggplot|weibul_ggplot) + plot_annotation(tag_levels = 'A')

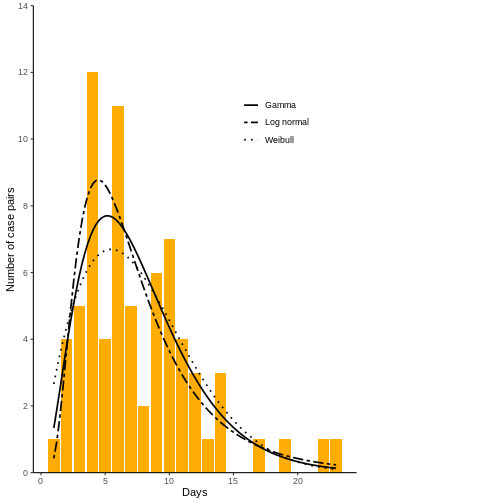

En los gráficos anteriores, la línea negra es la distribución acumulativa empírica (los datos), mientras que la curva azul es la distribución de probabilidad ajustada con los intervalos de credibilidad del 95%. Asegúrese de que la curva azul esté sobre la línea negra.

💡 Preguntas (6)

- ¿Son los ajustes de las distribuciones lo que espera?

_______Pausa 2 _________

8. Estimación del intervalo serial

Ahora, estime el intervalo serial. Nuevamente, se realizará primero una estimación navie calculando la diferencia entre la fecha de inicio de síntomas entre el par de casos primario y secundario.

¿Existen casos con intervalos seriales negativos en los datos (por ejemplo, el inicio de los síntomas en el caso secundario ocurrió antes del inicio de los síntomas en el caso primario)?

Informe la mediana del intervalo serial, así como el mínimo y el máximo.

Grafique la distribución del intervalo serial.

8.1. Estimación naive

R

contacts$diff <- as.numeric(contacts$secondary_onset_date - contacts$primary_onset_date)

summary(contacts$diff)

SALIDA

Min. 1st Qu. Median Mean 3rd Qu. Max.

1.000 4.000 6.000 7.625 10.000 23.000 R

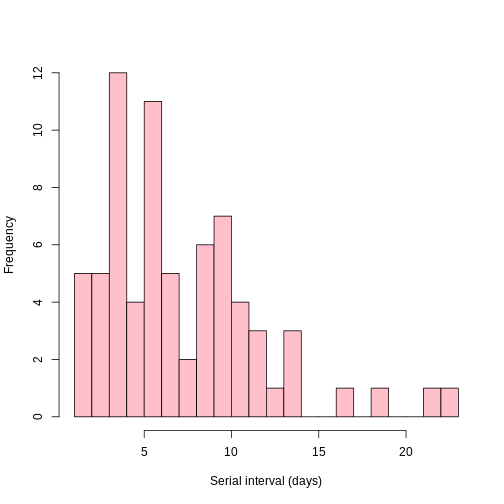

hist(contacts$diff, xlab = "Serial interval (days)", breaks = 25, main = "", col = "pink")

8.2. Estimación ajustada por censura

Ahora se estimará el intervalo serial utilizando una implementación

del paquete courseDataTools dentro del paquete R

EpiEstim. Este método tiene en cuenta la censura doble y

permite comparar diferentes distribuciones de probabilidad, pero no se

ajusta por truncamiento a la derecha o sesgo dinámico.

Se considerará tres distribuciones de probabilidad y deberá seleccionar la que mejor se ajuste a los datos utilizando WAIC o LOOIC. Recuerde que la distribución con mejor ajuste tendrá el WAIC o LOOIC más bajo.

Ten en cuenta que en coarseDataTools, los parámetros

para las distribuciones son ligeramente diferentes que en rstan. Aquí,

los parámetros para la distribución gamma son shape y scale (forma y

escala) (https://cran.r-project.org/web/packages/coarseDataTools/coarseDataTools.pdf).

Solo se ejecutará una cadena MCMC para cada distribución en interés del tiempo, pero en la práctica debería ejecutar más de una cadena para asegurarse de que el MCMC converge en la distribución objetivo. Usará las distribuciones a priori predeterminadas, que se pueden encontrar en la documentación del paquete (ver ‘detalles’ para la función dic.fit.mcmc aquí: (https://cran.r-project.org/web/packages/coarseDataTools/coarseDataTools.pdf).

8.2.1. Preparación de los datos

R

# Formatee los datos de intervalos censurados del intervalo serial

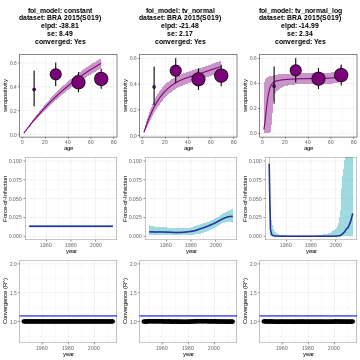

# Cada línea representa un evento de transmisión