Content from Acceder a las distribuciones de retrasos epidemiológicos

Última actualización: 2024-11-19 | Mejora esta página

Hoja de ruta

Preguntas

- ¿Cómo acceder a las distribuciones de retraso de la enfermedad desde una base de datos preestablecida para su uso en el análisis?

Objetivos

- Obtener retrasos de una base de datos de búsqueda bibliográfica con

{epiparameter}. - Obtén parámetros de distribución y estadísticas resumidas de distribuciones de retrasos.

Requisitos previos

Este episodio requiere que estés familiarizado con

Ciencia de datos Programación básica con R

Teoría epidémica : Pparámetros epidemiológicos, periodos de tiempo de la enfermedad, como el periodo de incubación, el tiempo de generación y el intervalo serial.

Introducción

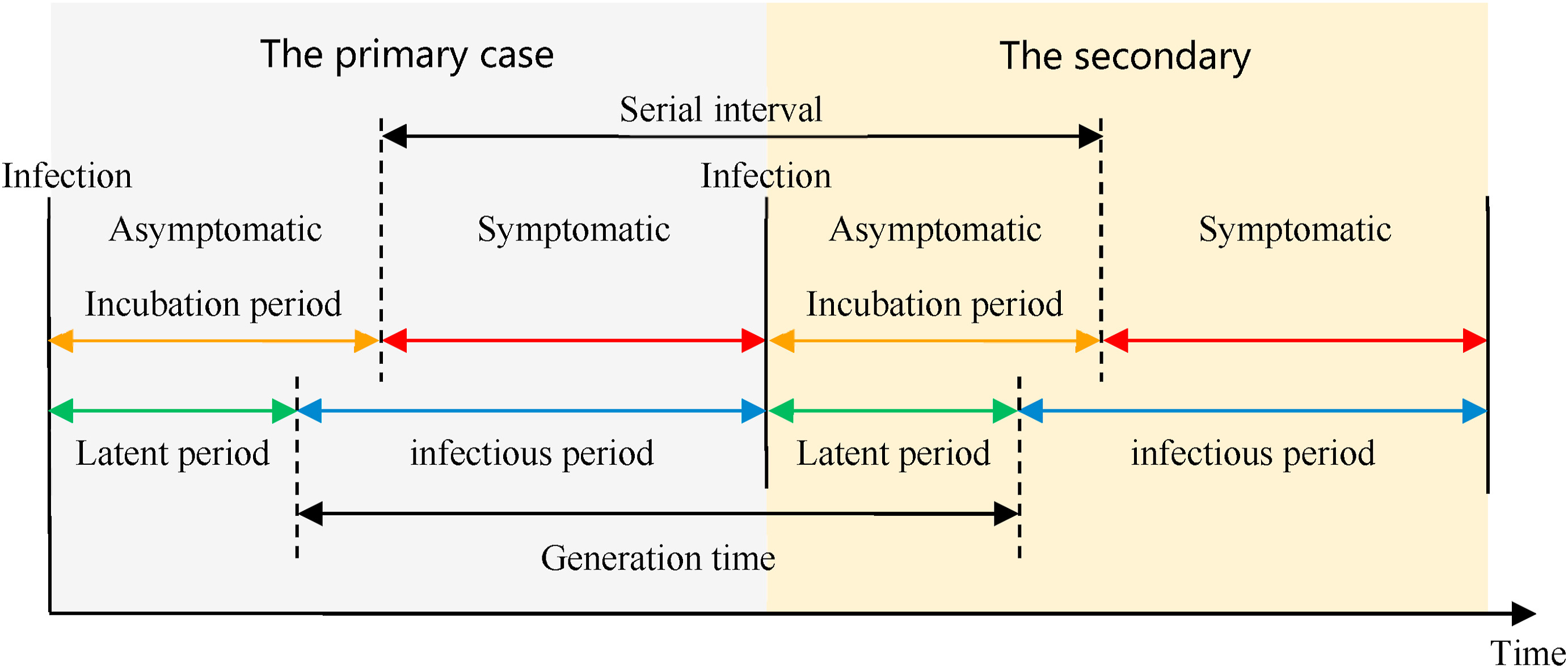

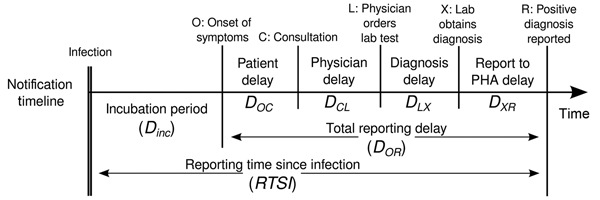

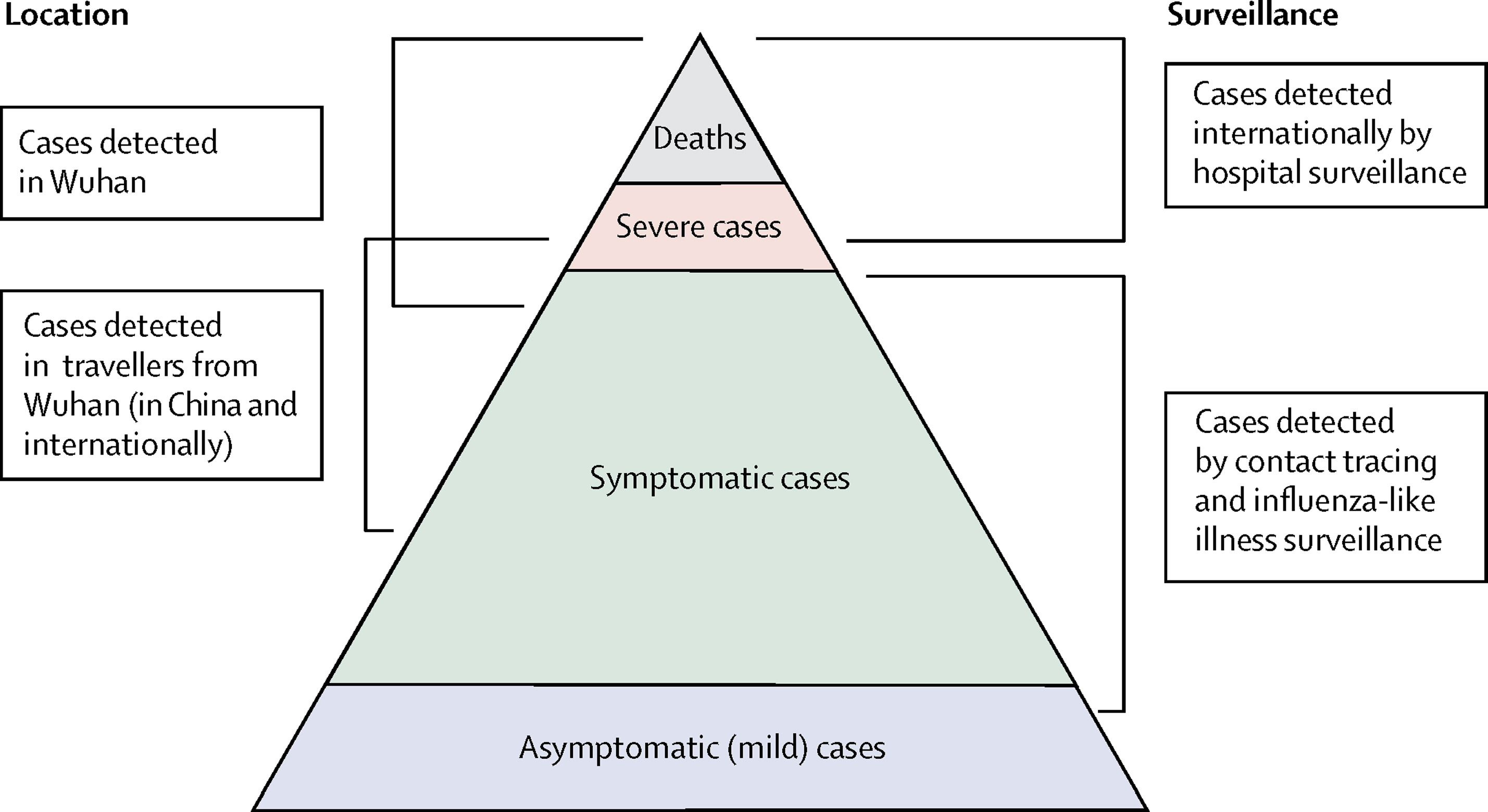

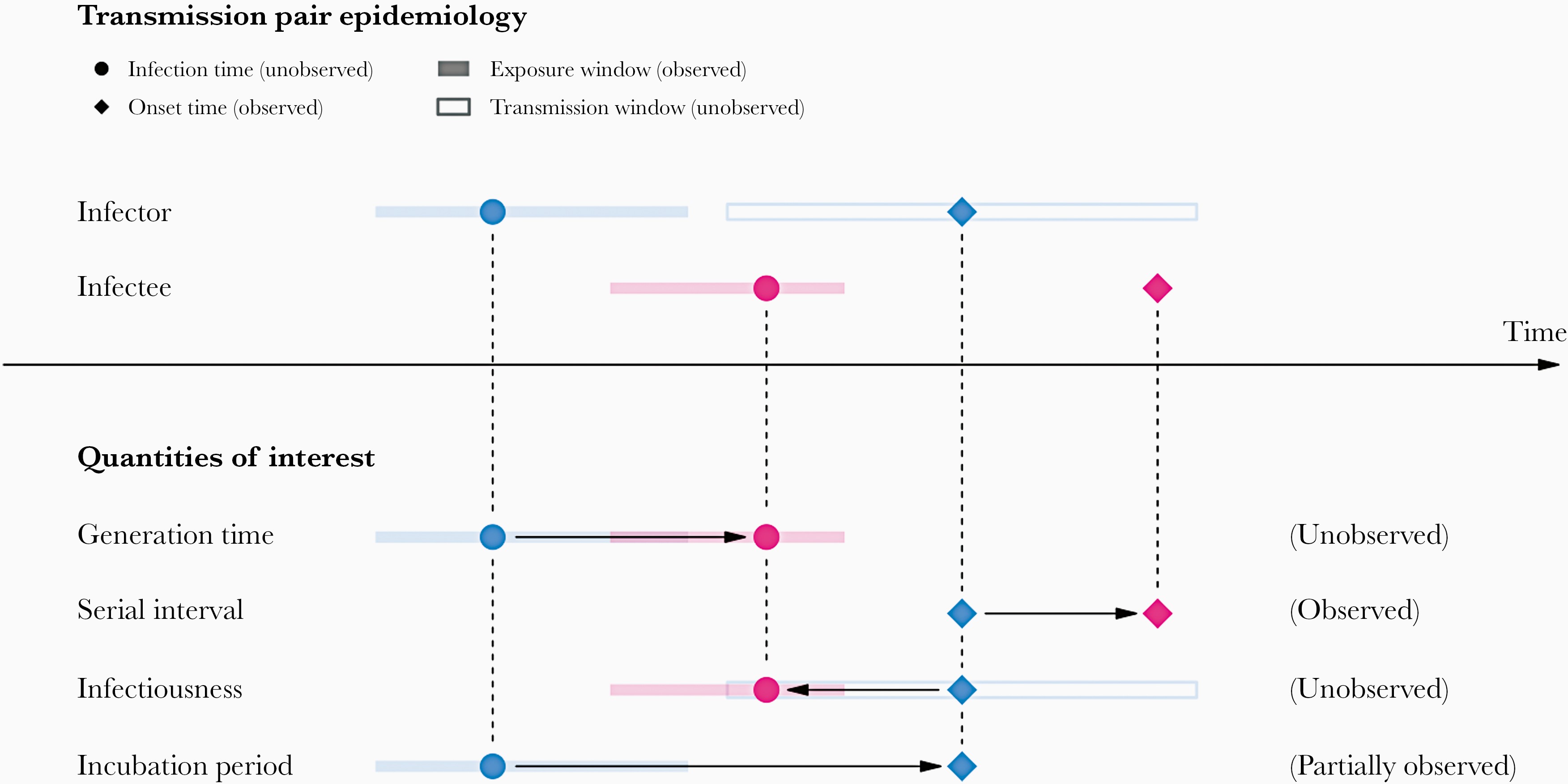

Las enfermedades infecciosas siguen un ciclo de infección, que generalmente incluye las siguientes fases: periodo presintomático, periodo sintomático y periodo de recuperación, tal y como se describe en su historia natural. Estos periodos de tiempo pueden utilizarse para comprender la dinámica de transmisión e informar sobre las intervenciones de prevención y control de enfermedades.

Definiciones

Mira el glosario ¡para ver las definiciones de todos los periodos de tiempo de la figura anterior!

Sin embargo, al inicio de una epidemia, los esfuerzos de modelamiento

pueden verse retrasados por la falta de un recurso centralizado que

resuma los parámetros de entrada para la enfermedad de interés (Nash et al., 2023).

Proyectos como {epiparameter} y {epireview}

están construyendo catálogos en línea siguiendo protocolos de síntesis

de literatura que pueden ayudar a parametrizar modelos accediendo

fácilmente a una extensa biblioteca de parámetros epidemiológicos

previamente estimados de brotes pasados.

Para ejemplificar cómo utilizar el {epiparameter} R en

tu canal de análisis, nuestro objetivo en este episodio será acceder a

un conjunto específico de parámetros epidemiológicos de la literatura,

en lugar de copiarlos y pegarlos manualmente, para integrarlos en un

flujo de trabajo de análisis con EpiNow2

<En este episodio, aprenderemos a acceder a un conjunto concreto

de parámetros epidemiológicos de la bibliografía y a obtener sus

estadísticas resumidas mediante

{epiparameter}. –>

Empecemos cargando el paquete {epiparameter}.

Utilizaremos la tubería %>% para conectar algunas de sus

funciones, algunas funciones detibble y

dplyr, así que llamaremos también al

paquetetidyverse:

R

library(epiparameter)

library(tidyverse)

El doble punto

El doble punto :: en R te permite llamar a una función

específica de un paquete sin cargar todo el paquete en el entorno

actual.

Por ejemplo dplyr::filter(data, condition) utiliza

filter() del paquetedplyr.

Esto nos ayuda a recordar las funciones del paquete y a evitar conflictos de espacio de nombres.

El problema

Si queremos estimar la transmisibilidad de una infección, es común

utilizar un paquete como EpiEstim o

EpiNow2. Sin embargo, ambos requieren cierta información

epidemiológica como entrada. Por ejemplo, en EpiNow2

utilizamos EpiNow2::Gamma() para especificar un tiempo de generación como una

distribución de probabilidad añadiendo su media mean

desviación estándar (sd) y el valor máximo

(max).

Para especificar un tiempo de generación generation_time

que sigue a un Gamma con media \(\mu

= 4\) y desviación estándar \(\sigma =

2\) y un valor máximo de 20, escribimos

R

generation_time <-

EpiNow2::Gamma(

mean = 4,

sd = 2,

max = 20

)

Es una práctica común para analistas, buscar manualmente en la

literatura disponible y copiar y pegar el resumen

estadístico o los parámetros de distribución

de las publicaciones científicas. Un reto frecuente al que nos

enfrentamos a menudo es que la información sobre las distintas

distribuciones estadísticas no es coherente en toda la literatura. El

objetivo de {epiparameter} es facilitar el acceso a

estimaciones confiables de los parámetros de distribución para una serie

de enfermedades infecciosas, de modo que puedan implementarse fácilmente

en las líneas de análisis de brotes.

En este episodio acceder a a las estadísticas resumidas del

tiempo de generación de COVID-19 desde la biblioteca de parámetros

epidemiológicos proporcionada por {epiparameter}. Estos

parámetros pueden utilizarse para estimar la transmisibilidad de esta

enfermedad utilizando EpiNow2 en episodios

posteriores.

Empecemos por ver cuántas entradas hay disponibles en el base

de datos de distribuciones epidemiológicas en

{epiparameter} utilizando epidist_db() para la

distribución epidemiológica epi_dist llamada tiempo de

generación con la cadena "generation":

R

epiparameter::epidist_db(

epi_dist = "generation"

)

SALIDA

Returning 1 results that match the criteria (1 are parameterised).

Use subset to filter by entry variables or single_epidist to return a single entry.

To retrieve the citation for each use the 'get_citation' functionSALIDA

Disease: Influenza

Pathogen: Influenza-A-H1N1

Epi Distribution: generation time

Study: Lessler J, Reich N, Cummings D, New York City Department of Health and

Mental Hygiene Swine Influenza Investigation Team (2009). "Outbreak of

2009 Pandemic Influenza A (H1N1) at a New York City School." _The New

England Journal of Medicine_. doi:10.1056/NEJMoa0906089

<https://doi.org/10.1056/NEJMoa0906089>.

Distribution: weibull

Parameters:

shape: 2.360

scale: 3.180Actualmente, en la biblioteca de parámetros epidemiológicos, tenemos

una entrada de tiempo generación "generation" para

Influenza. En su lugar, podemos consultar intervalos seriales

"serial" para COVID-19. ¡Veamos qué debemos

tener en cuenta para ello!

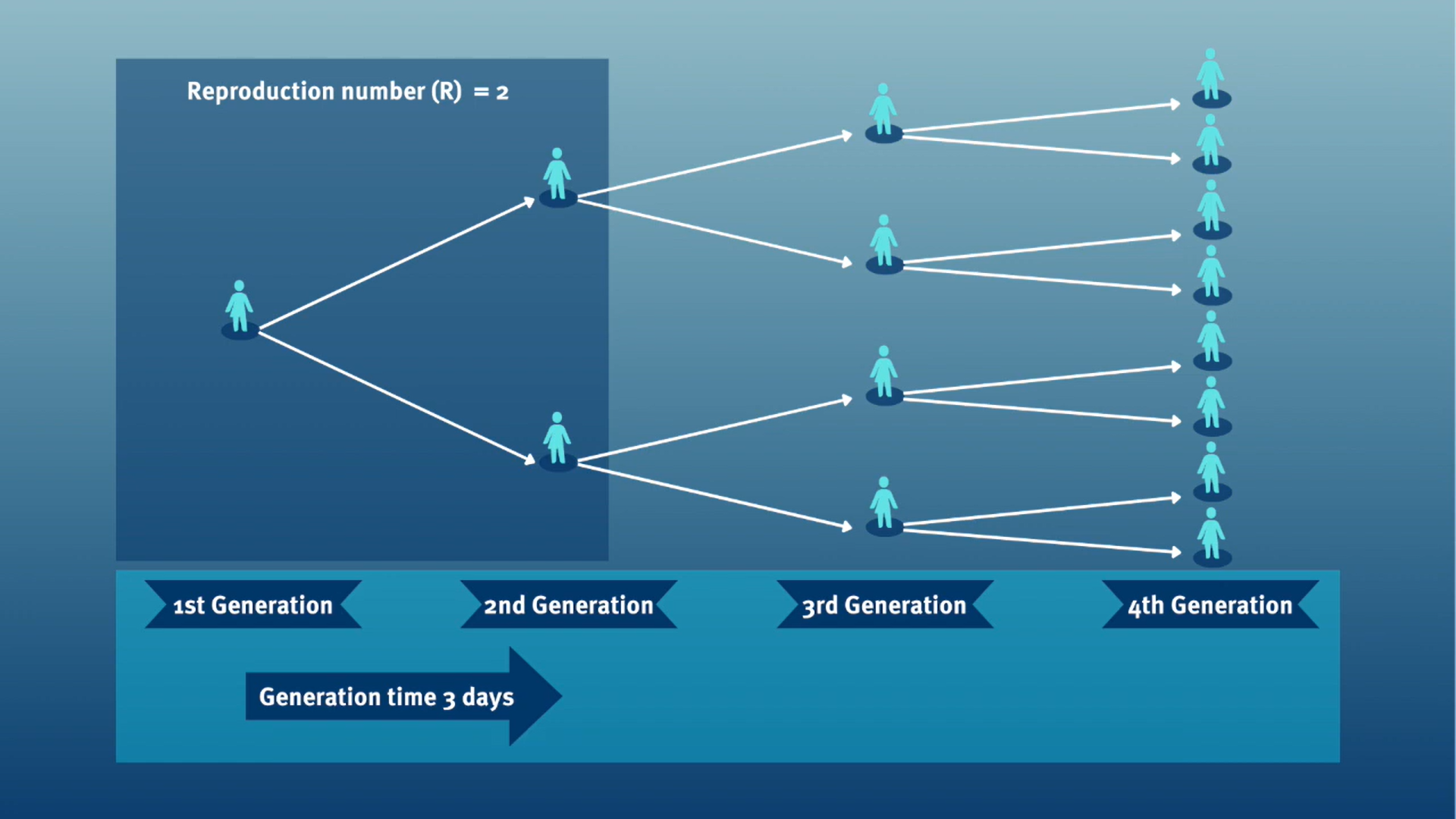

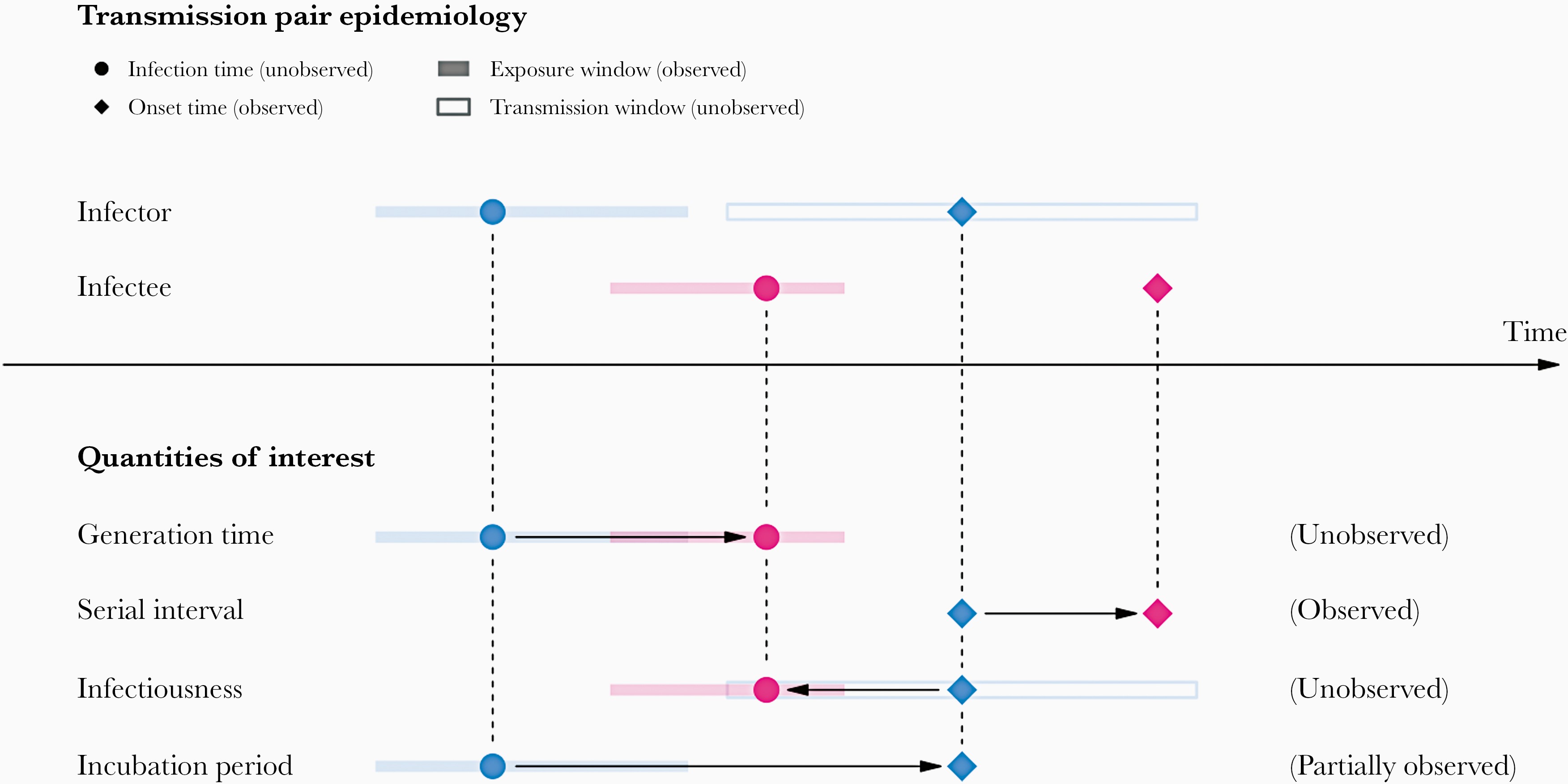

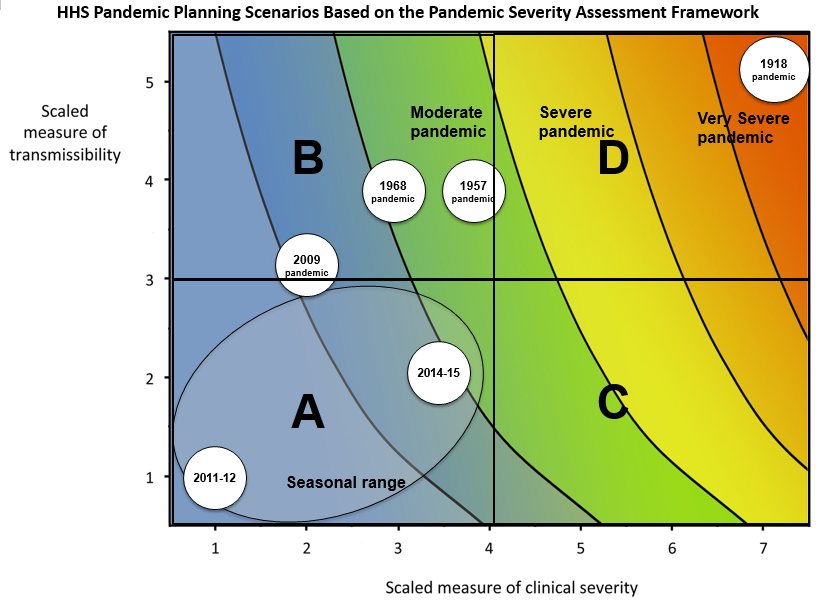

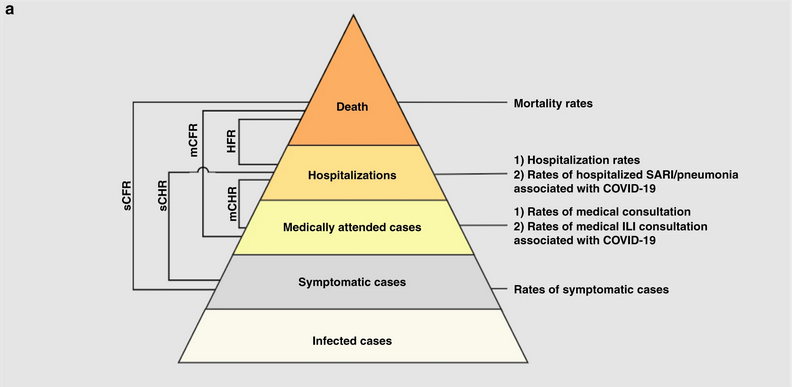

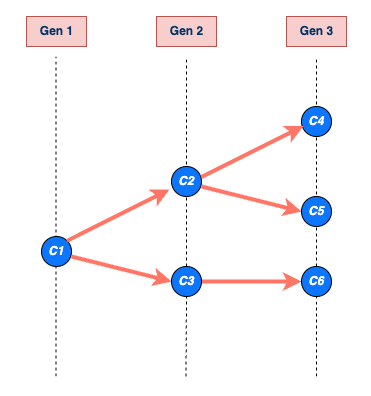

Tiempo de generación vs intervalo serial

El tiempo de generación, junto con el número reproductivo (\(R\)), proporcionan información valiosa sobre la fuerza de transmisión e informan la implementación de medidas de control. Dado un \(R>1\), cuanto más corto sea el tiempo de generación, más rápidamente aumentará la incidencia de casos de enfermedad.

Al calcular el número de reproducción efectivo (\(R_{t}\)), el tiempo de generación suele aproximarse mediante el intervalo serial serial. Esta aproximación frecuente se debe a que es más fácil observar y medir el inicio de los síntomas que el inicio de la infección.

Sin embargo, usar elintervalo serial como una aproximación del tiempo de generación es válido principalmente para las enfermedades en las que la infecciosidad comienza después de la aparición de los síntomas (Chung Lau et al., 2021). En los casos en que la infecciosidad comienza antes de la aparición de los síntomas, los intervalos seriales pueden tener valores negativos, como ocurre en las enfermedades con transmisión presintomática (Nishiura et al., 2020).

De los periodos de tiempo a las distribuciones de probabilidad.

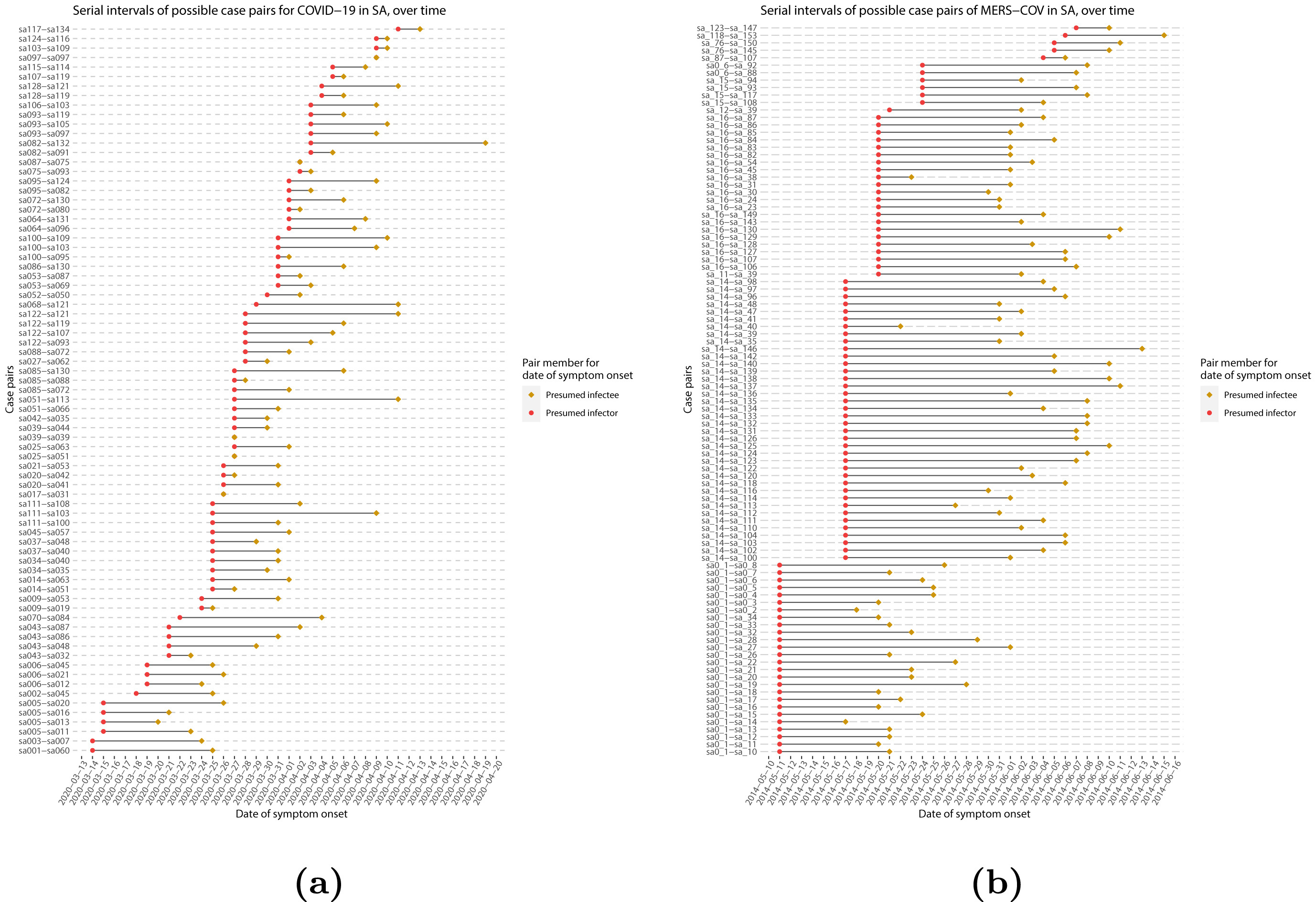

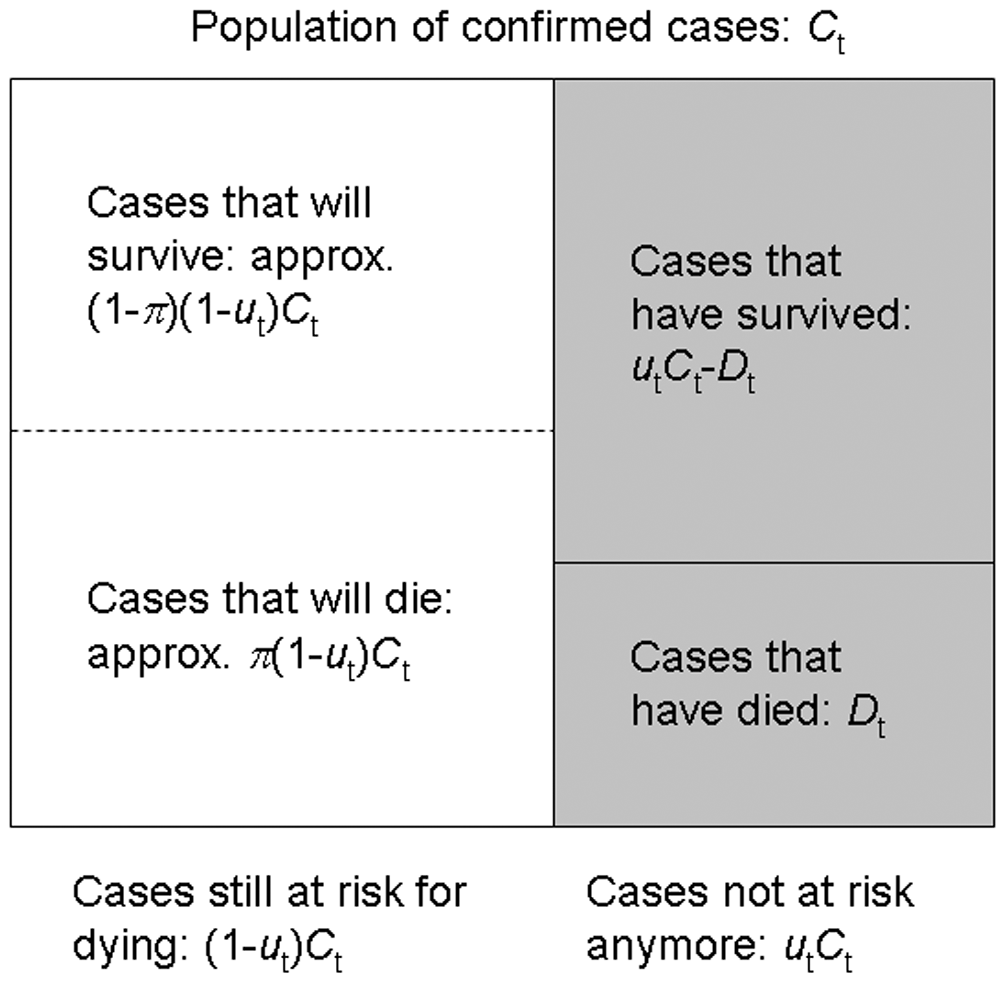

Cuando calculamos el intervalo serial vemos que no todos los pares de casos tienen la misma duración temporal. Observaremos esta variabilidad para cualquier par de casos y periodo de tiempo individual, incluido el periodo de incubación y periodo infeccioso.

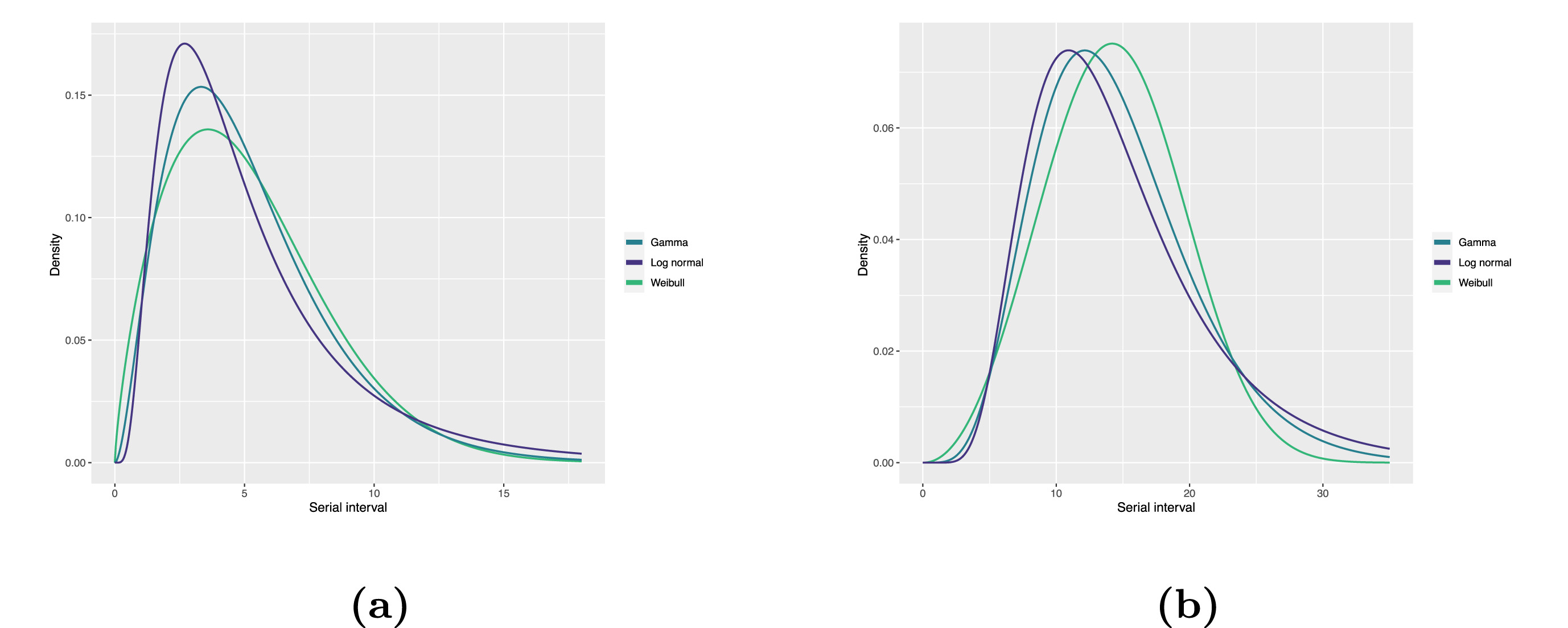

Para resumir estos datos de periodos de tiempo individuales y de pares, podemos encontrar las distribuciones estadísticas que mejor se ajusten a los datos (McFarland et al., 2023).

Las distribuciones estadísticas se resumen en función de sus estadísticas de resumen como la ubicación (media y percentiles) y dispersión (varianza o desviación estándar) de la distribución, o con su parámetros de distribución que informan sobre la forma (shape y rate/scale) de la distribución. Estos valores estimados pueden reportarse con su incertidumbre (intervalos de confianza del 95%).

| Gamma | media | forma | velocidad/escala |

|---|---|---|---|

| MERS-CoV | 14.13(13.9-14.7) | 6.31(4.88-8.52) | 0.43(0.33-0.60) |

| COVID-19 | 5.1(5.0-5.5) | 2.77(2.09-3.88) | 0.53(0.38-0.76) |

| Weibull | media | forma | velocidad/escala |

|---|---|---|---|

| MERS-CoV | 14.2(13.3-15.2) | 3.07(2.64-3.63) | 16.1(15.0-17.1) |

| COVID-19 | 5.2(4.6-5.9) | 1.74(1.46-2.11) | 5.83(5.08-6.67) |

| Log normal | media | mean-log | sd-log |

|---|---|---|---|

| MERS-CoV | 14.08(13.1-15.2) | 2.58(2.50-2.68) | 0.44(0.39-0.5) |

| COVID-19 | 5.2(4.2-6.5) | 1.45(1.31-1.61) | 0.63(0.54-0.74) |

Tabla: Estimaciones del intervalo serial utilizando las distribuciones Gamma, Weibull y Log Normal. Los intervalos de confianza del 95% para los parámetros de forma y escala (shape y rate, en inglés) para Gamma (meanlog y sdlog para Log Normal) se muestran entre paréntesis (Althobaity et al., 2022).

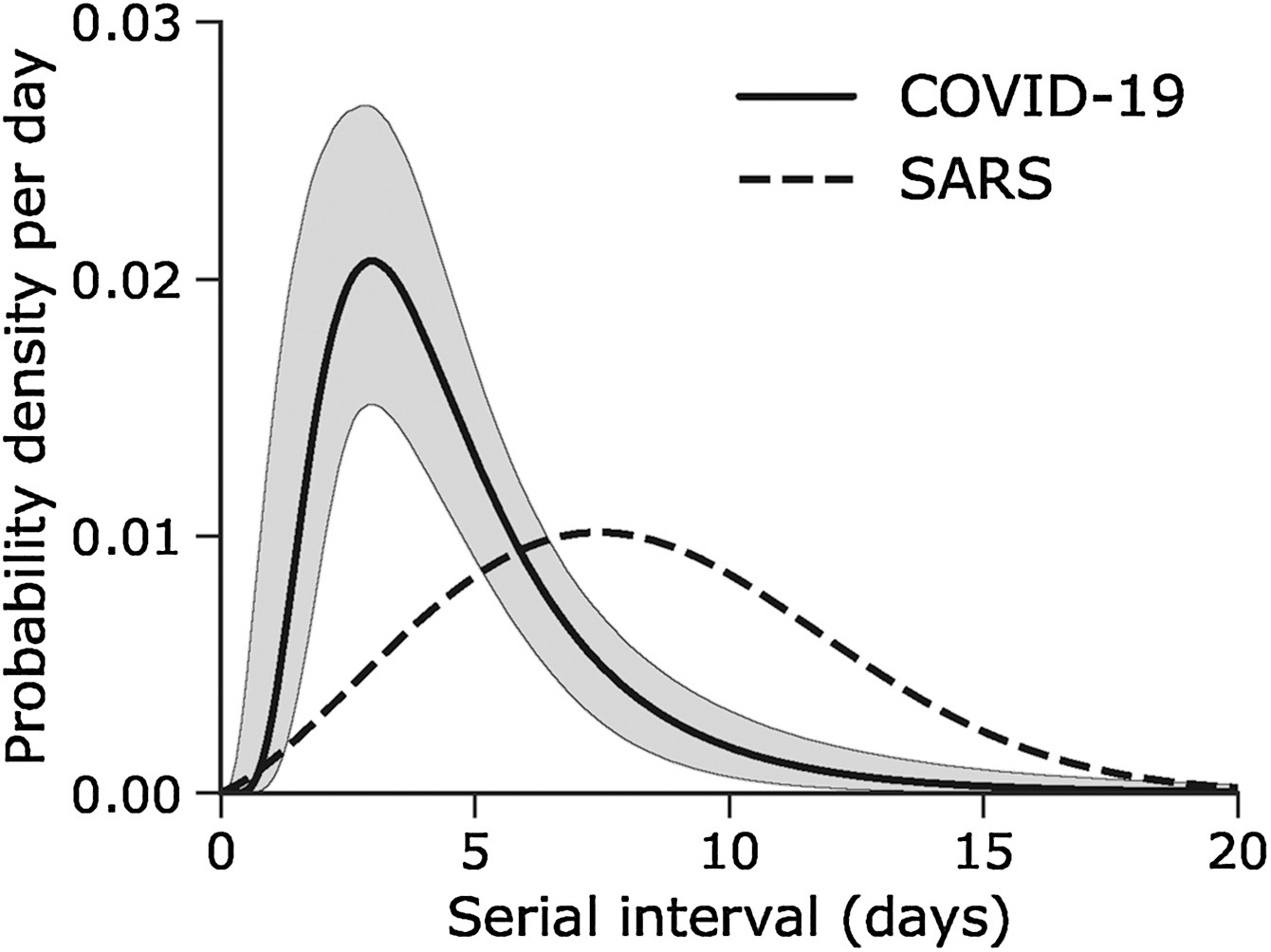

Intervalo serial

Supongamos que COVID-19 y SARS tienen valores similares de número de reproducción y que el intervalo serial se aproxima al tiempo de generación.

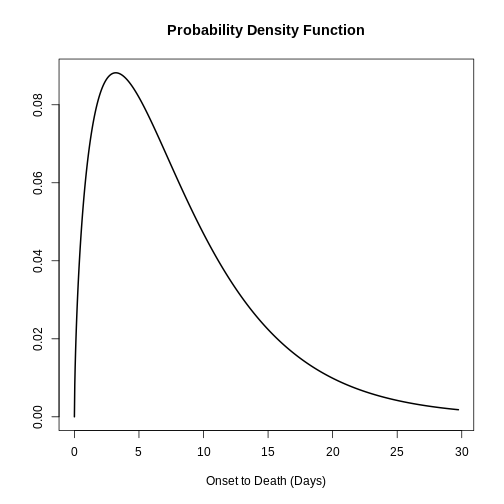

Dado el intervalo serial de ambas infecciones en la siguiente gráfica

- ¿Cuál sería más difícil de controlar?

- ¿Por qué llegas a esa conclusión?

El pico de cada curva puede informarte sobre la ubicación de la media de cada distribución. Cuanto mayor sea la media, mayor será el intervalo serial.

¿Cuál sería más difícil de controlar?

COVID-19

¿Por qué concluyes eso?

COVID-19 tiene el intervalo serial promedioo más bajo. El valor promedio aproximado del intervalo serial de COVID-19 es de unos cuatro días, mientras que del SARS es de aproximadamentesiete días. Por lo tanto, es probable que COVID-19 tenga nuevas generaciones en menos tiempo que el SARS, asumiendo valores de número de reproducción similares.

Elección de parámetros epidemiológicos

En esta sección, utilizaremos {epiparameter} para

obtener el intervalo serial de COVID-19, como una alternativa al tiempo

de generación.

Preguntémonos ahora cuántos parámetros tenemos en la base de datos de

distribuciones epidemiológicas (epidist_db()) con la

enfermedaddisease denominada covid-19.

¡Ejecútalo localmente!

R

epiparameter::epidist_db(

disease = "covid"

)

Desde el paquete {epiparameter} podemos utilizar la

función epidist_db() para consultar cualquier enfermedad

disease y también para una distribución epidemiológica

concreta (epi_dist). Ejecútalo en tu consola:

R

epiparameter::epidist_db(

disease = "COVID",

epi_dist = "serial"

)

Con esta combinación de consultas, obtenemos más de una distribución

de retraso. Esta salida es un <epidist> objeto de

clase.

INSENSIBLE A MAYÚSCULAS Y MINÚSCULAS

epidist_db es insensible

a mayúsculas y minúsculas. Esto significa que puedes utilizar

cadenas con letras en mayúsculas o minúsculas indistintamente. Cadenas

como "serial", "serial interval" o

"serial_interval" también son válidos.

Como se sugiere en los resultados, para resumir una

<epidist> y obtener los nombres de las columnas de la

base de datos de parámetros subyacente, podemos añadir la función

epiparameter::parameter_tbl() al código anterior utilizando

la tubería %>%:

R

epiparameter::epidist_db(

disease = "covid",

epi_dist = "serial"

) %>%

epiparameter::parameter_tbl()

SALIDA

Returning 4 results that match the criteria (3 are parameterised).

Use subset to filter by entry variables or single_epidist to return a single entry.

To retrieve the citation for each use the 'get_citation' functionSALIDA

# Parameter table:

# A data frame: 4 × 7

disease pathogen epi_distribution prob_distribution author year sample_size

<chr> <chr> <chr> <chr> <chr> <dbl> <dbl>

1 COVID-19 SARS-CoV… serial interval <NA> Alene… 2021 3924

2 COVID-19 SARS-CoV… serial interval lnorm Nishi… 2020 28

3 COVID-19 SARS-CoV… serial interval weibull Nishi… 2020 18

4 COVID-19 SARS-CoV… serial interval norm Yang … 2020 131En el epiparameter::parameter_tbl() salida, también

podemos encontrar distintos tipos de distribuciones de probabilidad (por

ejemplo, Log-normal, Weibull, Normal).

{epiparameter} utiliza la base R para las

distribuciones. Por eso Normal logarítmica se llama

lnorm.

Las entradas con un valor faltante (<NA>) en la

columna prob_distribution son entradas no

parametrizada. Tienen estadísticas de resumen, pero no una

distribución de probabilidad. Compara estos dos resultados:

R

# get an <epidist> object

distribution <-

epiparameter::epidist_db(

disease = "covid",

epi_dist = "serial"

)

distribution %>%

# pluck the first entry in the object class <list>

pluck(1) %>%

# check if <epidist> object have distribution parameters

is_parameterised()

# check if the second <epidist> object

# have distribution parameters

distribution %>%

pluck(2) %>%

is_parameterised()

Las entradas parametrizadas tienen un método de Inferencia

Como se detalla en ?is_parameterised una distribución

parametrizada es la entrada que tiene una distribución de probabilidad

asociada proporcionada por un método inference_method como

se muestra en los metadatosmetadata:

R

distribution[[1]]$metadata$inference_method

distribution[[2]]$metadata$inference_method

distribution[[4]]$metadata$inference_method

¡Encuentra tus distribuciones de retraso!

Tómate 2 minutos para explorar el paquete

{epiparameter}.

Elige una enfermedad de interés (por ejemplo, Influenza estacional, sarampión, etc.) y una distribución de retrasos (por ejemplo, el periodo de incubación, desde el inicio hasta la muerte, etc.).

Encuéntra:

¿Cuántas distribuciones de retraso hay para esa enfermedad?

¿Cuántos tipos de distribución de probabilidad (por ejemplo, gamma, log normal) hay para un retraso determinado en esa enfermedad?

Pregunta:

¿Reconoces los artículos?

¿Debería la revisión de literatura de

{epiparameter}considerar otro artículo?

La función epidist_db() con disease sólo

con la enfermedad cuenta el número de entradas como

- estudios, y

- distribuciones de retrasos.

La función epidist_db() función con la enfermedad

disease y epi_dist obtiene una lista de todas

las entradas con:

- la cita completa,

- en tipo de distribución de probabilidad, y

- valores de los parámetros de la distribución.

La combinación de epidist_db() y

parameter_tbl() obtiene un marco de datos de todas las

entradas con columnas como

- el tipo de la distribución de probabilidad por cada fila, y

- autor y año del estudio.

Elegimos explorar las distribuciones de retraso del Ébola:

R

# we expect 16 delays distributions for ebola

epiparameter::epidist_db(

disease = "ebola"

)

SALIDA

Returning 17 results that match the criteria (17 are parameterised).

Use subset to filter by entry variables or single_epidist to return a single entry.

To retrieve the citation for each use the 'get_citation' functionSALIDA

# List of 17 <epidist> objects

Number of diseases: 1

❯ Ebola Virus Disease

Number of epi distributions: 9

❯ hospitalisation to death ❯ hospitalisation to discharge ❯ incubation period ❯ notification to death ❯ notification to discharge ❯ offspring distribution ❯ onset to death ❯ onset to discharge ❯ serial interval

[[1]]

Disease: Ebola Virus Disease

Pathogen: Ebola Virus

Epi Distribution: offspring distribution

Study: Lloyd-Smith J, Schreiber S, Kopp P, Getz W (2005). "Superspreading and

the effect of individual variation on disease emergence." _Nature_.

doi:10.1038/nature04153 <https://doi.org/10.1038/nature04153>.

Distribution: nbinom

Parameters:

mean: 1.500

dispersion: 5.100

[[2]]

Disease: Ebola Virus Disease

Pathogen: Ebola Virus-Zaire Subtype

Epi Distribution: incubation period

Study: Eichner M, Dowell S, Firese N (2011). "Incubation period of ebola

hemorrhagic virus subtype zaire." _Osong Public Health and Research

Perspectives_. doi:10.1016/j.phrp.2011.04.001

<https://doi.org/10.1016/j.phrp.2011.04.001>.

Distribution: lnorm

Parameters:

meanlog: 2.487

sdlog: 0.330

[[3]]

Disease: Ebola Virus Disease

Pathogen: Ebola Virus-Zaire Subtype

Epi Distribution: onset to death

Study: The Ebola Outbreak Epidemiology Team, Barry A, Ahuka-Mundeke S, Ali

Ahmed Y, Allarangar Y, Anoko J, Archer B, Abedi A, Bagaria J, Belizaire

M, Bhatia S, Bokenge T, Bruni E, Cori A, Dabire E, Diallo A, Diallo B,

Donnelly C, Dorigatti I, Dorji T, Waeber A, Fall I, Ferguson N,

FitzJohn R, Tengomo G, Formenty P, Forna A, Fortin A, Garske T,

Gaythorpe K, Gurry C, Hamblion E, Djingarey M, Haskew C, Hugonnet S,

Imai N, Impouma B, Kabongo G, Kalenga O, Kibangou E, Lee T, Lukoya C,

Ly O, Makiala-Mandanda S, Mamba A, Mbala-Kingebeni P, Mboussou F,

Mlanda T, Makuma V, Morgan O, Mulumba A, Kakoni P, Mukadi-Bamuleka D,

Muyembe J, Bathé N, Ndumbi Ngamala P, Ngom R, Ngoy G, Nouvellet P, Nsio

J, Ousman K, Peron E, Polonsky J, Ryan M, Touré A, Towner R, Tshapenda

G, Van De Weerdt R, Van Kerkhove M, Wendland A, Yao N, Yoti Z, Yuma E,

Kalambayi Kabamba G, Mwati J, Mbuy G, Lubula L, Mutombo A, Mavila O,

Lay Y, Kitenge E (2018). "Outbreak of Ebola virus disease in the

Democratic Republic of the Congo, April–May, 2018: an epidemiological

study." _The Lancet_. doi:10.1016/S0140-6736(18)31387-4

<https://doi.org/10.1016/S0140-6736%2818%2931387-4>.

Distribution: gamma

Parameters:

shape: 2.400

scale: 3.333

# ℹ 14 more elements

# ℹ Use `print(n = ...)` to see more elements.

# ℹ Use `parameter_tbl()` to see a summary table of the parameters.

# ℹ Explore database online at: https://epiverse-trace.github.io/epiparameter/dev/articles/database.htmlAhora, a partir de la salida de

epiparameter::epidist_db() ¿Qué es un distribución de la

descendencia?

Elegimos encontrar los periodos de incubación del ébola. Esta salida lista todos los documentos y parámetros encontrados. Ejecútalo localmente si es necesario:

R

epiparameter::epidist_db(

disease = "ebola",

epi_dist = "incubation"

)

Utilizamos parameter_tbl() para obtener una

visualización resumida de todo:

R

# we expect 2 different types of delay distributions

# for ebola incubation period

epiparameter::epidist_db(

disease = "ebola",

epi_dist = "incubation"

) %>%

parameter_tbl()

SALIDA

Returning 5 results that match the criteria (5 are parameterised).

Use subset to filter by entry variables or single_epidist to return a single entry.

To retrieve the citation for each use the 'get_citation' functionSALIDA

# Parameter table:

# A data frame: 5 × 7

disease pathogen epi_distribution prob_distribution author year sample_size

<chr> <chr> <chr> <chr> <chr> <dbl> <dbl>

1 Ebola Vi… Ebola V… incubation peri… lnorm Eichn… 2011 196

2 Ebola Vi… Ebola V… incubation peri… gamma WHO E… 2015 1798

3 Ebola Vi… Ebola V… incubation peri… gamma WHO E… 2015 49

4 Ebola Vi… Ebola V… incubation peri… gamma WHO E… 2015 957

5 Ebola Vi… Ebola V… incubation peri… gamma WHO E… 2015 792Encontramos dos tipos de distribuciones de probabilidad para esta consulta: log normal y gamma.

¿Cómo realiza {epiparameter} la recopilación y revisión

de la literatura revisada por pares? ¡Te invitamos a leer la viñeta

sobre “Protocolo

de Recopilación y Síntesis de Datos” !

Selecciona una única distribución

En epiparameter::epidist_db() funciona como una función

de filtrado o subconjunto. Utilicemos el argumento author

para filtrar los parámetros Hiroshi Nishiura:

R

epiparameter::epidist_db(

disease = "covid",

epi_dist = "serial",

author = "Hiroshi"

) %>%

epiparameter::parameter_tbl()

SALIDA

Returning 2 results that match the criteria (2 are parameterised).

Use subset to filter by entry variables or single_epidist to return a single entry.

To retrieve the citation for each use the 'get_citation' functionSALIDA

# Parameter table:

# A data frame: 2 × 7

disease pathogen epi_distribution prob_distribution author year sample_size

<chr> <chr> <chr> <chr> <chr> <dbl> <dbl>

1 COVID-19 SARS-CoV… serial interval lnorm Nishi… 2020 28

2 COVID-19 SARS-CoV… serial interval weibull Nishi… 2020 18Seguimos obteniendo más de un parámetro epidemiológico. Podemos

establecer el argumento single_epidist en TRUE

para obtener sólo uno:

R

epiparameter::epidist_db(

disease = "covid",

epi_dist = "serial",

single_epidist = TRUE

)

SALIDA

Using Nishiura H, Linton N, Akhmetzhanov A (2020). "Serial interval of novel

coronavirus (COVID-19) infections." _International Journal of

Infectious Diseases_. doi:10.1016/j.ijid.2020.02.060

<https://doi.org/10.1016/j.ijid.2020.02.060>..

To retrieve the citation use the 'get_citation' functionSALIDA

Disease: COVID-19

Pathogen: SARS-CoV-2

Epi Distribution: serial interval

Study: Nishiura H, Linton N, Akhmetzhanov A (2020). "Serial interval of novel

coronavirus (COVID-19) infections." _International Journal of

Infectious Diseases_. doi:10.1016/j.ijid.2020.02.060

<https://doi.org/10.1016/j.ijid.2020.02.060>.

Distribution: lnorm

Parameters:

meanlog: 1.386

sdlog: 0.568¿Cómo funciona ‘single_epidist’?

Consultando la documentación de ayuda de

?epiparameter::epidist_db():

- Si varias entradas coinciden con los argumentos suministrados y

single_epidist = TRUEentonces devolverá el<epidist>parametrizado con el mayor tamaño de muestra - Si varias entradas son iguales después de esta clasificación, se devolverá la primera entrada.

¿Qué es un <epidist>parametrizado ? Mira

?is_parameterised.

Asignemos este objeto de clase <epidist> al

objetocovid_serialint.

R

covid_serialint <-

epiparameter::epidist_db(

disease = "covid",

epi_dist = "serial",

single_epidist = TRUE

)

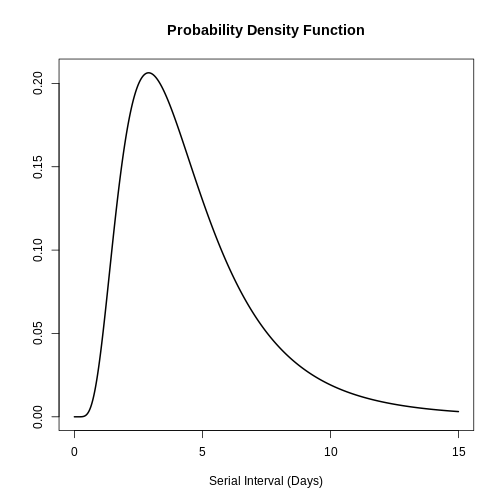

Puedes utilizar plot() para objetos

<epidist> para visualizarlos:

- la Función de densidad de probabilidad (PDF, por sus siglas en inglés) y

- la Función de distribución acumulativa (CDF, por sus siglas en inglés).

R

# plot <epidist> object

plot(covid_serialint)

Con el argumento day_range, puedes cambiar la duración o

el número de días del x eje. Explora cómo se ve esto:

R

# plot <epidist> object

plot(covid_serialint, day_range = 0:20)

Extrae las estadísticas de resumen

Podemos obtener la media o primediomean y la desviación

estándar(sd) a partir de <epidist>

accediendo al objetosummary_stats:

R

# get the mean

covid_serialint$summary_stats$mean

SALIDA

[1] 4.7¡Ahora tenemos un parámetro epidemiológico que podemos reutilizar!

Dado que el covid_serialint es una distribución log normal

lnorm o, podemos reemplazar las estadísticas de

resumen que introducimos en la función

EpiNow2::LogNormal()

R

generation_time <-

EpiNow2::LogNormal(

mean = covid_serialint$summary_stats$mean, # replaced!

sd = covid_serialint$summary_stats$sd, # replaced!

max = 20

)

En el próximo episodio aprenderemos a utilizar EpiNow2

para especificar correctamente las distribuciones y estimar la

transmisibilidad. Después, cómo utilizar funciones de

distribución para obtener un valor máximo (max)

para EpiNow2::LogNormal() y utilizar

{epiparameter} en tu análisis.

Distribuciones logarítmicas normales

Si necesitas los parámetros de la distribución log normal log

normales en lugar de las estadísticas de resumen, podemos

utilizar epiparameter::get_parameters():

R

covid_serialint_parameters <-

epiparameter::get_parameters(covid_serialint)

covid_serialint_parameters

SALIDA

meanlog sdlog

1.3862617 0.5679803 Se obtiene un vector de clase <numeric> ¡listo

para usar como entrada para cualquier otro paquete!

Desafíos

Intervalo serial del ébola

Tómate 1 minuto para

Obtener acceso al intervalo serial de ébola con el mayor tamaño de muestra.

Responde:

¿Qué es el

sdde la distribución epidemiológica?¿Cuál es el tamaño de muestra

sample_sizeutilizado en ese estudio?

R

# ebola serial interval

ebola_serial <-

epiparameter::epidist_db(

disease = "ebola",

epi_dist = "serial",

single_epidist = TRUE

)

SALIDA

Using WHO Ebola Response Team, Agua-Agum J, Ariyarajah A, Aylward B, Blake I,

Brennan R, Cori A, Donnelly C, Dorigatti I, Dye C, Eckmanns T, Ferguson

N, Formenty P, Fraser C, Garcia E, Garske T, Hinsley W, Holmes D,

Hugonnet S, Iyengar S, Jombart T, Krishnan R, Meijers S, Mills H,

Mohamed Y, Nedjati-Gilani G, Newton E, Nouvellet P, Pelletier L,

Perkins D, Riley S, Sagrado M, Schnitzler J, Schumacher D, Shah A, Van

Kerkhove M, Varsaneux O, Kannangarage N (2015). "West African Ebola

Epidemic after One Year — Slowing but Not Yet under Control." _The New

England Journal of Medicine_. doi:10.1056/NEJMc1414992

<https://doi.org/10.1056/NEJMc1414992>..

To retrieve the citation use the 'get_citation' functionR

ebola_serial

SALIDA

Disease: Ebola Virus Disease

Pathogen: Ebola Virus

Epi Distribution: serial interval

Study: WHO Ebola Response Team, Agua-Agum J, Ariyarajah A, Aylward B, Blake I,

Brennan R, Cori A, Donnelly C, Dorigatti I, Dye C, Eckmanns T, Ferguson

N, Formenty P, Fraser C, Garcia E, Garske T, Hinsley W, Holmes D,

Hugonnet S, Iyengar S, Jombart T, Krishnan R, Meijers S, Mills H,

Mohamed Y, Nedjati-Gilani G, Newton E, Nouvellet P, Pelletier L,

Perkins D, Riley S, Sagrado M, Schnitzler J, Schumacher D, Shah A, Van

Kerkhove M, Varsaneux O, Kannangarage N (2015). "West African Ebola

Epidemic after One Year — Slowing but Not Yet under Control." _The New

England Journal of Medicine_. doi:10.1056/NEJMc1414992

<https://doi.org/10.1056/NEJMc1414992>.

Distribution: gamma

Parameters:

shape: 2.188

scale: 6.490R

# get the sd

ebola_serial$summary_stats$sd

SALIDA

[1] 9.6R

# get the sample_size

ebola_serial$metadata$sample_size

SALIDA

[1] 305Intenta visualizar esta distribución utilizando

plot().

Explora también todos los demás elementos anidados dentro del objecto

<epidist> .

Comparte sobre:

- ¿Qué elementos encuentras útiles para tu análisis?

- ¿Qué otros elementos te gustaría ver en este objeto? ¿Cómo?

Parámetro de severidad del ébola

Un parámetro de severidad como la duración de la hospitalización podría añadir información necesaria sobre la capacidad de camas en respuesta a un brote (Cori et al., 2017).

Para el ébola:

- ¿Cuál es la estimación puntual reportada de la duración media de la asistencia sanitaria y el aislamiento de casos?

Un retraso informativo debe medir el tiempo transcurrido desde el inicio de los síntomas hasta la recuperación o la muerte.

Encuentra una forma de acceder a toda la base de datos

{epiparameter} y averigua cómo se puede almacenar ese

retraso. La salida de parameter_tbl() es un dataframe o

tabla de datos.

R

# one way to get the list of all the available parameters

epidist_db(disease = "all") %>%

parameter_tbl() %>%

as_tibble() %>%

distinct(epi_distribution)

SALIDA

Returning 122 results that match the criteria (99 are parameterised).

Use subset to filter by entry variables or single_epidist to return a single entry.

To retrieve the citation for each use the 'get_citation' functionSALIDA

# A tibble: 12 × 1

epi_distribution

<chr>

1 incubation period

2 serial interval

3 generation time

4 onset to death

5 offspring distribution

6 hospitalisation to death

7 hospitalisation to discharge

8 notification to death

9 notification to discharge

10 onset to discharge

11 onset to hospitalisation

12 onset to ventilation R

ebola_severity <- epidist_db(

disease = "ebola",

epi_dist = "onset to discharge"

)

SALIDA

Returning 1 results that match the criteria (1 are parameterised).

Use subset to filter by entry variables or single_epidist to return a single entry.

To retrieve the citation for each use the 'get_citation' functionR

# point estimate

ebola_severity$summary_stats$mean

SALIDA

[1] 15.1Comprueba que para algunas entradas de {epiparameter}

también tendrás la incertidumbre en torno a las estimación

puntual de cada estadística de síntesis:

R

# 95% confidence intervals

ebola_severity$summary_stats$mean_ci

SALIDA

[1] 95R

# limits of the confidence intervals

ebola_severity$summary_stats$mean_ci_limits

SALIDA

[1] 14.6 15.6Un zoológico de distribuciones

¡Explora esta shinyapp llamada The distribution zoo !

Sigue estos pasos para reproducir la forma de la distribución de

intervalo serial COVID desde {epiparameter}

(covid_serialint objeto):

- Accede al sitio web de shiny app https://ben18785.shinyapps.io/distribution-zoo/,

- Ve al panel izquierdo,

- Mantén pulsado el botón Categoría de distribución:

Continuous Univariate, - Selecciona un nuevo Tipo de distribución:

Log-Normal, - Mueve los controles deslizantes es decir, el

elemento de control gráfico que te permite ajustar un valor moviendo una

barra horizontal hacia la posición

covid_serialintparámetros.

Reprodúcelos con el botón distribution y todos sus

elementos de lista: [[2]], [[3]] y

[[4]]. Explora cómo cambia la forma de una distribución

cuando cambian sus parámetros.

Comparte sobre:

- ¿Qué otras funciones del sitio web te parecen útiles?

Puntos Clave

- Utiliza

{epiparameter}para acceder al catálogo de literatura sobre distribuciones epidemiológicas de retraso. - Utiliza

epidist_db()para seleccionar distribuciones de retraso individuales. - Utiliza

parameter_tbl()para obtener una visión general de las distribuciones de retardo múltiples. - Reutiliza las estimaciones conocidas para una enfermedad desconocida en la fase inicial de un brote cuando no se disponga de datos de rastreo de contactos.

Content from Cuantificar la transmisión

Última actualización: 2024-11-19 | Mejora esta página

Hoja de ruta

Preguntas

- ¿Cómo puedo estimar el número de reproducción variable en el tiempo (\(Rt\)) y la tasa de crecimiento a partir de una serie temporal de datos de casos?

- ¿Cómo puedo cuantificar la heterogeneidad geográfica a partir de estas métricas de transmisión?

Objetivos

- Aprender a estimar las métricas de transmisión a partir de una serie

temporal de datos de casos utilizando el paquete R

EpiNow2

Requisitos previos

Los alumnos deben familiarizarse con los siguientes conceptos antes de trabajar con este tutorial:

Estadística Distribuciones de probabilidad y principio del análisis bayesiano.

Teoría epidémica Número de reproducción efectiva.

Ciencia de los datos Transformación y visualización de datos. Puedes revisar el episodio en Agregar y visualizar datos de incidencia.

Recordatorio: el Número de Reproducción Efectiva, \(R_t\)

El número básico de reproducción, \(R_0\) es el número medio de casos causados por un individuo infeccioso en una población totalmente susceptible.

Pero en un brote en curso, la población no permanece totalmente susceptible, ya que los que se recuperan de la infección suelen ser inmunes. Además, puede haber cambios de comportamiento u otros factores que afecten la transmisión. Por lo tanto, cuando nos interesa controlar los cambios en la transmisión, es más importante tener en cuenta el valor del número de reproducción efectiva, \(R_t\) y el número medio de casos causados por un individuo infeccioso en la población en el momento \(t\).

Introducción

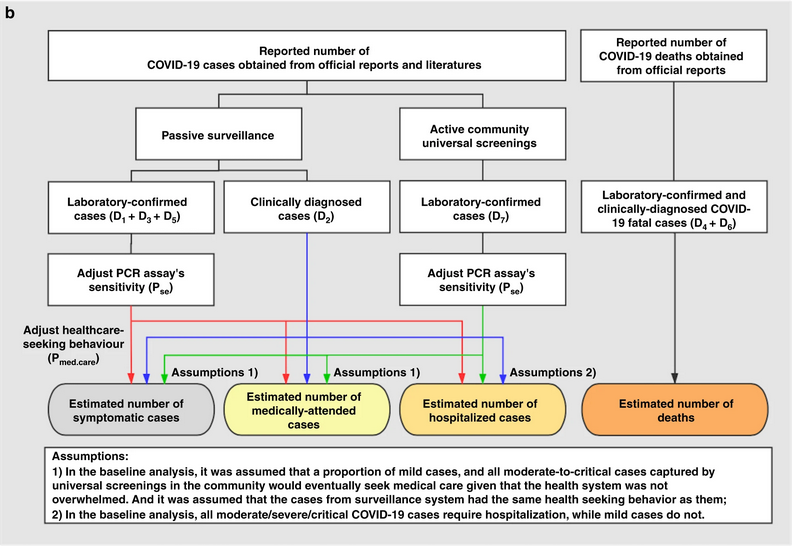

La intensidad de la transmisión de un brote se cuantifica mediante dos métricas clave: el número de reproducción, que informa sobre la fuerza de la transmisión indicando cuántos casos nuevos se esperan de cada caso existente; y la tasa de crecimiento que informa sobre la velocidad de la transmisión, indicando la rapidez con que el brote se propaga o disminuye (tiempo de duplicación/desaparición) dentro de una población. Para más detalles sobre la distinción entre velocidad y fuerza de transmisión y las implicaciones para el control, revisa Dushoff y Park, 2021.

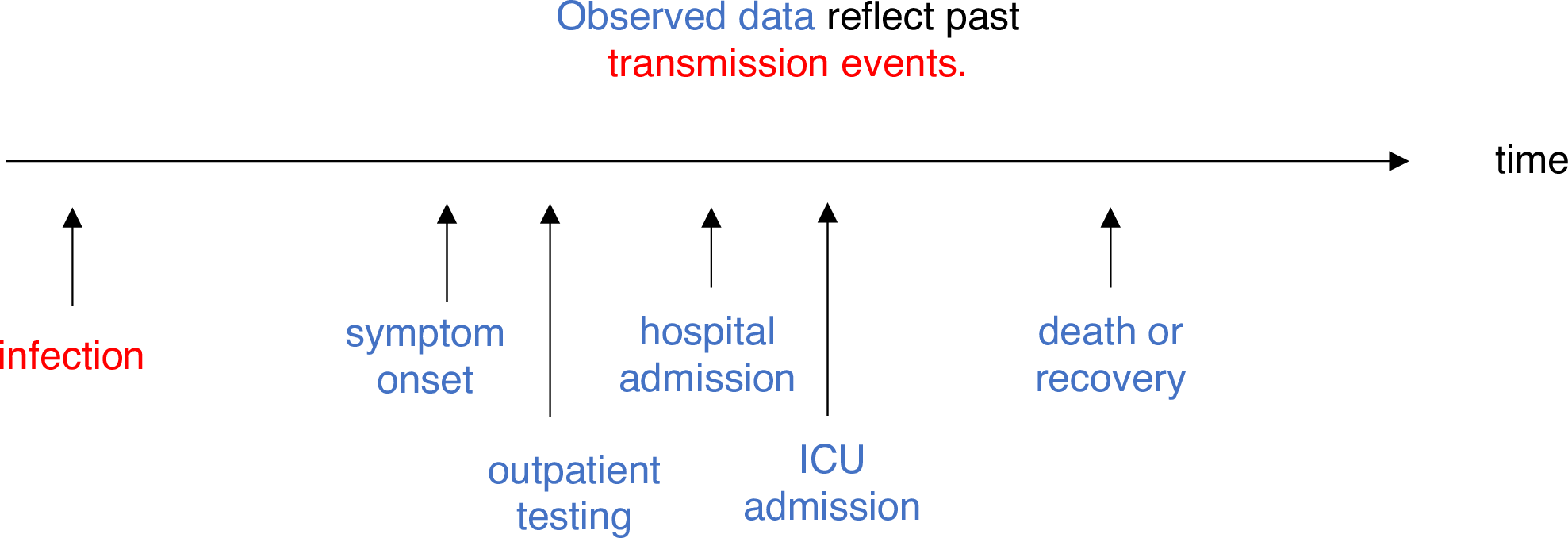

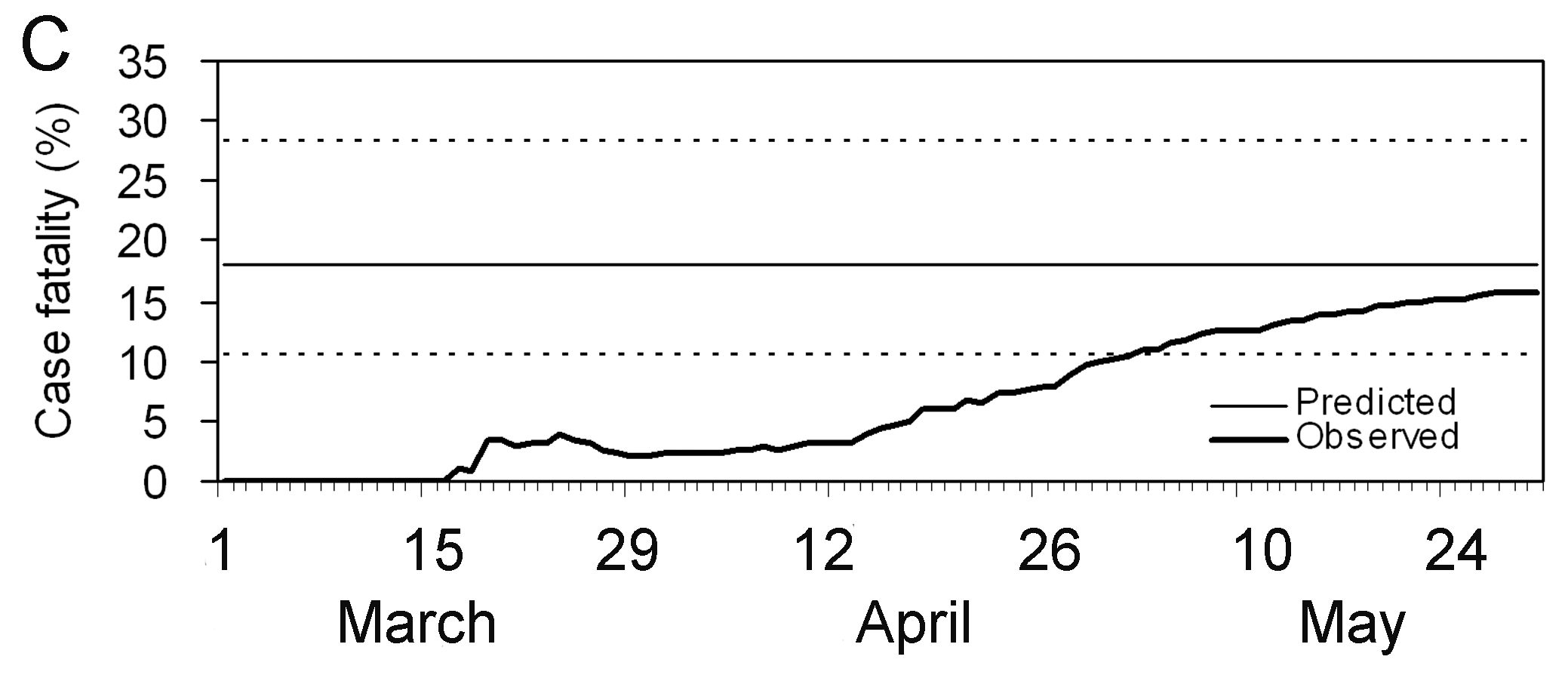

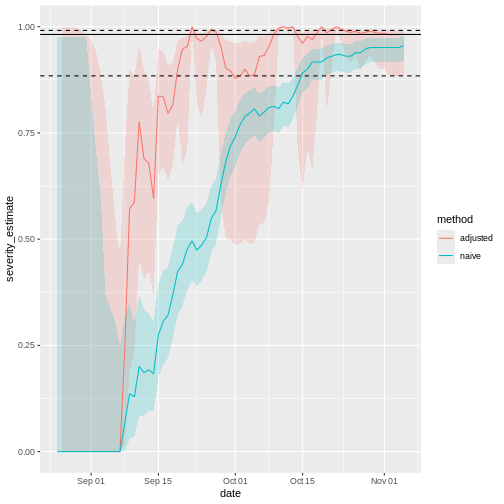

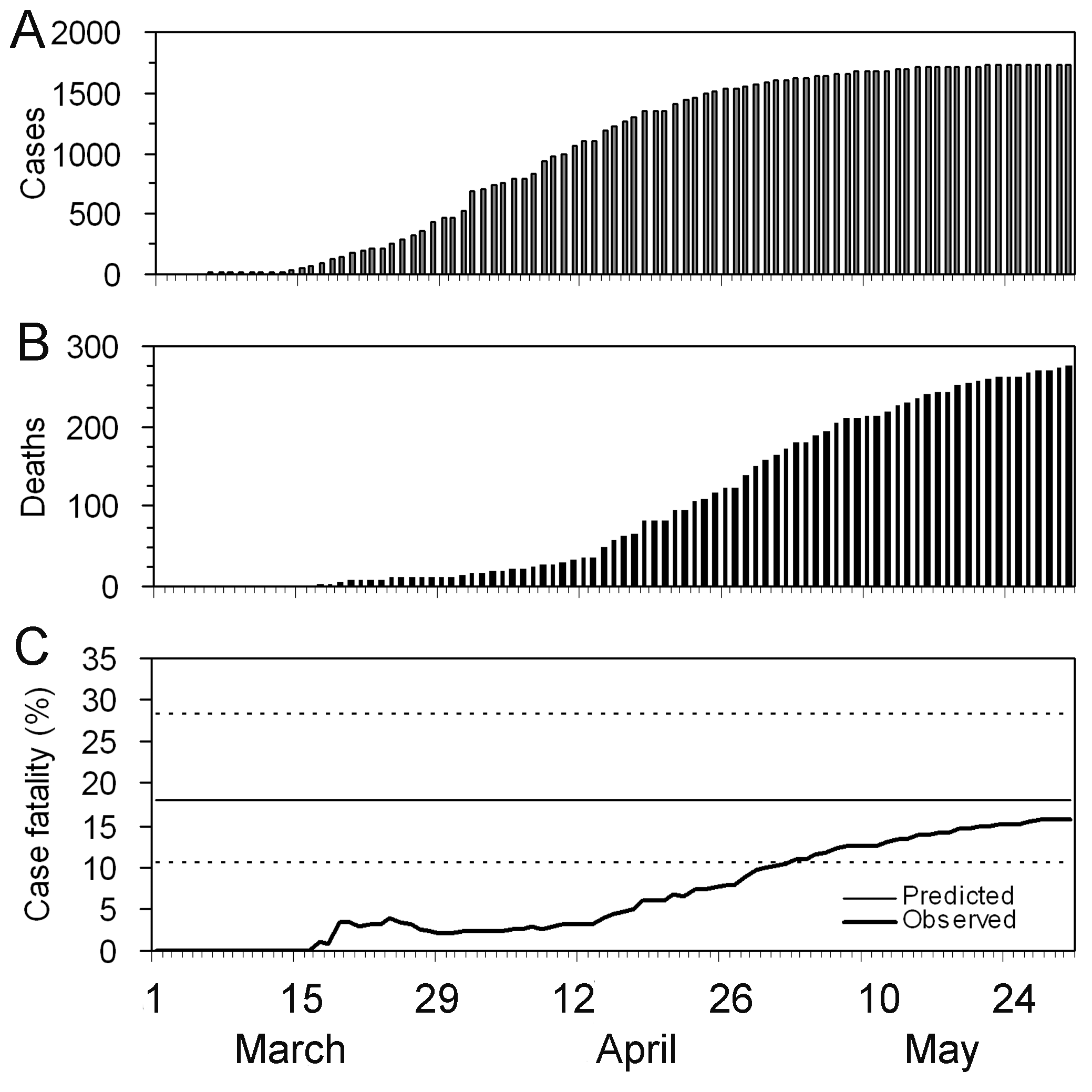

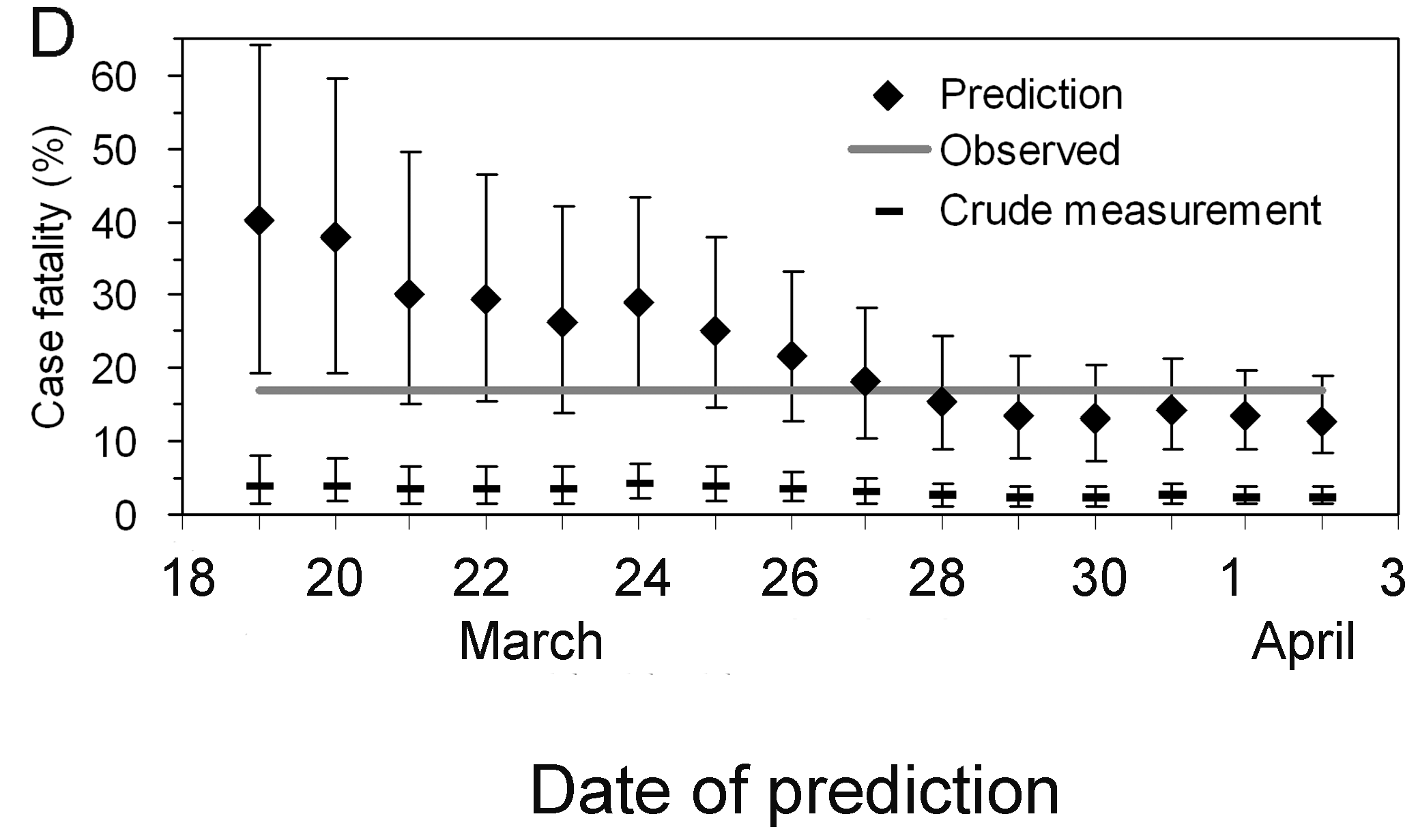

Para estimar estas métricas clave utilizando datos de casos, debemos tener en cuenta los retrasos entre la fecha de las infecciones y la fecha de los casos notificados. En una situación de brote, normalmente sólo se dispone de datos sobre las fechas notificadas, por lo que debemos utilizar métodos de estimación para tener en cuenta estos retrasos cuando intentemos comprender los cambios en la transmisión a lo largo del tiempo.

En los próximos tutoriales nos centraremos en cómo utilizar las funciones de EpiNow2 para estimar las métricas de transmisión de los datos de casos. No cubriremos el trasfondo teórico de los modelos ni el marco de inferencia; para más detalles sobre estos conceptos, consulta la viñeta.

En este tutorial vamos a aprender a utilizar el paquete

EpiNow2 para estimar el número de reproducción variable

en el tiempo. Obtendremos los datos de entrada de

incidence2. Utilizaremos el paquete tidyr

y dplyr para ordenar algunas de sus salidas,

ggplot2 para visualizar la distribución de casos, y el

operador tubería %>% para conectar algunas de sus

funciones, así que también llamaremos al paquete

tidyverse:

R

library(EpiNow2)

library(incidence2)

library(tidyverse)

El doble punto

El doble punto :: en R te permite llamar a una función

específica de un paquete sin cargar todo el paquete en el entorno

actual.

Por ejemplo dplyr::filter(data, condition) utiliza la

función filter() del paquete dplyr.

Esto nos ayuda a recordar las funciones del paquete y a evitar conflictos de espacio de nombres.

Inferencia bayesiana

El paquete R EpiNow2 utiliza inferencia bayesiana para estimar las

cifras de reproducción y los tiempos de infección basándose en las

fechas de notificación.

En la inferencia bayesiana, utilizamos el conocimiento previo (distribuciones previas) con los datos (en una función de verosimilitud) para hallar la probabilidad posterior.

Probabilidad posterior \(\propto\) verosimilitud \(\times\) probabilidad previa

Distribuciones de retrasos y datos de casos

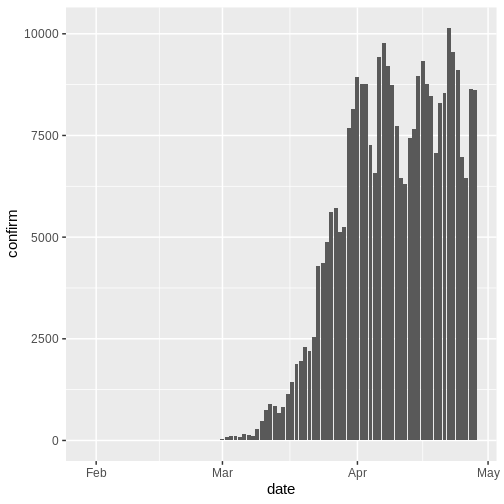

Datos de casos

Para explorar las funciones de EpiNow2 utilizaremos los

datos del brote del inicio de la pandemia COVID-19 del Reino Unido. Los

datos están disponibles en el paquete R incidence2.

R

dplyr::as_tibble(incidence2::covidregionaldataUK)

SALIDA

# A tibble: 6,370 × 13

date region region_code cases_new cases_total deaths_new deaths_total

<date> <chr> <chr> <dbl> <dbl> <dbl> <dbl>

1 2020-01-30 East Mi… E12000004 NA NA NA NA

2 2020-01-30 East of… E12000006 NA NA NA NA

3 2020-01-30 England E92000001 2 2 NA NA

4 2020-01-30 London E12000007 NA NA NA NA

5 2020-01-30 North E… E12000001 NA NA NA NA

6 2020-01-30 North W… E12000002 NA NA NA NA

7 2020-01-30 Norther… N92000002 NA NA NA NA

8 2020-01-30 Scotland S92000003 NA NA NA NA

9 2020-01-30 South E… E12000008 NA NA NA NA

10 2020-01-30 South W… E12000009 NA NA NA NA

# ℹ 6,360 more rows

# ℹ 6 more variables: recovered_new <dbl>, recovered_total <dbl>,

# hosp_new <dbl>, hosp_total <dbl>, tested_new <dbl>, tested_total <dbl>Para utilizar los datos, debemos darles formato para que tengan dos columnas:

-

date: la fecha (para validar si un objeto es de tipo fecha ver?is.Date()), -

confirmnúmero de casos confirmados en esa fecha.

Utilicemos tidyr y incidence2 para ello:

R

cases <- incidence2::covidregionaldataUK %>%

# use {tidyr} to preprocess missing values

tidyr::replace_na(base::list(cases_new = 0)) %>%

# use {incidence2} to compute the daily incidence

incidence2::incidence(

date_index = "date",

counts = "cases_new",

count_values_to = "confirm",

date_names_to = "date",

complete_dates = TRUE

) %>%

dplyr::select(-count_variable)

Con incidence2::incidence() agregamos casos en distintos

tiempos intervalos (es decir, días, semanas o meses) o por

grupo categorías. También podemos tener fechas completas para

todo el rango de fechas por categoría de grupo utilizando

complete_dates = TRUE Explora más adelante la incidence2::incidence()

manual de referencia

Podemos obtener un objeto similar a cases de la tabla de

datos (data.frame)

incidence2::covidregionaldataUK utilizando las siguientes

funciones del paquete dplyr:

R

incidence2::covidregionaldataUK %>%

dplyr::select(date, cases_new) %>%

dplyr::group_by(date) %>%

dplyr::summarise(confirm = sum(cases_new, na.rm = TRUE)) %>%

dplyr::ungroup()

Sin embargo, la función incidence2::incidence() contiene

argumentos prácticos como complete_dates que facilitan la

obtención de un objeto de incidencia con el mismo rango de fechas para

cada agrupación sin necesidad de líneas de código adicionales ni de un

paquete de series temporales.

Hay datos de casos disponibles para 490 días, pero en una situación de brote es probable que sólo tuviéramos acceso al principio de este conjunto de datos. Por lo tanto, suponemos que sólo disponemos de los primeros 90 días de estos datos.

Distribuciones de retraso

Suponemos que hay retrasos desde el momento de la infección hasta el momento en que se notifica un caso. Especificamos estos retrasos como distribuciones para tener en cuenta la incertidumbre en las diferencias a nivel individual. El retraso puede consistir en múltiples tipos de retrasos/procesos. Un retraso típico desde el momento de la infección hasta la notificación del caso puede consistir en:

tiempo desde la infección hasta la aparición de los síntomas (el período de incubación) + tiempo desde el inicio de los síntomas hasta la notificación del caso (el tiempo de notificación).

La distribución del retraso para cada uno de estos procesos puede

estimarse a partir de los datos u obtenerse de la bibliografía. Podemos

expresar la incertidumbre sobre cuáles son los parámetros correctos de

las distribuciones, suponiendo que las distribuciones tienen parámetros

fijos (_fixed) o si tienen parámetros

variables (_variable). Para entender la

diferencia entre distribuciones fijas y

variables, consideremos el periodo de incubación.

Retrasos y datos

El número de retrasos y su tipo son una entrada flexible que depende de los datos. Los siguientes ejemplos muestran cómo se pueden especificar los retrasos para distintas fuentes de datos:

| Fuente de datos | Retraso(s) |

|---|---|

| Hora de inicio de los síntomas | Periodo de incubación |

| Hora del informe del caso | Periodo de incubación + tiempo desde el inicio de los síntomas hasta la notificación del caso |

| Tiempo de hospitalización | Periodo de incubación + tiempo desde el inicio de los síntomas hasta la hospitalización |

Distribución del periodo de incubación

La distribución del periodo de incubación de muchas enfermedades

suele obtenerse de la bibliografía. El paquete

{epiparameter} contiene una biblioteca de parámetros

epidemiológicos de distintas enfermedades obtenidos de la

literatura.

Especificamos una distribución gamma (fija) con media \(\mu = 4\) y desviación estándar \(\sigma= 2\) (forma = \(4\), escala = \(1\)) mediante la función

Gamma() de la siguiente manera:

R

incubation_period_fixed <- EpiNow2::Gamma(

mean = 4,

sd = 2,

max = 20

)

incubation_period_fixed

SALIDA

- gamma distribution (max: 20):

shape:

4

rate:

1El argumento max es el valor máximo que puede tomar la

distribución, en este ejemplo 20 días.

¿Por qué una distribución gamma?

El periodo de incubación debe tener un valor positivo. Por lo tanto, tenemos que especificar una distribución en EpiNow2 que sea sólo para valores positivos.

Gamma() admite distribuciones Gamma y

LogNormal() Distribuciones logarítmicas normales, que son

distribuciones sólo para valores positivos.

Para todos los tipos de retraso, tendremos que utilizar distribuciones sólo para valores positivos: ¡no queremos incluir retrasos de días negativos en nuestro análisis!

Incluyendo la incertidumbre de distribución

Para especificar una distribución variable, incluimos la incertidumbre en torno a la media \(\mu\) y la desviación estándar \(\sigma\) de nuestra distribución gamma. Si nuestra distribución del periodo de incubación tiene una media \(\mu\) y una desviación estándar \(\sigma\) entonces suponemos que la media (\(\mu\)) sigue una distribución Normal con desviación estándar \(\sigma_{\mu}\):

\[\mbox{Normal}(\mu,\sigma_{\mu}^2)\]

y una desviación estándar (\(\sigma\)) sigue una distribución Normal con desviación estándar \(\sigma_{\sigma}\):

\[\mbox{Normal}(\sigma,\sigma_{\sigma}^2).\]

Lo especificamos utilizando Normal() para cada

argumento: la media (\(\mu=4\) con

\(\sigma_{\mu}=0.5\)) y la desviación

estándar (\(\sigma=2\) con \(\sigma_{\sigma}=0.5\)).

R

incubation_period_variable <- EpiNow2::Gamma(

mean = EpiNow2::Normal(mean = 4, sd = 0.5),

sd = EpiNow2::Normal(mean = 2, sd = 0.5),

max = 20

)

incubation_period_variable

SALIDA

- gamma distribution (max: 20):

shape:

- normal distribution:

mean:

4

sd:

0.61

rate:

- normal distribution:

mean:

1

sd:

0.31Retrasos en los informes

Tras el periodo de incubación, habrá un retraso adicional desde el inicio de los síntomas hasta la notificación del caso: el retraso de notificación. Podemos especificarlo como una distribución fija o variable, o estimar una distribución a partir de los datos.

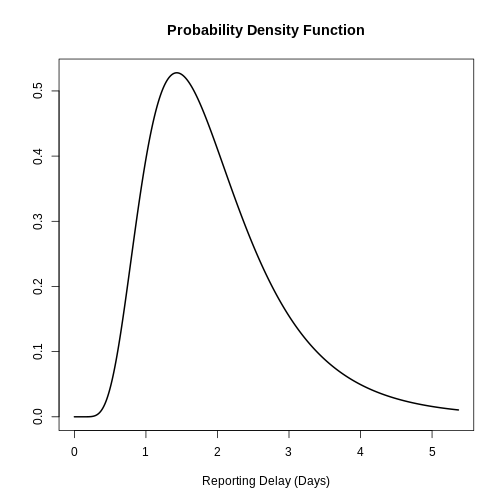

Al especificar una distribución, es útil visualizar la densidad de probabilidad para ver el pico y la dispersión de la distribución, en este caso utilizaremos una log normal logarítmica normal.

Si queremos suponer que la media del retraso en la notificación es de 2 días (con una desviación estándar de 1 día), escribimos:

Utilizando la media y la desviación estándar de la distribución log

normal, podemos especificar una distribución fija o variable utilizando

LogNormal() como antes:

R

reporting_delay_variable <- EpiNow2::LogNormal(

mean = EpiNow2::Normal(mean = 2, sd = 0.5),

sd = EpiNow2::Normal(mean = 1, sd = 0.5),

max = 10

)

Utilizando epiparameter::epidist() podemos crear una

distribución personalizada. La distribución log normal tendrá el

siguiente aspecto:

R

library(epiparameter)

R

epiparameter::epidist(

disease = "covid",

epi_dist = "reporting delay", # retraso del reporte

prob_distribution = "lnorm",

summary_stats = epiparameter::create_epidist_summary_stats(

mean = 2,

sd = 1

)

) %>%

plot()

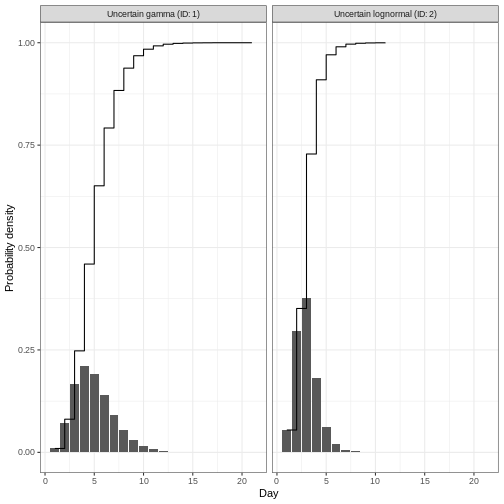

Podemos trazar distribuciones simples y combinadas generadas por

EpiNow2 utilizando plot(). Combinemos en un

gráfico el retraso desde la infección hasta la notificación, que incluye

el periodo de incubación y el retraso en la notificación:

R

plot(incubation_period_variable + reporting_delay_variable)

Aviso

Si disponemos de datos sobre el tiempo transcurrido entre el inicio

de los síntomas y la notificación, podemos utilizar la función

estimate_delay() para estimar una distribución log normal a

partir de un vector de retrasos. El siguiente código muestra cómo

utilizar estimate_delay() con datos sintéticos de

retrasos.

R

delay_data <- rlnorm(500, log(5), 1) # datos de retraso sintéticos

reporting_delay <- EpiNow2::estimate_delay(

delay_data,

samples = 1000,

bootstraps = 10

)

Tiempo de generación

También debemos especificar una distribución para el tiempo de generación. Aquí utilizaremos una distribución log normal con media 3.6 y desviación estándar 3.1 (Ganyani et al. 2020).

R

generation_time_variable <- EpiNow2::LogNormal(

mean = EpiNow2::Normal(mean = 3.6, sd = 0.5),

sd = EpiNow2::Normal(mean = 3.1, sd = 0.5),

max = 20

)

Estimaciones de hallazgos

La función epinow() es una envoltura de la función

estimate_infections() utilizada para estimar los casos por

fecha de infección. La distribución del tiempo de generación y las

distribuciones del retraso deben pasarse utilizando las funciones

generation_time_opts() y delay_opts()

respectivamente.

Hay muchas otras entradas que se pueden pasar a epinow()

ver ?EpiNow2::epinow() para más detalles. Una entrada

opcional es especificar una log normal para el número de

reproducción efectivo \(R_t\) al inicio

del brote. Especificamos una media de 2 días y una desviación estándar

de 2 días como argumentos de prior dentro de

rt_opts():

R

# define Rt prior distribution

rt_prior <- EpiNow2::rt_opts(prior = base::list(mean = 2, sd = 2))

Inferencia bayesiana con Stan

La inferencia bayesiana se realiza utilizando métodos MCMC con el

programa Stan. Hay una serie de

entradas por defecto para las funciones Stan, incluido el número de

cadenas y el número de muestras por cadena (ver

?EpiNow2::stan_opts()).

Para reducir el tiempo de cálculo, podemos ejecutar las cadenas en

paralelo. Para ello, debemos establecer el número de núcleos que se van

a utilizar. Por defecto, se ejecutan 4 cadenas MCMC (ver

stan_opts()$chains), por lo que podemos establecer un

número igual de núcleos para que se utilicen en paralelo de la siguiente

manera:

R

withr::local_options(base::list(mc.cores = 4))

Para averiguar el número máximo de núcleos disponibles en tu máquina,

utiliza parallel::detectCores().

Lista de verificación

Nota: En el siguiente código _fixed se

utilizan distribuciones en lugar de _variable

(distribuciones de retraso con incertidumbre). Esto se hace para

acelerar el tiempo de cálculo. En general, se recomienda utilizar

distribuciones variables que tengan en cuenta la incertidumbre

adicional.

R

# alternativas: distribuciones con parámetros fijos

generation_time_fixed <- EpiNow2::LogNormal(

mean = 3.6,

sd = 3.1,

max = 20

)

reporting_delay_fixed <- EpiNow2::LogNormal(

mean = 2,

sd = 1,

max = 10

)

Ahora estás listo para ejecutar EpiNow2::epinow() para

estimar el número de reproducción variable en el tiempo durante los

primeros 90 días:

R

reported_cases <- cases %>%

dplyr::slice_head(n = 90)

R

estimates <- EpiNow2::epinow(

# casos

data = reported_cases,

# retrasos

generation_time = EpiNow2::generation_time_opts(generation_time_fixed),

delays = EpiNow2::delay_opts(incubation_period_fixed + reporting_delay_fixed),

# prior

rt = rt_prior

)

No esperes a que esto continúe

Para efectos de este tutorial, podemos utilizar opcionalmente

EpiNow2::stan_opts() para reducir el tiempo de cálculo.

Podemos especificar un número fijo de samples = 1000 y

chains = 3 al argumento stan de la función

EpiNow2::epinow(). Esperamos que esto lleve aproximadamente

3 minutos.

R

# puedes adicionar el argumento `stan`

EpiNow2::epinow(

...,

stan = EpiNow2::stan_opts(samples = 1000, chains = 3)

)

Recuerda: Utilizar un número adecuado de muestras y cadenas es crucial para garantizar la convergencia y obtener estimaciones fiables en los cálculos bayesianos con Stan. Los resultados más precisos se obtienen a costa de la velocidad.

Resultados

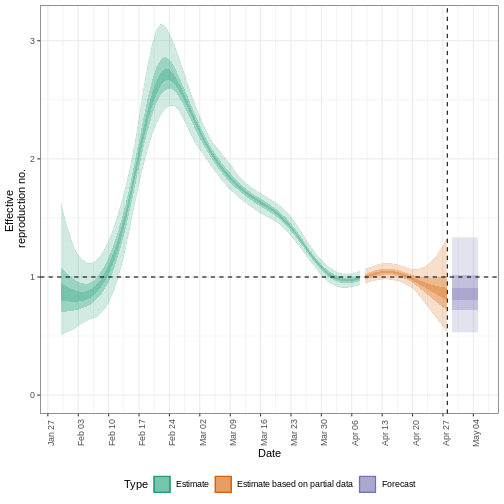

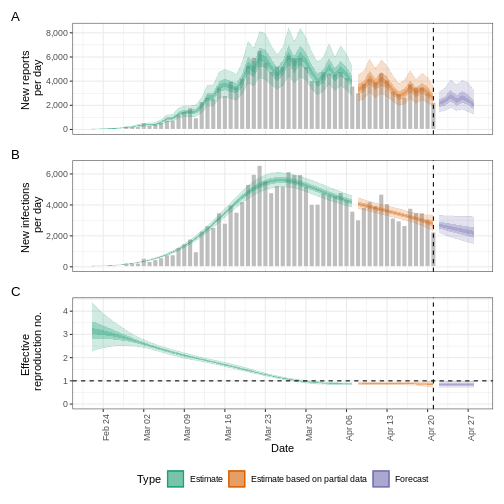

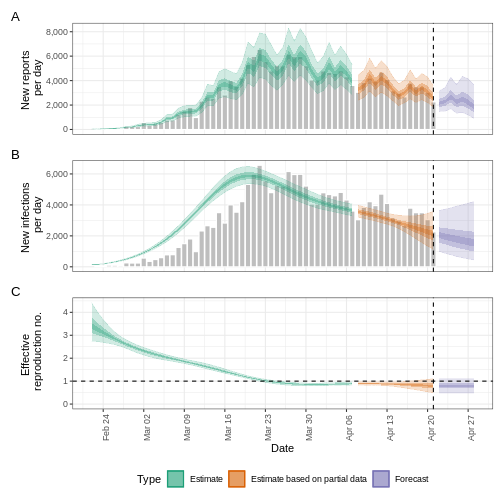

Podemos extraer y visualizar estimaciones del número de reproducción efectivo a lo largo del tiempo:

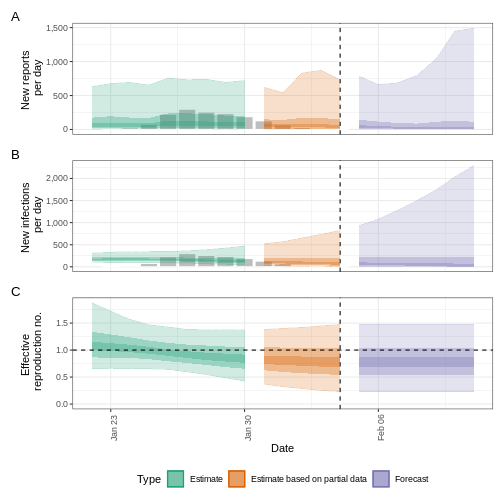

R

estimates$plots$R

La incertidumbre de las estimaciones aumenta con el tiempo. Esto se debe a que las estimaciones se basan en datos del pasado, dentro de los periodos de retraso. Esta diferencia de incertidumbre se clasifica en Estimación (verde) utiliza todos los datos y Estimación basada en datos parciales (naranja) estimaciones que se basan en menos datos (porque es más probable que las infecciones que se produjeron en su momento no se hayan observado todavía), por este motivo, tienen intervalos cada vez más amplios hacia la fecha del último punto de datos. Por último, el Pronóstico (morado) es una proyección a futuro.

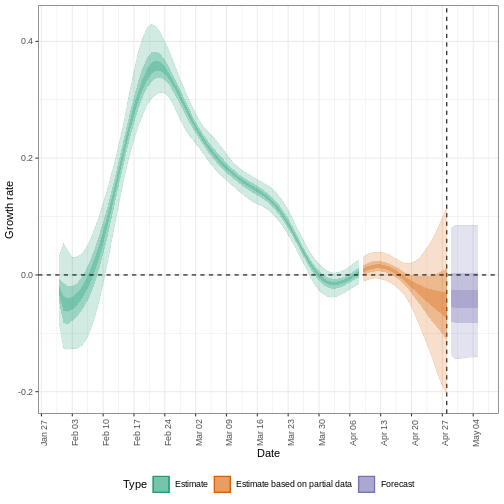

También podemos visualizar la estimación de la tasa de crecimiento a lo largo del tiempo:

R

estimates$plots$growth_rate

Para extraer un resumen de las métricas clave de transmisión en la última fecha de los datos:

R

summary(estimates)

SALIDA

measure estimate

<char> <char>

1: New infections per day 6476 (2738 -- 13517)

2: Expected change in daily reports Likely decreasing

3: Effective reproduction no. 0.87 (0.51 -- 1.3)

4: Rate of growth -0.046 (-0.22 -- 0.11)

5: Doubling/halving time (days) -15 (6.4 -- -3.2)Como estas estimaciones se basan en datos parciales, tienen un amplio intervalo de incertidumbre.

Del resumen de nuestro análisis se desprende que el cambio esperado en los casos diarios es de con la estimación de nuevos casos confirmados .

El número de reproducción efectivo \(R_t\) estimado (en la última fecha de los datos) es 0.87 (0.51 – 1.3).

La tasa de crecimiento exponencial del número de casos es -0.046 (-0.22 – 0.11).

El tiempo de duplicación (el tiempo que tarda en duplicarse el número de casos) es -15 (6.4 – -3.2).

Expected change in daily cases

Un factor que describe el cambio esperado en los casos diarios, basado en la probabilidad posterior de que \(R_t < 1\).

| Probabilidad (\(p\)) | Cambio esperado |

|---|---|

| \(p < 0,05\) | Aumentando |

| \(0,05 \leq p< 0,4\) | Probable aumento |

| \(0,4 \leq p< 0,6\) | Estable |

| \(0,6 \leq p < 0,95\) | Probable disminución |

| \(0,95 \leq p \leq 1\) | En disminución |

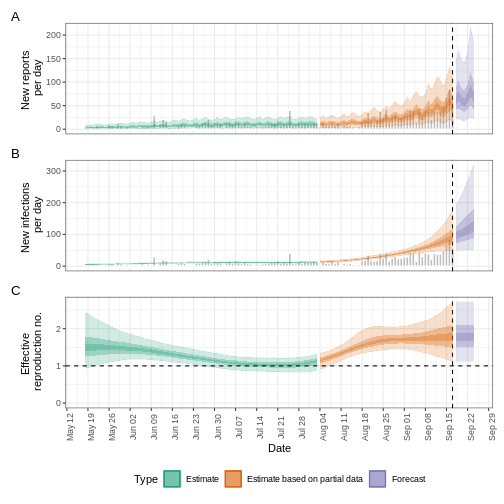

Cuantificar la heterogeneidad geográfica

Los datos del brote del inicio de la pandemia COVID-19 del Reino Unido del paquete R incidence2 incluyen la región en la que se registraron los casos. Para encontrar estimaciones regionales del número de reproducción efectiva y de casos, debemos dar formato a los datos para que tengan tres columnas:

-

date: la fecha. -

region: la región. -

confirm: número de casos confirmados para una región en una fecha determinada.

R

regional_cases <- incidence2::covidregionaldataUK %>%

# usar {tidyr} para pre-procesar los valores faltantes

tidyr::replace_na(base::list(cases_new = 0)) %>%

# usar {incidence2} para convertir datos agregados en datos de incidencia

incidence2::incidence(

date_index = "date",

groups = "region",

counts = "cases_new",

count_values_to = "confirm",

date_names_to = "date",

complete_dates = TRUE

) %>%

dplyr::select(-count_variable)

# mantener las primeras 90 fechas para todas las regiones

# obtener el vector de las primeras 90 fechas

date_range <- regional_cases %>%

dplyr::distinct(date) %>%

# desde {incidence2}, las fechas ya están ordenadas en orden ascendente

dplyr::slice_head(n = 90) %>%

dplyr::pull(date)

# filtrar las fechas en la variable date_range

regional_cases <- regional_cases %>%

dplyr::filter(magrittr::is_in(x = date, table = date_range))

dplyr::as_tibble(regional_cases)

SALIDA

# A tibble: 1,170 × 3

date region confirm

<date> <chr> <dbl>

1 2020-01-30 East Midlands 0

2 2020-01-30 East of England 0

3 2020-01-30 England 2

4 2020-01-30 London 0

5 2020-01-30 North East 0

6 2020-01-30 North West 0

7 2020-01-30 Northern Ireland 0

8 2020-01-30 Scotland 0

9 2020-01-30 South East 0

10 2020-01-30 South West 0

# ℹ 1,160 more rowsPara hallar las estimaciones regionales, utilizamos los mismos datos

que epinow() para la función

regional_epinow():

R

estimates_regional <- EpiNow2::regional_epinow(

# casos

data = regional_cases,

# retrasos

generation_time = EpiNow2::generation_time_opts(generation_time_fixed),

delays = EpiNow2::delay_opts(incubation_period_fixed + reporting_delay_fixed),

# prior

rt = rt_prior

)

SALIDA

INFO [2024-11-19 01:34:09] Producing following optional outputs: regions, summary, samples, plots, latest

INFO [2024-11-19 01:34:09] Reporting estimates using data up to: 2020-04-28

INFO [2024-11-19 01:34:09] No target directory specified so returning output

INFO [2024-11-19 01:34:09] Producing estimates for: East Midlands, East of England, England, London, North East, North West, Northern Ireland, Scotland, South East, South West, Wales, West Midlands, Yorkshire and The Humber

INFO [2024-11-19 01:34:09] Regions excluded: none

INFO [2024-11-19 02:31:34] Completed regional estimates

INFO [2024-11-19 02:31:34] Regions with estimates: 13

INFO [2024-11-19 02:31:34] Regions with runtime errors: 0

INFO [2024-11-19 02:31:34] Producing summary

INFO [2024-11-19 02:31:34] No summary directory specified so returning summary output

INFO [2024-11-19 02:31:34] No target directory specified so returning timingsR

estimates_regional$summary$summarised_results$table

SALIDA

Region New infections per day

<char> <char>

1: East Midlands 346 (185 -- 618)

2: East of England 483 (258 -- 857)

3: England 3163 (1598 -- 5887)

4: London 291 (167 -- 486)

5: North East 239 (108 -- 493)

6: North West 515 (256 -- 938)

7: Northern Ireland 37 (15 -- 101)

8: Scotland 272 (108 -- 769)

9: South East 588 (300 -- 1099)

10: South West 469 (304 -- 726)

11: Wales 81 (46 -- 133)

12: West Midlands 202 (83 -- 451)

13: Yorkshire and The Humber 444 (224 -- 816)

Expected change in daily reports Effective reproduction no.

<fctr> <char>

1: Likely increasing 1.1 (0.77 -- 1.4)

2: Stable 1 (0.69 -- 1.3)

3: Likely decreasing 0.87 (0.58 -- 1.2)

4: Likely decreasing 0.89 (0.66 -- 1.2)

5: Likely decreasing 0.91 (0.59 -- 1.3)

6: Likely decreasing 0.87 (0.58 -- 1.2)

7: Likely decreasing 0.75 (0.43 -- 1.3)

8: Stable 0.95 (0.55 -- 1.7)

9: Stable 0.98 (0.65 -- 1.4)

10: Increasing 1.3 (1 -- 1.6)

11: Decreasing 0.7 (0.49 -- 0.94)

12: Likely decreasing 0.68 (0.38 -- 1.1)

13: Likely decreasing 0.93 (0.63 -- 1.3)

Rate of growth Doubling/halving time (days)

<char> <char>

1: 0.022 (-0.099 -- 0.12) 31 (5.6 -- -7)

2: -0.0081 (-0.14 -- 0.1) -86 (6.9 -- -5.1)

3: -0.046 (-0.18 -- 0.084) -15 (8.3 -- -3.8)

4: -0.029 (-0.13 -- 0.069) -24 (10 -- -5.2)

5: -0.027 (-0.17 -- 0.11) -26 (6.5 -- -4)

6: -0.043 (-0.17 -- 0.064) -16 (11 -- -4.1)

7: -0.071 (-0.24 -- 0.13) -9.7 (5.5 -- -2.9)

8: -0.0099 (-0.18 -- 0.21) -70 (3.2 -- -3.9)

9: -0.0096 (-0.15 -- 0.12) -73 (5.8 -- -4.6)

10: 0.079 (-0.0084 -- 0.17) 8.8 (4 -- -82)

11: -0.093 (-0.2 -- 0.0083) -7.5 (83 -- -3.5)

12: -0.11 (-0.28 -- 0.074) -6.1 (9.3 -- -2.5)

13: -0.028 (-0.17 -- 0.092) -24 (7.5 -- -4.2)R

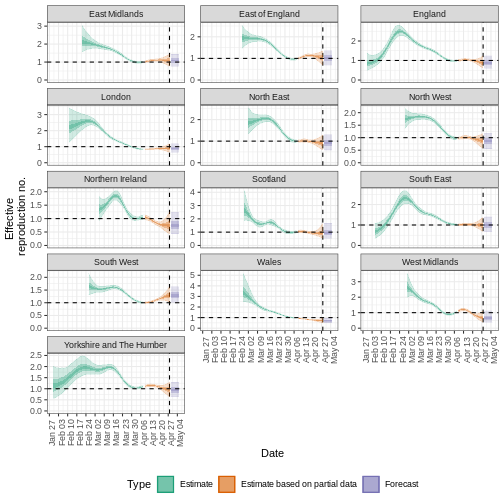

estimates_regional$summary$plots$R

Resumen

EpiNow2 puede utilizarse para estimar las métricas de

transmisión a partir de los datos de casos en cualquier momento del

curso de un brote. La fiabilidad de estas estimaciones depende de la

calidad de los datos y de la elección adecuada de las distribuciones de

retraso. En el siguiente tutorial aprenderemos a hacer previsiones e

investigaremos algunas de las opciones adicionales de inferencia

disponibles en EpiNow2.

Puntos Clave

- Las métricas de transmisión pueden estimarse a partir de los datos del caso tras tener en cuenta los retrasos

- La incertidumbre puede tenerse en cuenta en las distribuciones de retrasos

Content from Utilizar distribuciones de retraso en el análisis

Última actualización: 2024-11-19 | Mejora esta página

Hoja de ruta

Preguntas

- ¿Cómo reutilizar los retrasos almacenados en el paquete

{epiparameter}con mi flujo de análisis existente?

Objetivos

- Utilizar funciones de distribución para distribuciones continuas y

discretas almacenadas como objetos

<epidist>. - Convertir una distribución continua en discreta con

{epiparameter}. - Conectar las salidas de

{epiparameter}con entradas de EpiNow2.

Requisitos previos

- Completar el tutorial Cuantificar la transmisión

Este episodio requiere que estés familiarizado con:

Ciencia de datos : Programación básica con R.

Estadística : Distribuciones de probabilidad.

Teoría epidémica Parámetros epidemiológicos, periodos de tiempo, número reproductivo efectivo.

Introducción

{epiparameter} nos ayuda a elegir un conjunto

específico de parámetros epidemiológicos de la bibliografía, en lugar de

copiarlos/pegarlos a mano:

R

covid_serialint <-

epiparameter::epidist_db(

disease = "covid",

epi_dist = "serial",

author = "Nishiura",

single_epidist = TRUE

)

¡Ahora tenemos un parámetro epidemiológico que podemos utilizar en

nuestro análisis! En el bloque de abajo hemos sustituido uno de los

parámetros de estadísticas de resumen por

EpiNow2::LogNormal()

R

generation_time <-

EpiNow2::LogNormal(

mean = covid_serialint$summary_stats$mean, # replaced!

sd = covid_serialint$summary_stats$sd, # replaced!

max = 20

)

En este episodio, utilizaremos las funciones de

distribución que {epiparameter} proporciona para

obtener un valor máximo (max) para este y cualquier otro

paquete aguas abajo en tu flujo de análisis.

Carguemos los paquetes {epiparameter} y

EpiNow2. En EpiNow2 estableceremos 4

núcleos para utilizarlos en cálculos paralelos. Utilizaremos el operador

pipe %>%, algunos verbos de

dplyr y ggplot2, así que llamemos también

al paquete tidyverse:

R

library(epiparameter)

library(EpiNow2)

library(tidyverse)

withr::local_options(list(mc.cores = 4))

El doble punto

El doble punto :: en R te permite llamar a una función

específica de un paquete sin cargar todo el paquete en el entorno

actual.

Por ejemplo dplyr::filter(data, condition) utiliza

filter() del paquete dplyr.

Esto nos ayuda a recordar las funciones del paquete y a evitar conflictos con los nombres de las funciones.

Funciones de distribución

En R, todas las distribuciones estadísticas tienen funciones para acceder a lo siguiente:

-

density(): Función de densidad de probabilidad (PDF, por sus siglas en inglés), -

cdf(): Función de distribución acumulada (CDF, por sus siglas en inglés), -

quantile(): Cuantil y -

generate(): Generar valores aleatorios de la distribución dada.

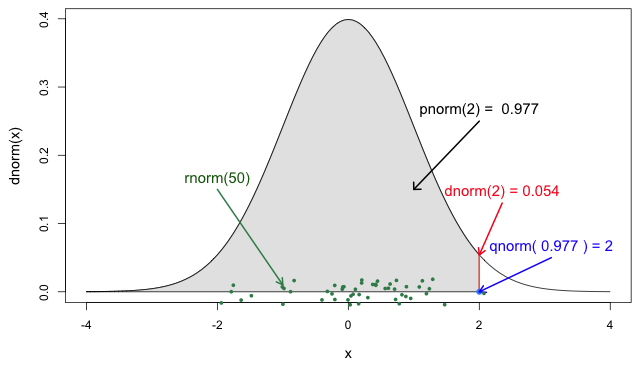

Funciones para la distribución Normal

Si lo necesitas, ¡lee en detalle acerca de las funciones de probabilidad de R para la distribución normal, cada una de sus definiciones e identifica en qué parte de una distribución se encuentran!

Si consultas ?stats::Distributions, cada tipo de

distribución tiene un conjunto único de funciones. Sin embargo,

¡{epiparameter} te ofrece las mismas cuatro funciones para

acceder a cada uno de los valores anteriores para cualquier objeto

<epidist> que quieras!

R

# Grafica esto para tener una imagen de referencia

plot(covid_serialint, day_range = 0:20)

R

# El valor de densidad cuando el cuantil tiene un valor de 10 (días)

density(covid_serialint, at = 10)

SALIDA

[1] 0.01911607R

# La probabilidad acumulada cuando el cuantil tiene un valor de 10 (días)

cdf(covid_serialint, q = 10)

SALIDA

[1] 0.9466605R

# El valor del cuantil (día) cuando la probabilidad acumulada es 60%

quantile(covid_serialint, p = 0.6)

SALIDA

[1] 4.618906R

# Generar 10 valores aleatorios (días) dada una familia de distribuciones y

# sus parámetros

generate(covid_serialint, times = 10)

SALIDA

[1] 5.702350 8.846805 4.247009 10.232628 7.698895 4.088730 12.172251

[8] 4.556690 5.119388 2.796879Ventana para el rastreo de contactos y el intervalo en serie

El intervalo serial es importante en la optimización del rastreo de contactos, ya que proporciona una ventana temporal para la contención de la propagación de una enfermedad (Fine, 2003). A partir del intervalo serial, podemos evaluar la necesidad de ampliar el número de días previos a tener en cuenta para iniciar el rastreo de contactos e incluir más contactos retrospectivos (Davis et al., 2020).

Con el intervalo de serie COVID-19 (covid_serialint)

calcula:

- ¿Cuántos más casos atrasados se podrían captar si el método de rastreo de contactos considerara los contactos de hasta 6 días antes del inicio en comparación con los de 2 días antes del inicio?

En la Figura 5 de las funciones

de probabilidad de R para la distribución normal, la sección

sombreada representa una probabilidad acumulada de 0.997

para el valor del cuantil en x = 2.

R

plot(covid_serialint)

R

cdf(covid_serialint, q = 2)

SALIDA

[1] 0.1111729R

cdf(covid_serialint, q = 6)

SALIDA

[1] 0.7623645Dado el intervalo de serie COVID-19:

Un método de rastreo de contactos que considere los contactos hasta 2 días antes del inicio captará alrededor del 11,1% de los casos retrospectivos.

Si este periodo se amplía a 6 días antes del inicio, se podría incluir el 76,2% de los contactos retrospectivos.

intercambiamos la pregunta entre días y probabilidad acumulada a:

- Al considerar los casos secundarios, ¿cuántos días después del inicio de los síntomas de los casos primarios podemos esperar que se produzca un 55% de inicio de los síntomas?

R

quantile(covid_serialint, p = 0.55)

Una interpretación podría ser

- El 55% del inicio de los síntomas de los casos secundarios ocurrirá después de 4,2 días del inicio de los síntomas de los casos primarios.

Discretizar una distribución continua

¡Nos acercamos al final! EpiNow2::LogNormal() todavía

necesita un valor máximo (max).

Una forma de hacerlo es obtener el valor del cuantil del percentil 99

de la distribución o la probabilidad acumulada de 0.99 .

Para ello, necesitamos acceder al conjunto de funciones de distribución

de nuestro objeto <epidist>.

Podemos utilizar el conjunto de funciones de distribución de una

distribución continua (como arriba). Sin embargo, estos valores

serán continuos. Podemos discretizar la

distribución continua almacenada en nuestro objeto

<epidist> para obtener valores discretos a partir de

una distribución continua.

Cuando usamos epiparameter::discretise() sobre la

distribución continua, obtenemos una distribución

discreta (o discretizada):

R

covid_serialint_discrete <-

epiparameter::discretise(covid_serialint)

covid_serialint_discrete

SALIDA

Disease: COVID-19

Pathogen: SARS-CoV-2

Epi Distribution: serial interval

Study: Nishiura H, Linton N, Akhmetzhanov A (2020). "Serial interval of novel

coronavirus (COVID-19) infections." _International Journal of

Infectious Diseases_. doi:10.1016/j.ijid.2020.02.060

<https://doi.org/10.1016/j.ijid.2020.02.060>.

Distribution: discrete lnorm

Parameters:

meanlog: 1.386

sdlog: 0.568Identificamos este cambio en la línea de salida

Distribution: del objeto <epidist>.

Comprueba de nuevo esta línea:

Distribution: discrete lnormMientras que para una distribución continua trazamos la Función de densidad de probabilidad (PDF) para una distribución discreta, trazamos la función de masa de probabilidad (PMF):

R

# continua

plot(covid_serialint)

# discreta

plot(covid_serialint_discrete)

Para obtener finalmente un valor máximo (max), accedamos

al valor del cuantil del percentil 99 o cuando la probabilidad acumulada

es 0.99 usando prob_dist$q de forma similar a

como accedemos a los valores de estadísticas de resumen

(summary_stats).

R

covid_serialint_discrete_max <-

quantile(covid_serialint_discrete, p = 0.99)

Duración del periodo de cuarentena e incubación

El periodo de incubación es un retraso útil para evaluar la duración de la vigilancia activa o la cuarentena (Lauer et al., 2020). Del mismo modo, los retrasos desde la aparición de los síntomas hasta la recuperación (o la muerte) determinarán la duración necesaria de la asistencia sanitaria y el aislamiento del caso (Cori et al., 2017).

Calcula:

- ¿En qué plazo exacto de tiempo el 99% de las personas que presentan síntomas de COVID-19 después de la infección los presentan?

¿Qué distribución del retraso mide el tiempo entre la infección y la aparición de los síntomas?

¡Las funciones de probabilidad discretas para

<epidist> son las mismas que utilizamos para las

continuas!

R

# Grafica esto para tener una imagen de referencia

plot(covid_serialint_discrete, day_range = 0:20)

# El valor de la densidad cuando el cuantil tiene un valor de 10 (días)

density(covid_serialint_discrete, at = 10)

# La probabilidad acumulada cuando el cuantil tiene un valor de 10 (días)

cdf(covid_serialint_discrete, q = 10)

# El valor del cuantil (días) cuando la probabilidad acumulada es 60%

quantile(covid_serialint_discrete, p = 0.6)

# Generar valores aleatorios

generate(covid_serialint_discrete, times = 10)

R

covid_incubation <-

epiparameter::epidist_db(

disease = "covid",

epi_dist = "incubation",

single_epidist = TRUE

)

SALIDA

Using Linton N, Kobayashi T, Yang Y, Hayashi K, Akhmetzhanov A, Jung S, Yuan

B, Kinoshita R, Nishiura H (2020). "Incubation Period and Other

Epidemiological Characteristics of 2019 Novel Coronavirus Infections

with Right Truncation: A Statistical Analysis of Publicly Available

Case Data." _Journal of Clinical Medicine_. doi:10.3390/jcm9020538

<https://doi.org/10.3390/jcm9020538>..

To retrieve the citation use the 'get_citation' functionR

covid_incubation_discrete <- epiparameter::discretise(covid_incubation)

quantile(covid_incubation_discrete, p = 0.99)

SALIDA

[1] 19El 99% de los que desarrollan síntomas de COVID-19 lo harán en los 16 días posteriores a la infección.

Ahora, ¿es esperable este resultado en términos epidemiológicos?

A partir de un valor máximo con quantile() podemos crear

una secuencia de valores de cuantiles como un vector numérico y calcular

density() para cada uno:

R

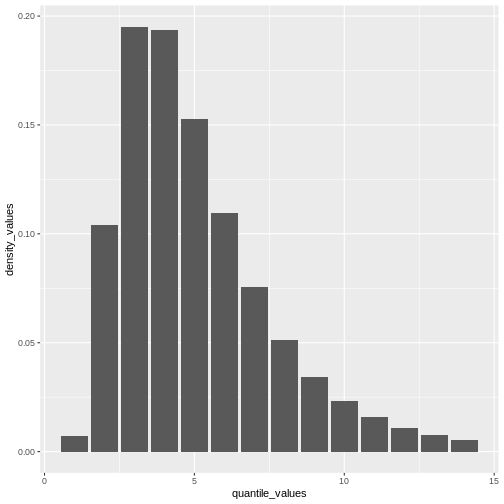

# Crear la visualización para una distribución discreta

# a partir de un valor máximo de la distribución

quantile(covid_serialint_discrete, p = 0.99) %>%

# Generar un vector de cuantiles

# como una secuencia para cada número natural

seq(1L, to = ., by = 1L) %>%

# Convertir el vector numérico en un data.frame (tibble)

as_tibble_col(column_name = "quantile_values") %>%

mutate(

# Calcular los valores de densidad

# para cada cuantul en la función de densidad

density_values =

density(

x = covid_serialint_discrete,

at = quantile_values

)

) %>%

# Graficar

ggplot(

aes(

x = quantile_values,

y = density_values

)

) +

geom_col()

Recuerda: En las infecciones con transmisión presintomática, los intervalos seriales pueden tener valores negativos (Nishiura et al., 2020). ¡Cuando utilizamos el intervalo serial para aproximar el tiempo de generación necesitamos hacer esta distribución sólo con valores positivos!

Plug-in {epiparameter} a {EpiNow2}

¡Ahora podemos introducirlo todo en la función

EpiNow2::LogNormal()!

- Las estadísticas de resumen: media

(

mean) y desviación estándar (sd) de la distribución, - un valor máximo (

max), - el nombre de la distribución (

distribution).

Cuando utilices EpiNow2::LogNormal() para definir una

distribución log normal como la del intervalo serial

del COVID-19 (covid_serialint) podemos especificar la media

(mean) y la desviación estándar (sd) como

parámetros. Alternativamente, para obtener los parámetros “naturales” de

una distribución log normal podemos convertir sus estadísticos de

resumen en parámetros de distribución denominados meanlog y

sdlog. Con {epiparameter} podemos obtener

directamente los parámetros de la distribución utilizando

epiparameter::get_parameters():

R

covid_serialint_parameters <-

epiparameter::get_parameters(covid_serialint)

Entonces, tenemos:

R

serial_interval_covid <-

EpiNow2::LogNormal(

meanlog = covid_serialint_parameters["meanlog"],

sdlog = covid_serialint_parameters["sdlog"],

max = covid_serialint_discrete_max

)

serial_interval_covid

SALIDA

- lognormal distribution (max: 14):

meanlog:

1.4

sdlog:

0.57Suponiendo un escenario con COVID-19, utilicemos los primeros 60 días

del conjunto de datos example_confirmed del paquete

EpiNow2 como casos

reportados(reported_cases) y el recientemente creado

intervalo serial COVID (serial_interval_covid) como

entradas para estimar el número reproductivo variable en el tiempo

utilizando EpiNow2::epinow().

R

epinow_estimates_cg <- epinow(

# casos

data = example_confirmed[1:60],

# retrasos

generation_time = generation_time_opts(serial_interval_covid)

)

SALIDA

WARN [2024-11-19 02:33:14] epinow: There were 2 divergent transitions after warmup. See

https://mc-stan.org/misc/warnings.html#divergent-transitions-after-warmup

to find out why this is a problem and how to eliminate them. -

WARN [2024-11-19 02:33:14] epinow: Examine the pairs() plot to diagnose sampling problems

- R

base::plot(epinow_estimates_cg)

plot() incluye los casos estimados por fecha de

infección, que se reconstruyen a partir de los casos notificados y los

retrasos.

Advertencia

Utilizar el intervalo serial en lugar del tiempo de generación es una alternativa que puede propagar sesgos en tus estimaciones, más aún en enfermedades con transmisión presintomática reportada. (Chung Lau et al., 2021)

Ajuste por retrasos en la notificación

Estimar \(R_t\) requiere datos sobre el número diario de nuevas infecciones. Debido a los retrasos en el desarrollo de cargas víricas detectables, la aparición de síntomas, la búsqueda de atención sanitaria y la notificación, estas cifras no están fácilmente disponibles. Todas las observaciones reflejan eventos de transmisión de algún momento del pasado. En otras palabras, si \(d\) es el tiempo transcurrido desde la infección hasta la observación, las observaciones en el momento \(t\) informan a \(R_{t−d}\) no \(R_t\). (Gostic et al., 2020)

La distribución del retraso podría inferirse

conjuntamente con los tiempos de infección subyacentes o estimarse como

la suma del periodo de

incubación y la distribución de los retrasos desde el inicio de los

síntomas hasta la observación a partir de los datos (retraso en la notificación). En

EpiNow2 podemos especificar estas dos distribuciones de

retraso complementarias con el argumento delays.

Utiliza un periodo de incubación de COVID-19 para estimar Rt

Estima el número reproductivo variable en el tiempo para los primeros

60 días del conjunto de datos example_confirmed de

EpiNow2. Accede a un periodo de incubación para COVID-19

a partir de {epiparameter} para utilizarlo como retraso de

notificación.

Utiliza el último cálculo de epinow() usando el

argumento delays y la función auxiliar

delay_opts().

El argumento delays y la función auxiliar

delay_opts() son análogos al argumento

generation_time y la función auxiliar

generation_time_opts().

R

epinow_estimates <- epinow(

# casos

reported_cases = example_confirmed[1:60],

# retrasos

generation_time = generation_time_opts(covid_serial_interval),

delays = delay_opts(covid_incubation_time)

)

R

# Tiempo de generación ---------------------------------------------------------

# Intervalo serial covid

covid_serialint <-

epiparameter::epidist_db(

disease = "covid",

epi_dist = "serial",

author = "Nishiura",

single_epidist = TRUE

)

# adaptar epidist para epinow2

covid_serialint_discrete_max <- covid_serialint %>%

epiparameter::discretise() %>%

quantile(p = 0.99)

covid_serialint_parameters <-

epiparameter::get_parameters(covid_serialint)

covid_serial_interval <-

EpiNow2::LogNormal(

meanlog = covid_serialint_parameters["meanlog"],

sdlog = covid_serialint_parameters["sdlog"],

max = covid_serialint_discrete_max

)

# Periodo de incubación -------------------------------------------------------

# Periodo de incubación

covid_incubation <- epiparameter::epidist_db(

disease = "covid",

epi_dist = "incubation",

author = "Natalie",

single_epidist = TRUE

)

# Adaptar epiparameter para epinow2

covid_incubation_discrete_max <- covid_incubation %>%

epiparameter::discretise() %>%

quantile(p = 0.99)

covid_incubation_parameters <-

epiparameter::get_parameters(covid_incubation)

covid_incubation_time <-

EpiNow2::LogNormal(

meanlog = covid_incubation_parameters["meanlog"],

sdlog = covid_incubation_parameters["sdlog"],

max = covid_incubation_discrete_max

)

# epinow ------------------------------------------------------------------

# usar epinow

epinow_estimates_cgi <- epinow(

# casos

data = example_confirmed[1:60],

# retrasos

generation_time = generation_time_opts(covid_serial_interval),

delays = delay_opts(covid_incubation_time)

)

SALIDA

WARN [2024-11-19 02:34:51] epinow: There were 11 divergent transitions after warmup. See

https://mc-stan.org/misc/warnings.html#divergent-transitions-after-warmup

to find out why this is a problem and how to eliminate them. -

WARN [2024-11-19 02:34:51] epinow: Examine the pairs() plot to diagnose sampling problems

- R

base::plot(epinow_estimates_cgi)

Intenta complementar el argumento delays con un retraso

de notificación como el objeto reporting_delay_fixed del

episodio anterior.

¿Cuánto ha cambiado?

Tras añadir el periodo de incubación, debata acerca de:

- ¿Cambia la tendencia del ajuste del modelo en la sección estimación (“Estimate”)?

- ¿Ha cambiado la incertidumbre?

- ¿Cómo explicaría o interpretaría estos cambios?

Compara todas las figuras generadas con EpiNow2 anteriormente.

Desafíos

Un consejo para completar código

Si escribimos el [ ] luego del objeto

covid_serialint_parameters[ ], dentro de [ ]

podemos utilizar el la tecla Tab en el teclado ↹ para usar la

función

de completado de código

Usar esto permite acceder rápidamente a

covid_serialint_parameters["meanlog"] y

covid_serialint_parameters["sdlog"].

¡Te invitamos a probarlo en otros bloques de código y en la consola de R!

Número de reproducción efectiva del ébola ajustado por retrasos en la notificación

Descarga y lee el conjunto de datos de ébola:

- Estime el número reproductivo efectivo utilizando EpiNow2

- Ajuste la estimación según los retrasos de notificación disponibles

en

{epiparameter} - ¿Por qué eligió ese parámetro?

Para calcular el \(R_t\) utilizando EpiNow2 necesitamos